Updated at 2025-05-02 03:30:41.045288

Журнал изменений

На этой странице находится актуальная информация о версиях Tarantool Data Grid.

Формат журнала изменений основан на документе Keep a Changelog,

а версионирование следует правилам Semantic Versioning.

SDK обновлен до версии 2.11.4-0-r658.

Расширена информация о клиенте, записываемая в журнал аудита при неудачных

попытках авторизации.

Исправлена возможность обновления необнуляемого элемента массива на null.

Убран sandboxing из функции, использующейся при миграции спейсов.

Теперь можно использовать произвольные функции Lua/Tarantool.

Исправлена ошибка при запуске миграций в режиме dry_run.

Исправлена некорректная обработка спанов при включенном трейсинге

при ошибке обработки объектов из Kafka.

[Breaking change] Базовый образ для сборки проекта обновлен с CentOS 7 до AlmaLinux 8.

Теперь проект может не работать на более старых дистрибутивах.

[Breaking change] Отключено сопоставление с Lua-шаблоном при поиске содержимого сообщений журнала.

Удалить поле из модели данных теперь можно без запуска миграции.

Исправлены ошибки, возникающие при обновлении полей-массивов.

Kafka consumer теперь логирует offset сообщения в случае возникновения проблем.

Исправлена ошибка, возникающая при запуске миграций в режиме dry_run для спейсов с отключенным версионированием.

Cartridge обновлен до версии 2.12.3.

metrics обновлен до версии 1.2.0.

Добавлен метод connector.http_request в sandbox.

Добавлена подсистема событий events.

Исправлено разыменование nil (nil dereference) при перезагрузке конфигурации в Kafka-клиенте.

Исправлена обработка ошибок маршрутизации.

Исправлен расчет размера журнала TDG (спейса tdg_log).

Добавлен доступ к странице веб-интерфейса Console для пользователей с

привилегией eval.

Cartridge обновлен до версии 2.12.0.

SDK обновлен до версии 2.11.3-0-r636.

Исправлена ошибка: account provider watcher печатал ошибку при инициализации.

Cartridge обновлен до версии 2.10.0.

expirationd обновлен до версии 1.6.0.

SDK обновлен до версии 2.11.3-0-r631.

Добавлен фильтр полей для запросов на получение данных.

Исправлена ошибка table is nil в обнуляемом поле записи.

Исправлена ошибка vshard gc при балансировке.

Исправлена ошибка, связанная с передачей значений cdata в метрики.

Исправлено использование типа Union совместно с массивами.

Исправлено значение версии по умолчанию для схемы GraphQL.

Исправлена нумерация версий PRM-пакета.

Исправлено переполнение в значениях дат.

SDK обновлен до версии 2.11.2-0-r621.

Cartridge обновлен до версии 2.9.0.

[Breaking change] Изменен формат ошибок некоторых функций Repository API.

Добавлена возможность указания заголовков (headers) для Kafka-коннектора.

Исправлено некорректное отображение версии продукта при использовании Docker-образа.

Исправлена обработка параметра if_not_exists в repository.put_batch().

Исправлена неконсистентность ошибок, возвращаемых repository.put_batch().

SDK обновлен до версии 2.11.2-0-r616.

Cartridge обновлен до версии 2.8.6.

[Breaking change] Полностью удалена функциональность тенантов.

Добавлена возможность вызова repository.call_on_storage() без указания типа.

Исправлена некорректная сериализация массивов.

Исправлена обработка параметра pkey функции repository.get() при указании версии.

Исправлены ошибки в триггерах механизма версионирования.

SDK обновлен до версии 2.11.2-0-r609.

Обновления

SDK обновлен до версии 2.11.1-0-r605.

Cartridge обновлен до версии 2.8.4.

Обновлены зависимости web UI.

Новые возможности

[Breaking change] Частично удалена функциональность тенантов.

Добавлена опция handler для Kafka-коннектора.

Добавлена обработка ошибок в Kafka-коннекторе.

Добавлены метрики обработчика исходящих данных.

Добавлена возможность использования (require) кода из конфигурации в расширениях.

Исправленные ошибки

Исправлен вызов deinit до вызова init в роли scheduler.

Исправлено отсутствие сообщений об ошибках в Kafka consumer.

Исправлено удаление частей конфигурации коннекторов в веб-интерфейсе.

Обновления

SDK обновлен до версии 2.11.1-0-r579.

Cartridge обновлен до версии 2.8.2.

expirationd обновлен до версии 1.5.0.

Обновлены зависимости для веб-интерфейса.

Новые возможности

[Breaking change] Удалены настройки тенантов из веб-интерфейса.

Модуль compress добавлен в sandbox.

Добавлены настройки Kafka consumer в sandbox: consumer_seek_partitions и consumer_metadata.

Добавлены настройки Kafka consumer в sandbox: consumer_pause, consumer_resume и consumer_status.

Добавлен параметр initial_state во входящую конфигурацию Kafka.

Добавлен менеджер для управления вводом Kafka с помощью флагов в etcd.

В сообщение Kafka consumer добавлено название коннектора.

Добавлены метрики для обработчика REST.

Для tdg_service_user добавлена возможность вызова функции box.info().

Добавлена поддержка алгоритма сжатия zlib для полей типов данных.

Исправленные ошибки

Исправлен запуск задач перед бутстрапом vshard.

Исправлена обработка сложных нулевых типов в сервисах.

Исправлена визуальная ошибка в EditDataActionForm.

Исправлена обработка параметра lifetime_hours=0.

Cartridge обновлен до версии 2.8.1.

Добавлены аргументы first_n_on_storage и after функций delete и update.

Добавлена возможность чтения данных из Kafka в простом (plain) формате.

Добавлена возможность повтора попытки загрузки первых N объектов из ремонтной очереди.

Улучшена валидация имен функций.

Исправлена потеря обнуляемых полей типа «массив» в возвращаемых типах сервисов.

Исправлено присваивание значения null через GraphQL.

Обновления

SDK обновлен до версии 2.11.0-0-r563.

Cartridge обновлен до версии 2.8.0.

metrics обновлен до версии 1.0.0.

kafka обновлен до версии 1.6.6.

Новые возможности

icu-date заменен на модуль datetime во внутренних механизмах.

Примечание

Поведение модулей datetime и timezone могло измениться в некоторых

редких случаях. В рамках тестирования такие изменения не выявлены.

LuaJIT переведен в режим GC64.

Добавлена функция repository.update_batch.

Добавлена функция repository.call_on_storage_batch.

Добавлен экспериментальный режим построения индексов в фоне. Включается опцией background_index_build.

Модуль clock добавлен в sandbox.

Добавлена возможность установки ключа (key) для отправки сообщений в kafka.

Watchdog выключен по умолчанию. Вместо него используется механизм fiber.slice.

Для HARD_LIMITS_SCANNED установлено значение unlimited. Вместо него используется механизм fiber.slice.

Исправленные ошибки

Запрещены union-типы с одним полем.

Удалены некорректные предупреждения в веб-интерфейсе при выполнении некоторых

GraphQL-запросов.

Исправлена ошибка при передаче аргументов сервисов через REST API.

Исправлена ошибка при изменении union-типа на другой тип.

Исправлено некорректное сообщение об ошибке при валидации объединений (union).

Спейсы в хранилище vinyl теперь создаются только для типов со стратегией удаления

cold_storage.

Исправлена ошибка при открытии вкладки Model до бутстрапа кластера.

Исправлен запуск задач до полного завершения применения конфигурации.

Исправлена ошибка: игнорирование изменений функций по умолчанию, используемых в модели,

при загрузке конфигурации.

Исправлена ошибка, связанная с контекстом запроса Kafka.

Обновления

Cartridge обновлен до сборки (5c30d1cc).

expirationd обновлен до версии 1.4.0.

metrics обновлен до версии 0.17.0.

avro-schema обновлен до версии 3.1.0.

smtp обновлен до версии 0.0.7.

SDK обновлен до версии 2.10.6-0-r549.

Новые возможности

Добавлена поддержка aarch64 в Docker-сборки.

Добавлена проверка двойной индексации полей.

Изменено поведение кнопки Submit в компонентах Model и KeepVersionModel.

Добавлена проверка на положительность значения параметра jobs.max_jobs_in_parallel.

Исправленные ошибки

Исправлена ошибка при добавлении полей обнуляемых логических типов.

Исправлено возможное зависание во время локальных RPC-вызовов.

Исправлено падение файбера, отвечающего за запуск работ на роли Storage.

Обновлен Cartridge.

undici обновлен с версии 5.8.2 до 5.19.1.

SDK обновлен до версии 2.10.5-0-r543.

Добавлена возможность получить count для типов используя REST и GraphQL API.

Исправлена проблема связанная с тем, что время старта задачи могло быть позднее времени завершения.

SDK обновлен до версии 2.10.4-0-r538.

Исправлена проблема с обновлением записей при использовании массивов записей.

Добавлена возможность поместить набор объектов используя REST.

SDK обновлен до версии 2.10.4-0-r532.

Обновлен и улучшен модуль graphiql в WebUI.

Добавлена отдача контекста (yield) в функции cleanup журнала аудита и

обычного журнала.

Обновления

SDK обновлен до версии 2.10.4-0-r518.

Cartridge обновлен до сборки (f4258ae2).

metrics обновлен до версии 0.15.1.

kafka обновлен до версии 1.6.2.

Новые возможности

Добавлена возможность указывать в конфигурации аргументы,

которые будут переданы в функцию задачи планировщика.

Добавлена возможность запускать задачи на конкретных экземплярах Runner,

которые помечены в конфигурации метками.

Улучшены компоненты редактора:

Полнотекстовый поиск на страницах Model и Code.

Отображение номеров строк на страницах Model и Test.

Сохранение состояния страниц GraphQL и Test при переходах и обновлении страниц.

Имя токена теперь отображается в журнале аудита.

Обновления

Cartridge обновлен до версии 2.7.6.

metrics обновлен до версии 0.15.0.

SDK обновлен до версии 2.10.2-0-gf4228cb7d-r502.

Исправленные ошибки

Исправлена маршрутизация запросов при использовании пагинации.

Исправлено некорректное предупреждение в коннекторе Kafka.

Исправлено присвоение для вложенных записей в repository.update.

Новые возможности

Добавлен логический тип Timestamp.

Добавлено значение 0 («неограниченно») для keep_version_count.

Добавлена поддержка параметра skip_result в repository.put и repository.put_batch.

Добавлена функция sandbox tonumber64.

Добавлена возможность задавать правила сопоставления (collations) для отдельных частей индекса.

Журнал аудита теперь работает на основе модуля audit из Tarantool 2.10.

Исправленные ошибки

Добавлена валидация для обнуляемых полей в repository.update.

Убрана поддержка параметра first в repository.delete.

Исправлена маршрутизация запросов при использовании пагинации.

Исправлена некорректная валидация значений полей.

Новые возможности

Добавлена страница настроек LDAP.

Tarantool flightrec включен по умолчанию.

Реализована возможность включать компрессию для полей кортежа.

Добавлена поддержка заголовков Kafka во входящем коннекторе.

В модуль datetime среды sandbox добавлены новые функции модуля Tarantool datetime.

Исправленные ошибки

Исправлен ряд ошибок фронтенда.

Исправлено некорректное предупреждение в коннекторе Kafka.

Исправлено некорректное сообщение об ошибке GraphQL в журнале.

Файловый коннектор теперь ожидает доступности хотя бы одного экземпляра с ролью runner.

Исправлено присвоение для вложенных записей в repository.update.

Новые возможности

Добавлен столбец Config file name в таблицу Configuration Files.

Доступен Docker-образ с включенным режимом разработки.

Исправлена фильтрация по неиндексированным полям логического типа –

добавлено приведение полей к нативному виду.

Исправленные ошибки

Значения метрик Kafka типа boolean заменены на числовые.

Переработана фильтрация журнала и журнала аудита.

Добавлена обработка ошибок в repository.put_batch.

Критические изменения

Теперь для журнала отладки Kafka по умолчанию настроен уровень детализации all.

Поле плана запроса в GraphQL изменено на _query_plan (одно нижнее подчеркивание)

для соответствия спецификации GraphQL.

Из Kafka-коннектора и файлового коннектора удалены все строковые метрики.

Новые возможности

Добавлен флаг skip_result для интерфейсов update и delete (iproto, REST, graphql, repository).

В окно Kafka-коннектора добавлены флажки журнала событий (logger).

Теперь в формах создания и редактирования пользователя/токена можно фильтровать

список ролей по тенантам.

Добавлена настройка GraphQL для проверки консьюмеров Kafka (config.kafka_check_input).

В REST API добавлен параметр indexed_by, позволяющий выбирать индекс для сканирования.

Теперь можно передавать параметры для LDAP-соединений.

В окно конфигурации Kafka добавлена кнопка «Test Connection».

Добавлена возможность загружать в конфигурацию самостоятельно определенные роли.

В пространство sandbox добавлены функции table.make_map и table.make_array.

К метрикам добавлена гистограмма просканированных и возвращенных кортежей.

Исправленные ошибки

Жесткие лимиты (hard limits): значение returned по умолчанию больше не равняется значению scanned.

В окне создания пользователя значение поля tenant по умолчанию теперь «Default».

В журнале событий (logger) Kafka больше нет режима отключения вывода.

Вместе с сообщением Kafka в обработчик теперь передаются параметры topic, key, offset и partition.

Теперь LDAP-пользователи, для которых указаны несколько групп, имеют доступ

ко всем ролям, связанных с этими группами.

Доработана проверка значений поля «Expires in» в окне создания пользователя.

Исправлена ошибка «Cannot perform action with bucket» при вызове repository.put_batch.

Исправлена ошибка, которая появлялась, если среди аргументов сервис-функции были

enum-значения в кодировке utf-8.

Теперь при неполадках с Kafka-коннектором показывается сообщение.

Исправлена ошибка, возникавшая при попытке доступа LDAP-пользователя к GraphQL API.

Удаление профиля доступа, который используется в роли, теперь не допускается.

Новые возможности

Добавлены метрики IProto API.

В окне «Edit tenant» теперь отображаются сообщения об ошибках.

Теперь с LDAP можно использовать UPN без учета регистра.

В конфигурации Kafka-коннекторов появилась настройка enable_debug.

Теперь для GraphQL можно указывать параметры read, balance, mode.

Появилась возможность отправлять запросы к данным с помощью директивы @options.

Плагин auth теперь позволяет возвращать устанавливаемые пользователем заголовки и коды статуса.

Добавлены метрики для Kafka-коннектора.

Добавлены новые метрики для файлового коннектора.

Теперь можно настраивать логирование для Kafka-коннекторов с помощью

параметра logger. Он принимает следующие значения: stderr, tdg, disable.

Теперь можно очистить спейсы определенного типа, передав имя этого типа в API maintenance.clear_data.

Завершение работы роли коннектора теперь происходит мягко (graceful shutdown).

Исправленные ошибки

Доработано окно «Compare configuration».

Стал удобнее формат метрик для REST API (/data).

Отключено автозаполнение в форме редактирования ролей.

Теперь сообщение об ошибке исчезает из окна удаления тенанта, когда ошибка исправлена.

Из веб-интерфейса удален параметр Kafka-коннектора ssl.key.password.

Исправлена проблема, из-за которой задача могла зависнуть, если некоторое время был недоступен экземпляр runner.

Новые возможности

Возможность настраивать время ожидания для функций map_reduce и call_on_storage.

Статистика времени жизни бизнес-объектов добавлена к экспортируемым метрикам.

Добавлена опция use_active_directory для LDAP.

Добавлена опция organizational_units для LDAP.

Исправленные ошибки

Кортежи с истекшим сроком жизни теперь не возвращаются при вызове.

Исправлена обработка пустых фильтров в запросах.

Исправлена ошибка, которая могла приводить к блокировке в нескольких подсистемах TDG.

Исправлено несколько ошибок, связанных с задачами и отложенными работами.

Исправлено присваивание массивов при обновлении данных.

Исправлены ошибки, связанные с подсистемой для работы с LDAP.

Авторизация через cookie-файлы при подключении к кластеру больше не допускается.

Тип null в запросах GraphQL больше не допускается.

Новые возможности

Добавлена поддержка ILIKE, т.е. LIKE без учета регистра.

LIKE и ILIKE разрешены только для строк и в явном виде запрещены для индексов.

При трассировке теперь сохраняется иерархия структуры фрагментов span.

Добавлены метрики для интерфейса управления данными REST.

Добавлен интерфейс GraphQL, позволяющий блокировать секции конфигурации и предотвращать их удаление.

API GraphQL model и expiration заменены на общий API data_type.

Добавлен интерфейс GraphQL для настройки метрик.

Исправленные ошибки

Исправлены некоторые ошибки мультитенантности.

Обратная итерация без курсора теперь запрещена.

В API model больше не допускается использовать поле namespace.

Новые возможности

При обновлении объектов теперь проверяются поля типа enum.

Добавлена проверка input_processor.storage.type.

Появилась возможность добавлять несколько входов Kafka.

Вместо файбера TDG time_delta теперь нужно использовать параметр Cartridge issues_limits.

Добавлена проверка, являются ли несуществующие типы данных элементами

обнуляемого массива и используются ли они в качестве аргументов/возвращаемых

значений.

Исправленные ошибки

Исправлена обработка сценария, при котором в секции expiration указан тип, не указанный в секции types.

Обнуляемые элементы массивов теперь обрабатываются корректно.

Составные индексы, заданные по двум и более полям с логическими типами,

теперь работают корректно.

Стало невозможно назначить разным коннекторам одинаковые имена в конфигурации.

Выпуск первой публичной версии 2.1.0.

Архитектура

В этой главе описывается архитектура Tarantool Data Grid.

Основные архитектурные компоненты TDG изображены на схеме ниже.

Как видно из схемы, различные аспекты работы TDG разделены по

соответствующим кластерным ролям: Storage, Connector, Runner и

Core. Каждый экземпляр (узел) в кластере может иметь одну или более ролей.

Подробнее о кластерных ролях рассказывается в разделе Кластерные роли.

Доступ к данным: GraphQL и REST API

Для доступа к данным TDG используются два основных способа:

GraphQL и REST API.

Оба способа поддерживают запросы с использованием индексов

(первичных, вторичных и составных), операторы сравнения, множественные условия и

другие возможности выборки данных.

Точки доступа создаются автоматически на основе модели данных и доступных

сервисов. Эти сервисы также можно вызывать через

GraphQL и REST API.

Исполнение бизнес-логики: Lua

TDG предоставляет возможность хранения и исполнения пользовательской

бизнес-логики, например, валидации или преобразования данных.

Для добавления необходимой бизнес-логики нужно реализовать её в виде функций

на языке Lua и загрузить их в TDG.

Загруженные функции можно использовать несколькими способами:

Вызывать извне. Для этого нужно добавить их в конфигурацию доступных

сервисов.

Такие сервисы доступны для вызова через GraphQL, REST API или iproto

(бинарный протокол Tarantool).

Привязать к коннектору. В этом случае функции будут вызываться при каждом

взаимодействии через этот коннектор, например, при поступлении нового объекта.

Выполнять по расписанию. Для этого в TDG есть планировщик задач, который

позволяет настроить автоматическое выполнение пользовательской бизнес-логики.

Взаимодействие с внешними системами

Для обмена данными с внешними системами в TDG используются коннекторы.

Коннекторы бывают двух типов: входящие (input) для получения данных извне и

исходящие (output) для отправки данных из TDG.

Коннекторы позволяют обмениваться данными с такими источниками как:

Администрирование и безопасность

TDG предоставляет инструменты для управления различными техническими

функциями, в том числе:

Для управления конфигурацией TDG доступны два способа:

Для мониторинга и расследования инцидентов TDG предоставляет

метрики кластера в формате Prometheus. Метрики

доступны для получения через REST API и визуализации в Grafana.

Встроенные инструменты безопасности TDG позволяют настроить доступ

к различным функциям для пользователей и внешних систем. Для этого используется

ролевая модель доступа. Роли могут

быть приписаны как к профилям (для настройки

доступа пользователей), так и к токенам приложений

– средству авторизации приложений для взаимодействия с TDG. Для

расследования инцидентов безопасности доступен журнал аудита.

Кластерные роли

Экземпляры TDG в кластере выполняют те или иные функции в соответствии

с назначенными им кластерными ролями. Каждый экземпляр может иметь одну или

несколько ролей.

В TDG существует четыре основных кластерных роли:

Core: настройка и администрирование.

Storage: проверка и хранение данных.

Runner: исполнение бизнес-логики с помощью кода на Lua.

Connector: обмен данными с внешними системами.

Еще одна кластерная роль, failover-coordinator, позволяет включать

режим восстановления после сбоев с сохранением состояния (stateful failover).

Подробности можно найти в

документации Tarantool Cartridge.

Кластерные роли назначаются наборам реплик (replica set). Каждый экземпляр получает

роли того набора реплик, в который он входит. В каждом наборе реплик все экземпляры

взаимозаменяемы: на них хранится одно и то же состояние. Таким образом обеспечивается

резервирование и устойчивость к сбоям.

Роль Core

Роль core используется для выполнения собственных функций TDG.

Экземпляры с этой ролью обеспечивают управление моделью данных, сервисами, настройками

безопасности и доступа и другими функциями. На этих экземплярах хранится внутренняя

информация TDG и не хранятся пользовательские данные.

В кластере может быть только один набор реплик с ролью core.

Роль Storage

Роль storage используется для хранения пользовательских данных. На экземплярах

с этой ролью создаются спейсы

Tarantool в соответствии с моделью данных.

Объединение экземпляров storage в наборы реплик обеспечивает шардирование

и репликацию данных: каждый набор реплик хранит своё подмножество данных (shard),

и это подмножество реплицируется на все экземпляры набора реплик.

Количество наборов реплик Storage определяется объемом хранимых данных.

Роль Runner

Роль runner используется для выполнения пользовательской

бизнес-логики. На этих экземплярах с помощью

встроенного в Tarantool Lua-интерпретатора выполняются загруженные в TDG

пользовательские скрипты: сервисы, задачи, обработчики входящих и исходящих данных.

Экземпляры runner не хранят состояние и используются только для исполнения кода.

Таким образом, они все эквивалентны, и объединение в наборы реплик не влияет на их

функциональность.

Роль Connector

Роль connector используется для сетевого взаимодействия с внешними системами.

На экземплярах с этой ролью создаются адреса (endpoints) для обращения к кластеру

через GraphQL и REST API, а также коннекторы для подключения

по различным протоколам: HTTP (JSON или SOAP), Apache Kafka или iproto.

Экземпляры connector не хранят состояние и используются только для внешних подключений.

Таким образом, они все эквивалентны, и объединение в наборы реплик не влияет на их

функциональность.

Руководство администратора

В этом документе объясняется, как администратору работать с системой Tarantool Data Grid (TDG).

Развертывание

В этой главе описаны способы, которыми можно развернуть TDG для

разработки и тестирования (development environment).

Для получения помощи в развертывании кластера TDG для промышленной

эксплуатации (production environment) заполните форму для связи на

этой странице или напишите на sales@tarantool.io.

Первое развертывание с помощью Ansible

В этом руководстве описано, как впервые быстро развернуть Tarantool Data

Grid (TDG) с помощью Ansible. Здесь приведен вариант развертывания TDG на

двух виртуальных машинах с заданной конфигурацией.

Подготовка TGZ-файла для развертывания

Чтобы развернуть Tarantool Data Grid, вам понадобится RPM-файл (.rpm),

TGZ-файл (tar.gz) или Docker-образ (docker-image.tar.gz). Для

развертывания с помощью Ansible подходят только два из них: RPM- и TGZ-файл.

В этом руководстве для примера используется TGZ-файл. Его проще развернуть,

и вам не потребуется root-доступ.

Скачайте TGZ-файл последней версии в личном кабинете на сайте

tarantool.io.

Убедитесь, что ваш браузер не разархивировал скачанный файл: расширение

файла должно быть tar.gz.

Если у вас нет доступа к личному кабинету, отправьте заявку через форму на

этой странице или напишите

на sales@tarantool.io.

Настройка виртуальных машин

Чтобы развернуть TDG, вам нужно запустить две виртуальные машины с ОС Linux

(желательно CentOS 7/RHEL 7) и доступом по SSH. Если у вас уже

установлены приведенные ниже или альтернативные виртуальные машины,

то пропустите эту главу. Если нет, то следуйте

инструкции.

Установите VirtualBox для

запуска виртуальных машин и Vagrant для

автоматизации процесса конфигурации. Vagrant подготовит конфигурацию двух

виртуальных машин с дополнительными сценариями для развертывания TDG.

Примечание

Перед установкой программного обеспечения проверьте, что разработчик не накладывает ограничений

на использование — например, не ставит блокировки по IP-адресам. При возникновении проблем

воспользуйтесь услугами альтернативных провайдеров виртуальных машин.

Убедитесь, что в переменной окружения $PATH у вас есть VBoxManage.

Проверьте такой командой:

В скачанном TGZ-файле есть директория под названием deploy. Там

находится Vagrantfile, который автоматизирует создание тестовой среды

для развертывания кластера.

Откройте терминал, распакуйте архив tar.gz, перейдите в директорию

deploy и запустите виртуальные машины:

tar xzf tdg-<VERSION>.tar.gz # замените <VERSION> на версию скачанного TDG

cd tdg2/deploy

vagrant up

Эта команда поднимет две виртуальные машины с CentOS 7 и доступом по SSH без

пароля для пользователя vagrant. IP-адреса этих машин будут такие:

172.19.0.2 и 172.19.0.3.

Развертывание кластера

Подготовка

После создания виртуальных машин установите локально

Ansible

и Ansible-роль

для Tarantool Cartridge (последняя версия 1.x). Если доступна Ansible-роль версии 2.x,

можно выбрать ее, но тогда вы можете столкнуться с некоторыми трудностями.

Вот один из способов установки Ansible и Ansible-роли:

pip install ansible~=4.1.0 # версия 4.1 или более поздняя, но не 5.x

ansible-galaxy install tarantool.cartridge,1.10.0

Конфигурация

В директории deploy есть файл hosts.yml. В нем лежит конфигурация

кластера.

Откройте этот файл, чтобы указать cookie для кластера и путь до пакета:

all

vars:

# cartridge_package_path: "../../packages/tdg-ENTER-VERSION-HERE.tgz" # путь относительно расположения плейбука

# cartridge_cluster_cookie: "ENTER-SECRET-COOKIE-HERE" # замените на "secret-cookie"

Удалите #, чтобы раскомментировать эти строки, укажите версию TDG, которую

вы скачали, и путь к TGZ-файлу. Также задайте cookie для кластера. Это

должна быть уникальная строка, но для практики достаточно указать

«secret-cookie».

Вот пример:

all

vars:

cartridge_package_path: "../tdg-2.0.0-1132-g2358e716.tgz"

cartridge_cluster_cookie: "secret-cookie"

При необходимости всегда можно отредактировать этот файл, чтобы изменить

конфигурацию кластера. Вот информация о разделах файла:

all.vars — для общих переменных;

all.children.tdg_group.hosts — для параметров экземпляров (инстансов, instances);

all.children.tdg_group.children — для параметров группы экземпляров:

чтобы сгруппировать экземпляры по хосту, задайте для них параметр ansible_host;

чтобы сгруппировать экземпляры по наборам реплик, задайте для них параметры

replicaset_alias, roles, failover_priority и так далее.

Более подробную информацию о параметрах смотрите

в документации по Ansible-роли

в Tarantool Cartridge.

Развертывание

В директории deploy находятся

Ansible-плейбуки,

которые помогут вам завершить развертывание. Есть два способа развернуть TDG с помощью плейбуков:

кластер TDG с полностью сконфигурированной топологией;

кластер TDG со списком экземпляров (инстансов, instances) без заданной конфигурации.

Чтобы полностью развернуть TDG с топологией, выполните эту команду:

$ ansible-playbook -i hosts.yml playbooks/deploy.yml

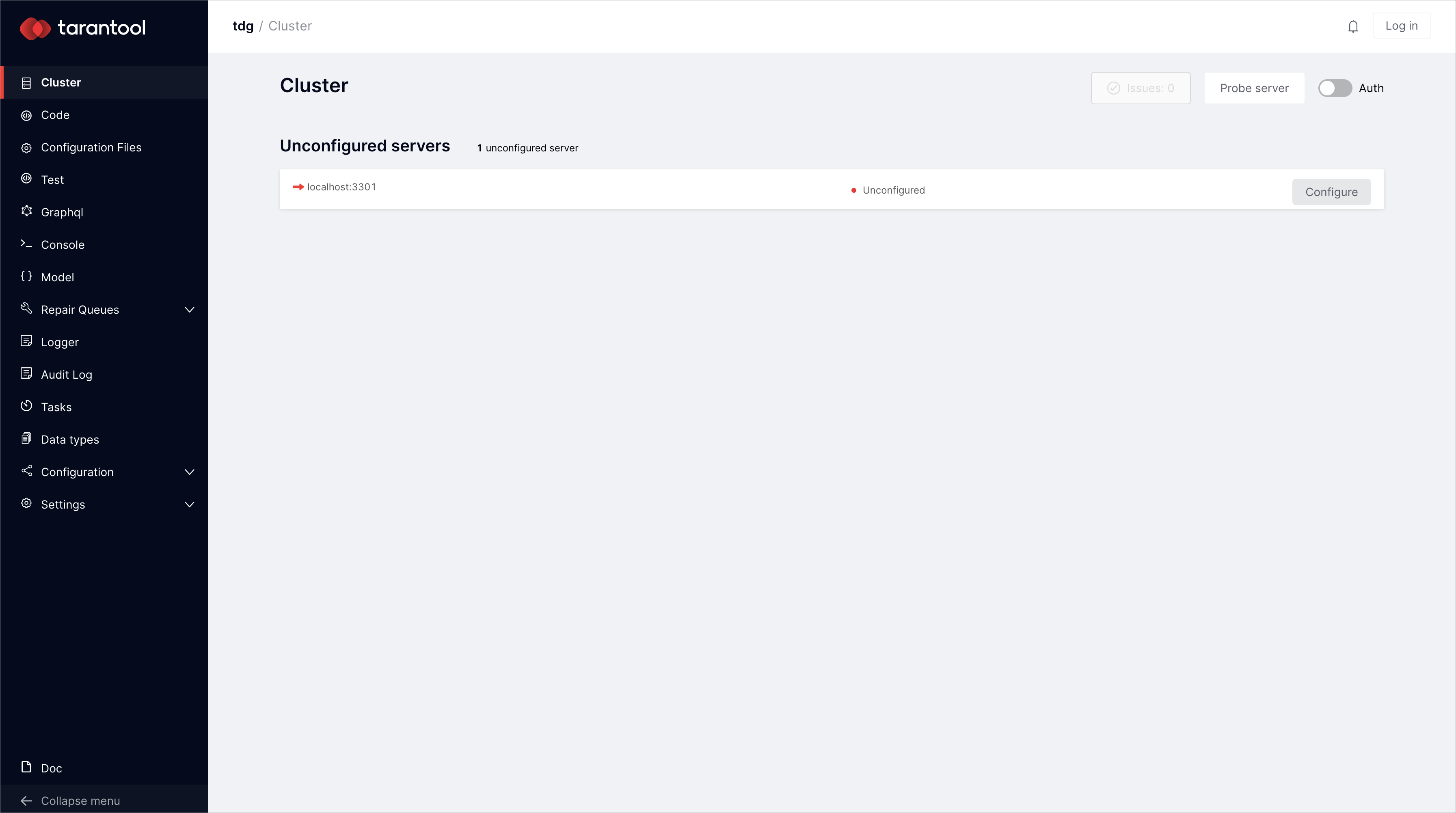

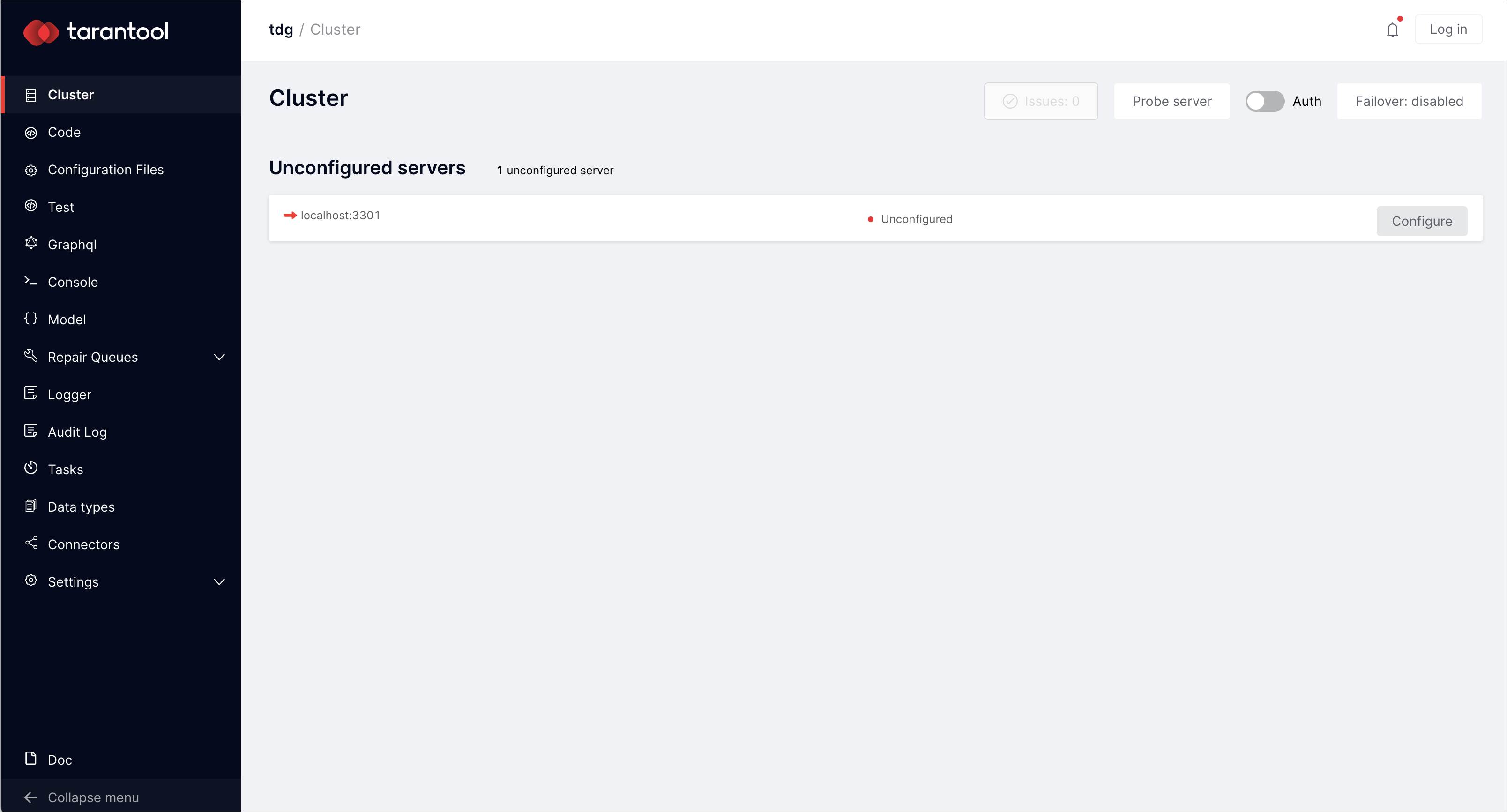

Если вы хотите cами задать конфигурацию топологии кластера через веб-интерфейс,

запустите плейбук, чтобы развернуть только экземпляры:

$ ansible-playbook -i hosts.yml playbooks/deploy_without_topology.yml

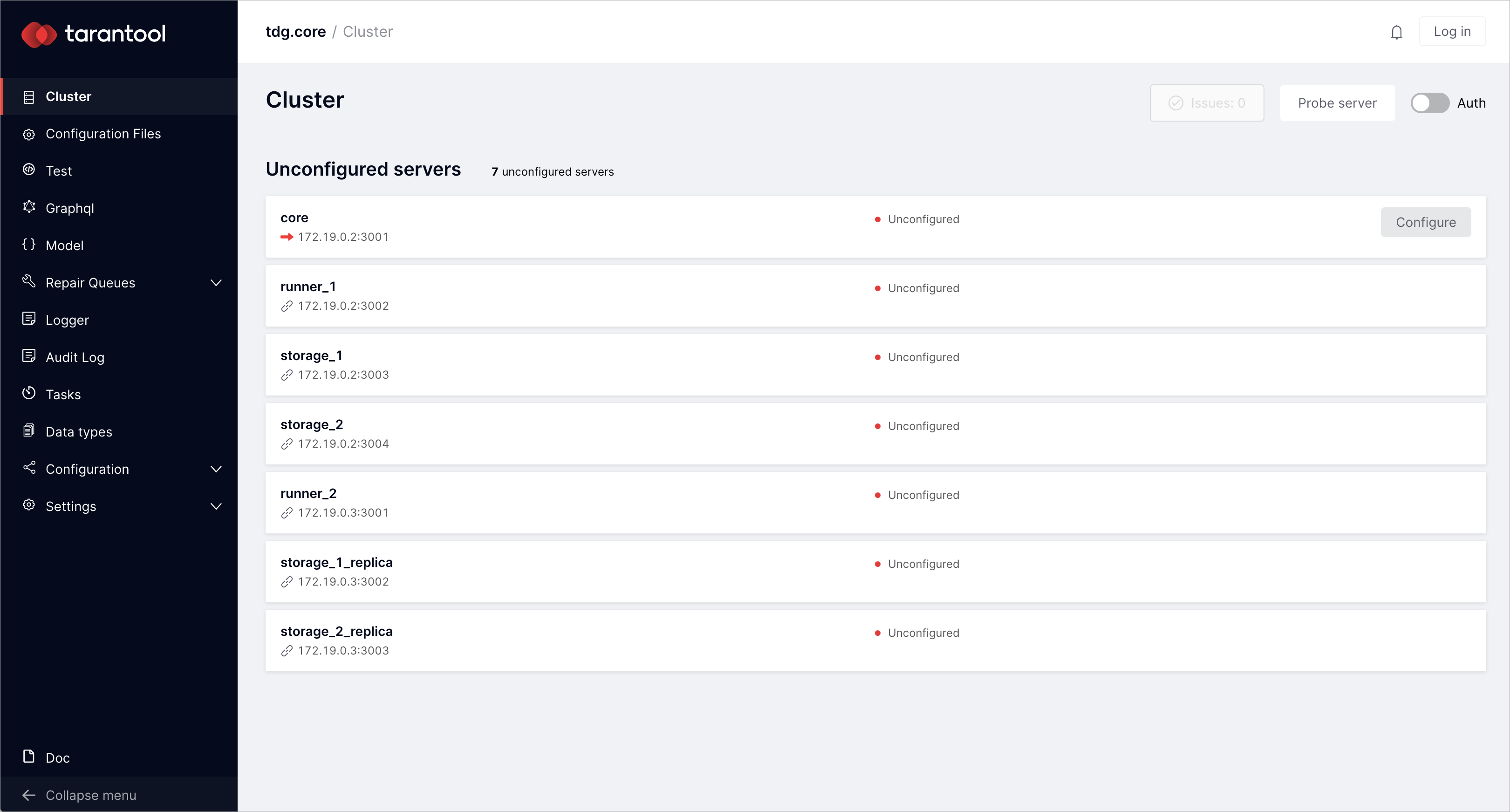

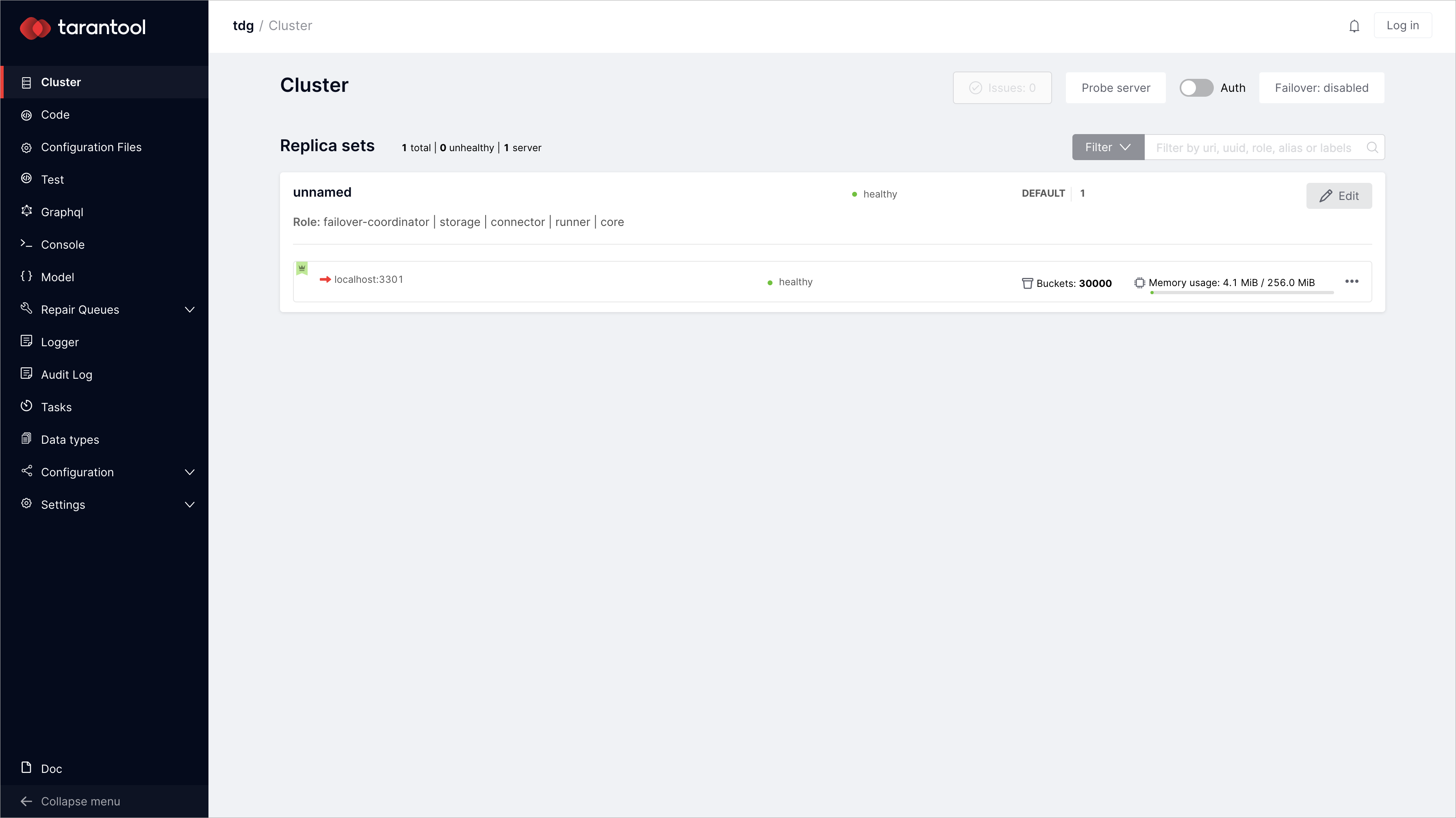

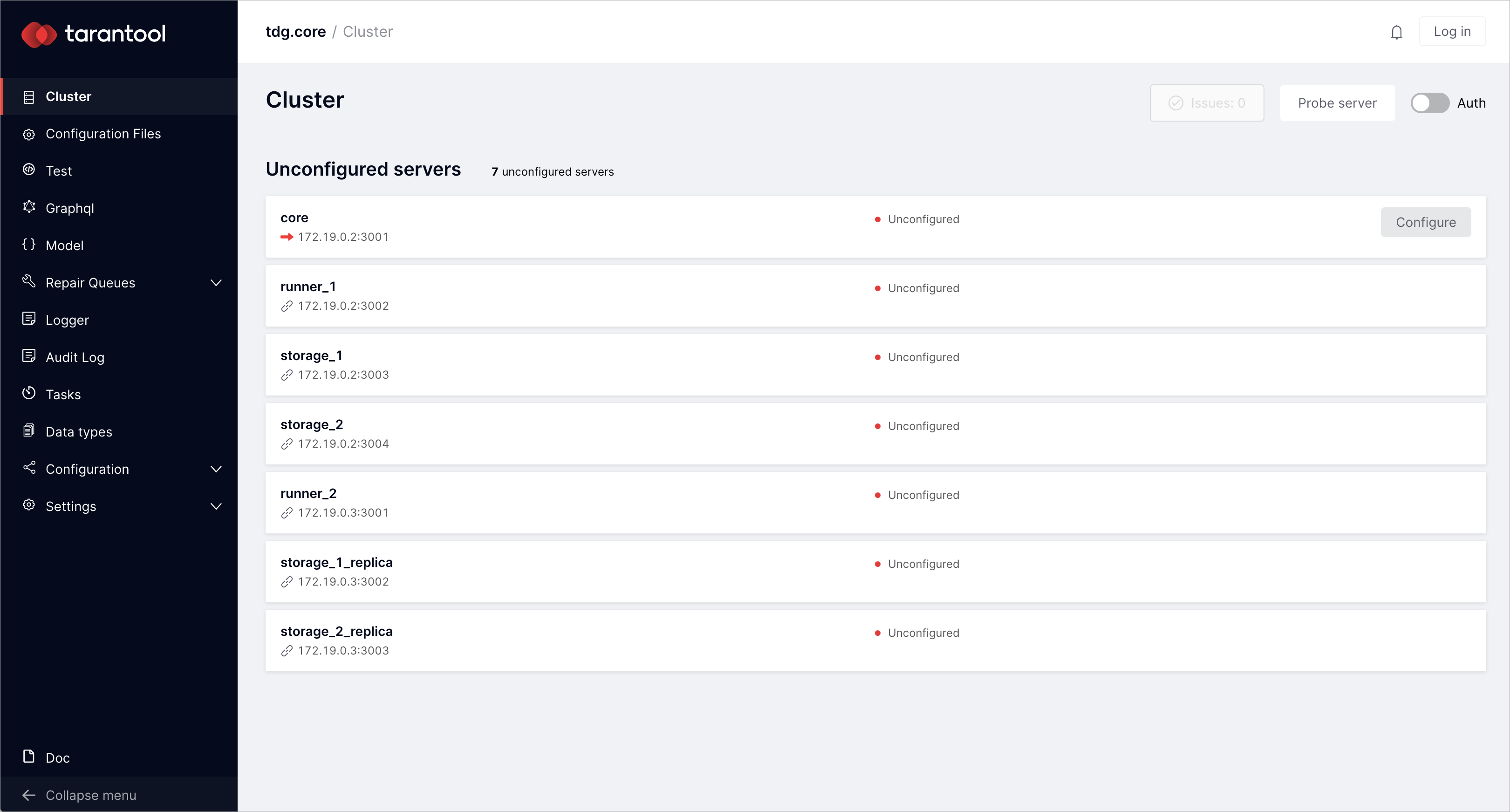

Откройте http://172.19.0.2:8081 в браузере,

чтобы увидеть веб-интерфейс кластера. Вот как будет выглядеть кластер, развернутый без топологии:

Управление кластером

Конфигурация топологии кластера

Если вы развернули экземпляры (инстансы, instances) с топологией, пропустите

эту главу.

Если вы развернули экземпляры без топологии, теперь вы можете редактировать

топологию: создавать наборы реплик и задавать их параметры в веб-интерфейсе:

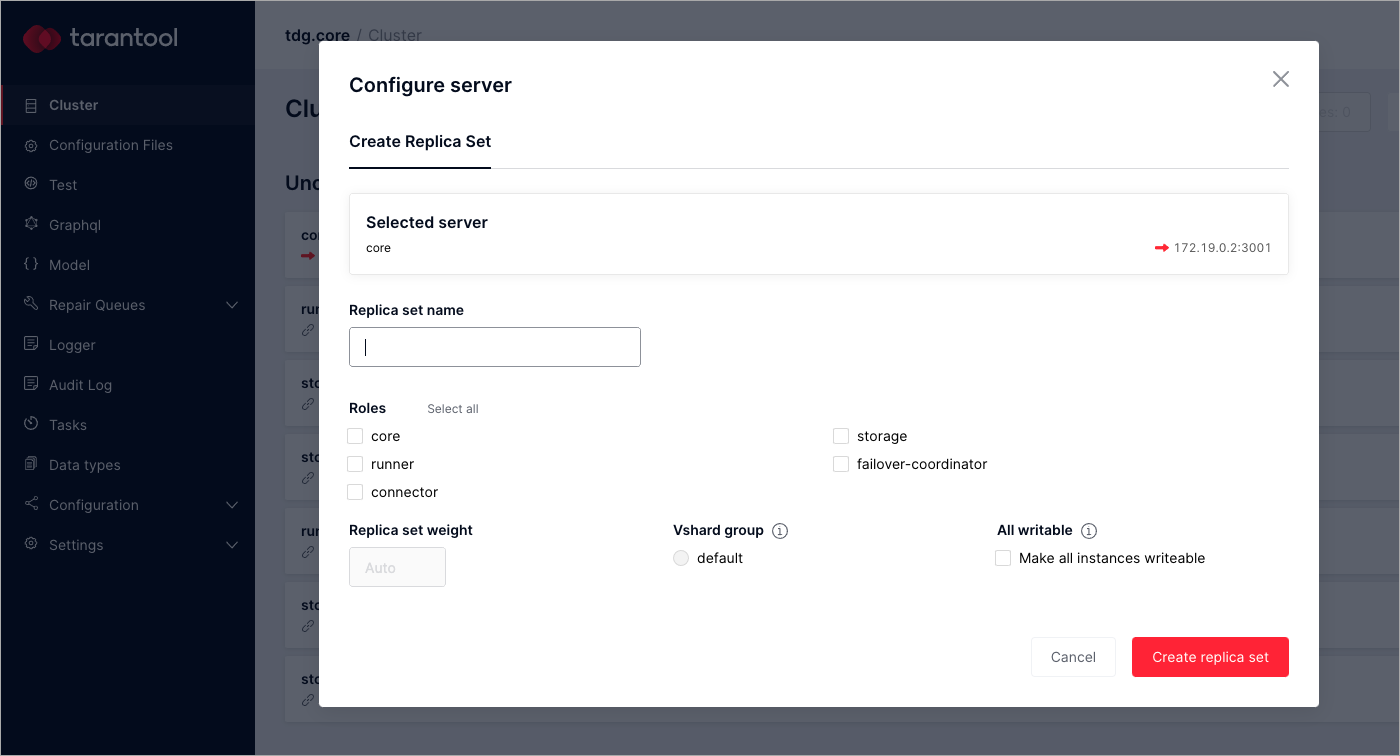

На вкладке Cluster находятся экземпляры без заданной конфигурации. Выберите

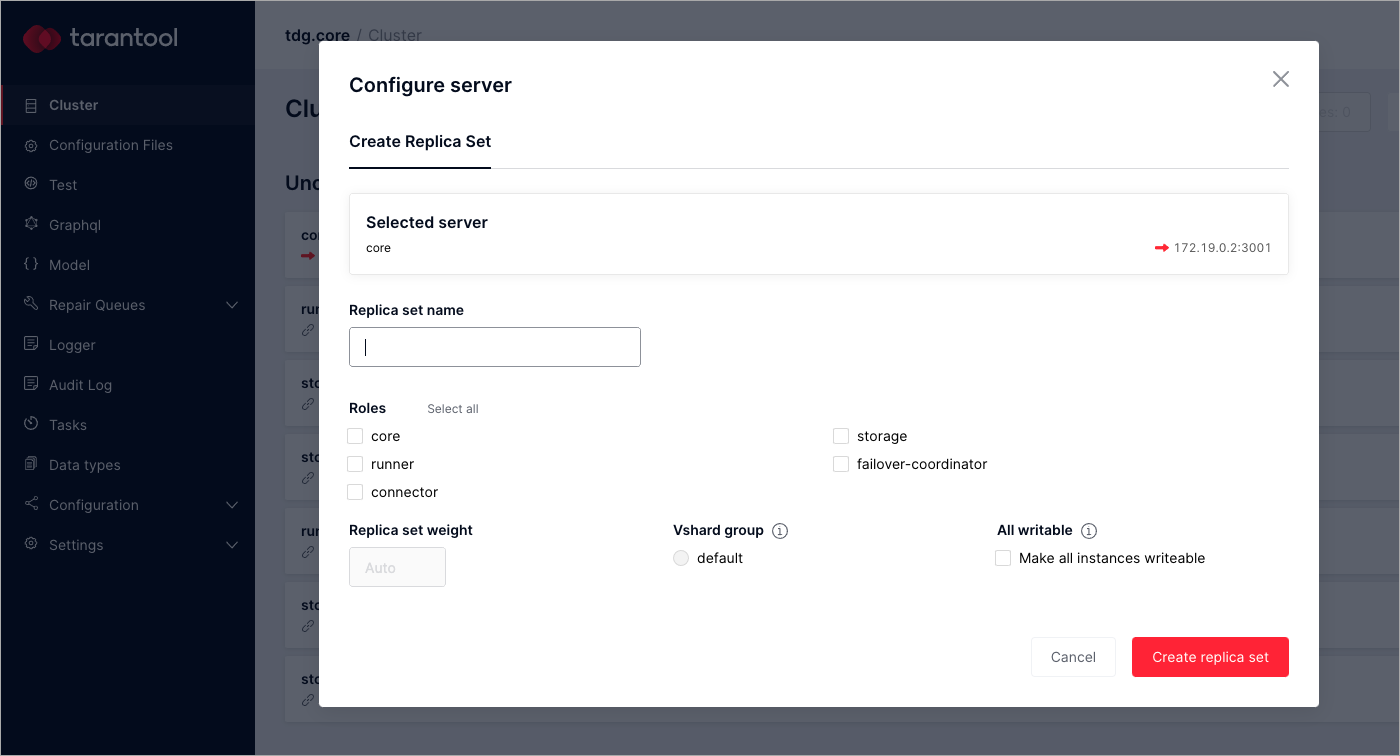

экземпляр core с URL 172.19.0.2:3001 и нажмите Configure.

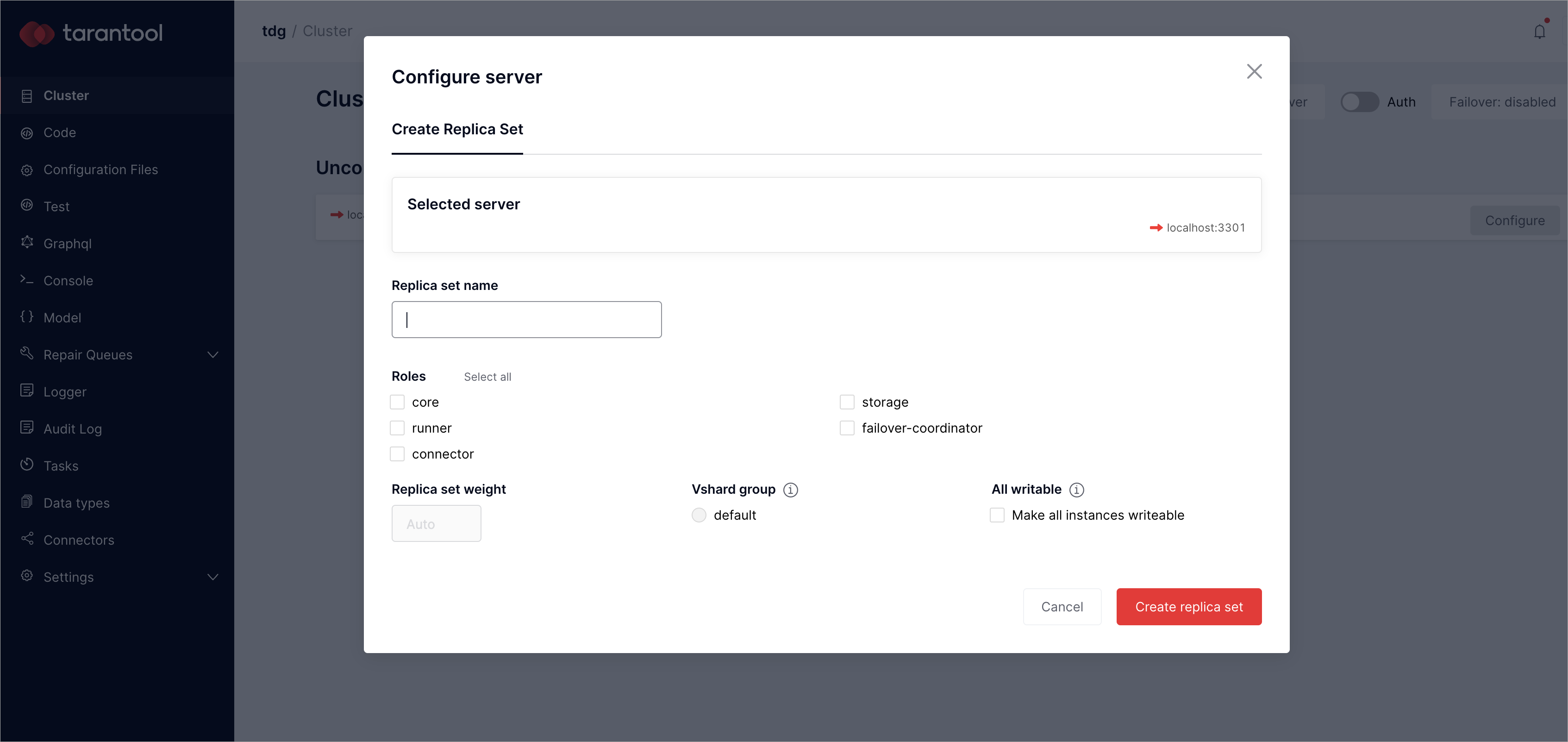

Появится окно Configure server:

В диалоговом окне Configure server укажите значения двух параметров

набора реплик: replica set name (имя набора реплик) и role (роль).

Для экземпляра core задайте имя набора реплик «core» и выберите роль

«core». После этого нажмите Create replica set, чтобы создать набор реплик.

Для остальных экземпляров без заданной конфигурации установите параметры следующим образом:

URL экземпляра |

Имя набора реплик |

Роли |

|---|

172.19.0.2:3002 |

runner_1 |

runner, connector, failover-coordinator |

172.19.0.2:3003 |

storage_1 |

storage |

172.19.0.2:3004 |

storage_2 |

storage |

172.19.0.3:3001 |

runner_2 |

runner, connector |

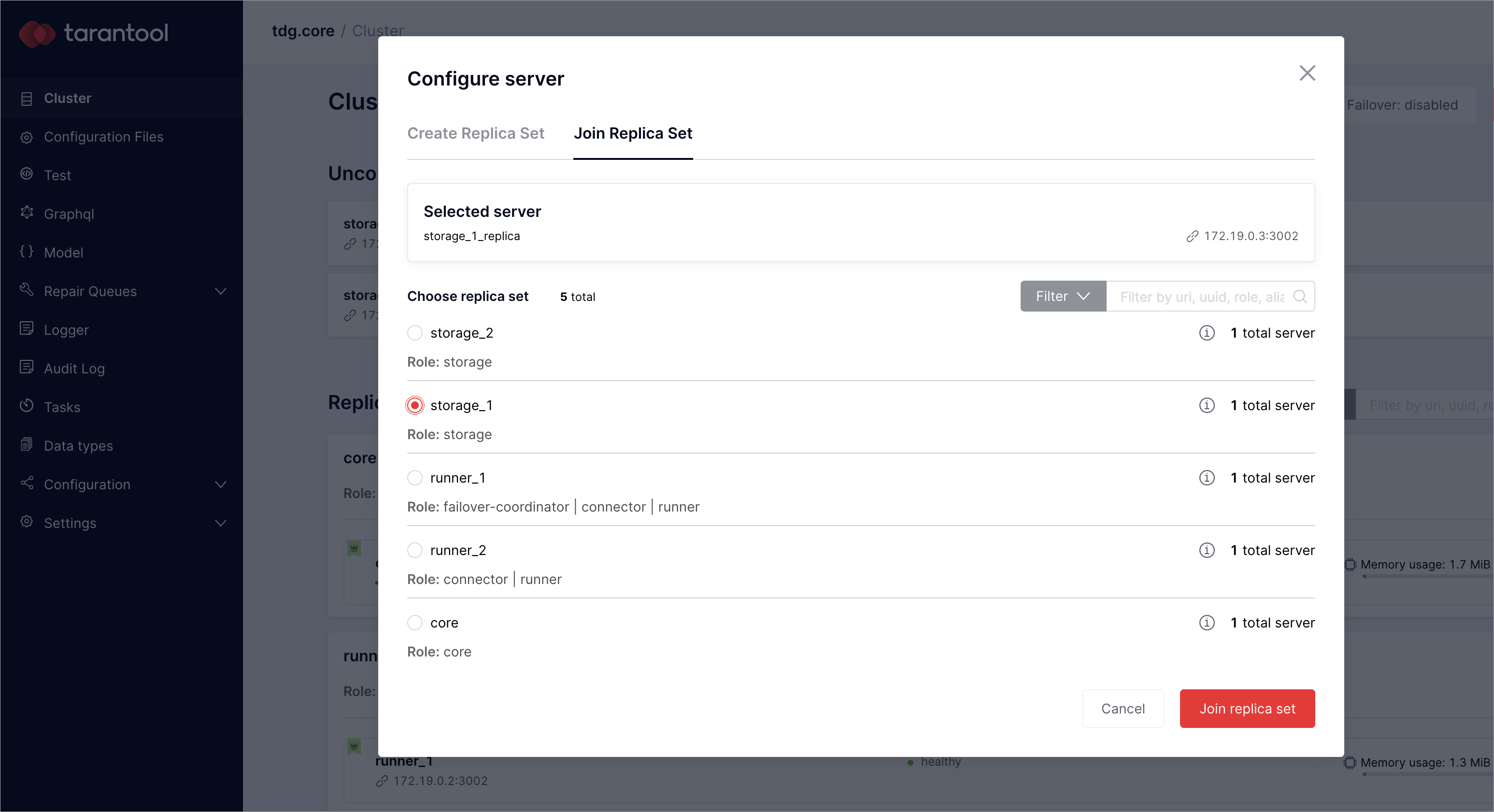

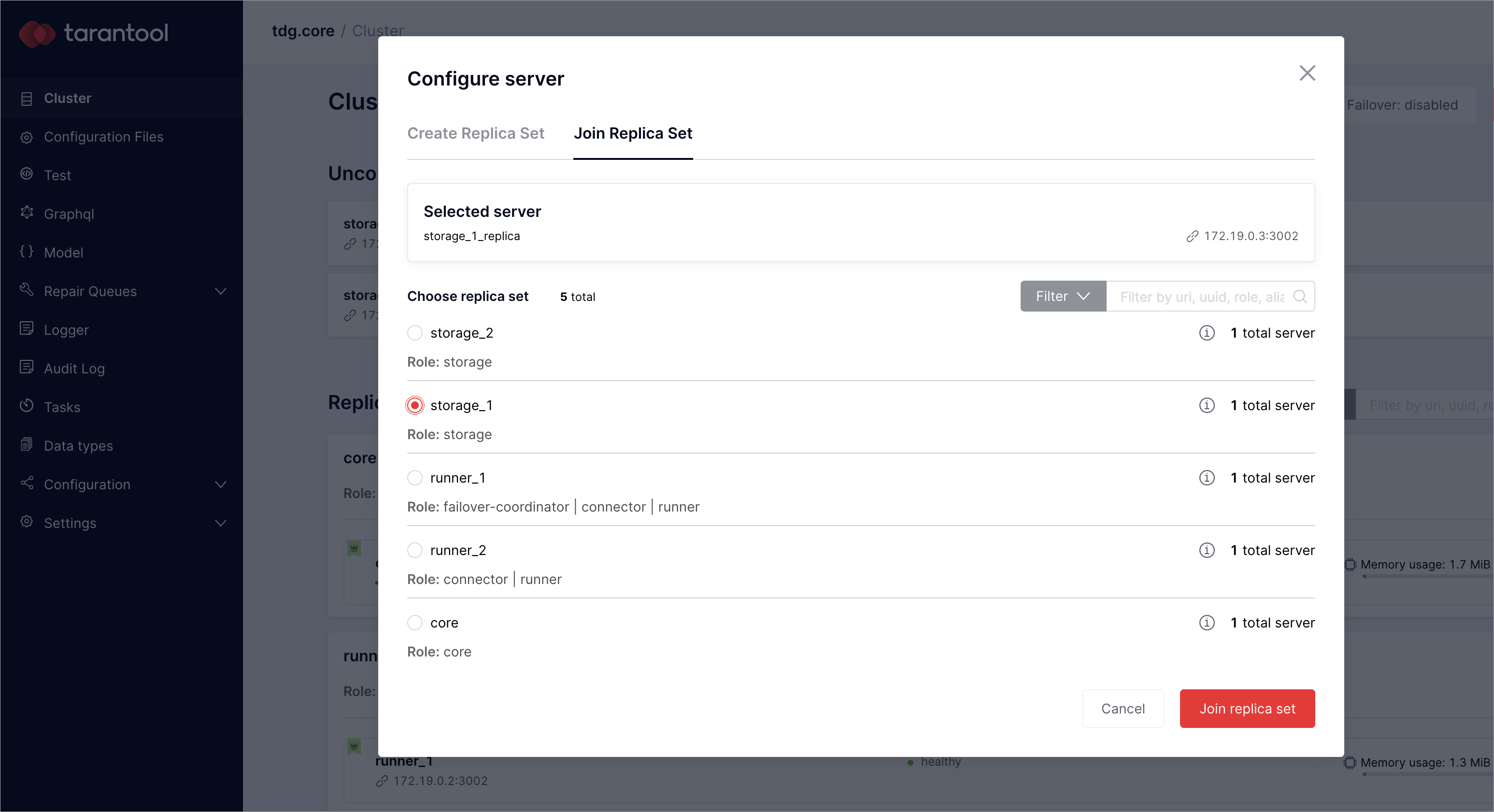

Осталось настроить два экземпляра: storage_1_replica с URL

172.19.0.3:3002 и storage_2_replica с URL 172.19.0.3:3003.

Присоедините их к уже существующим наборам реплик с ролями storage:

Выберите storage_1_replica и нажмите Configure.

В диалоговом окне Configure server переключитесь на вкладку Join Replica Set.

Отметьте storage_1 и нажмите Join replica set.

Для storage_2_replica повторите те же действия, но отметьте storage_2.

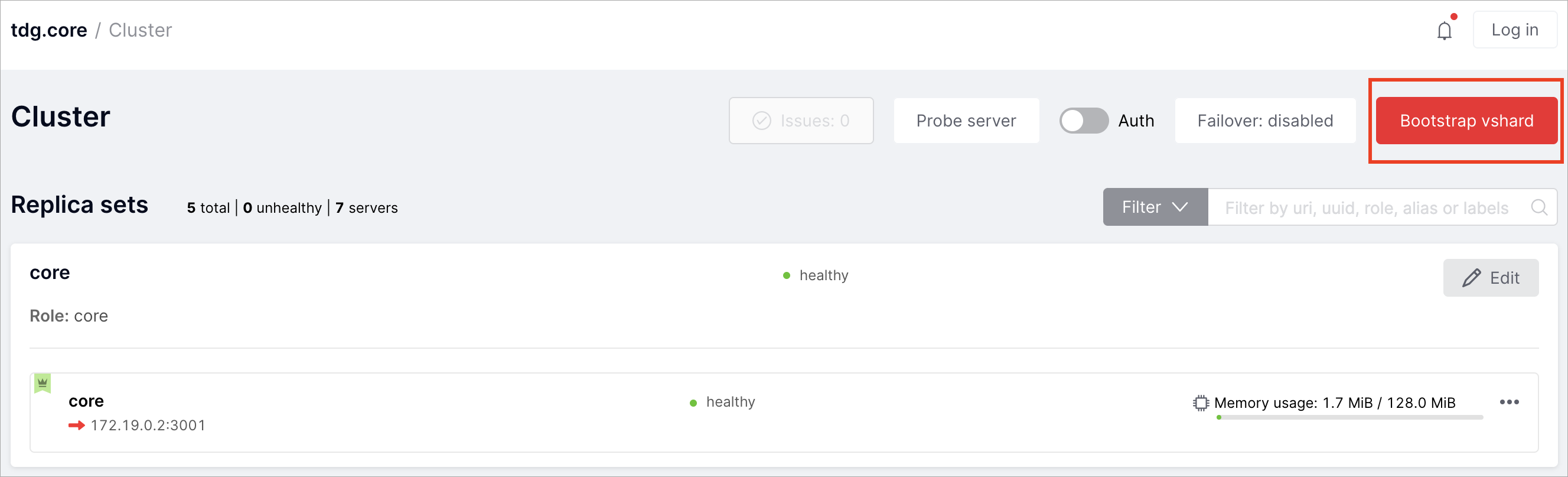

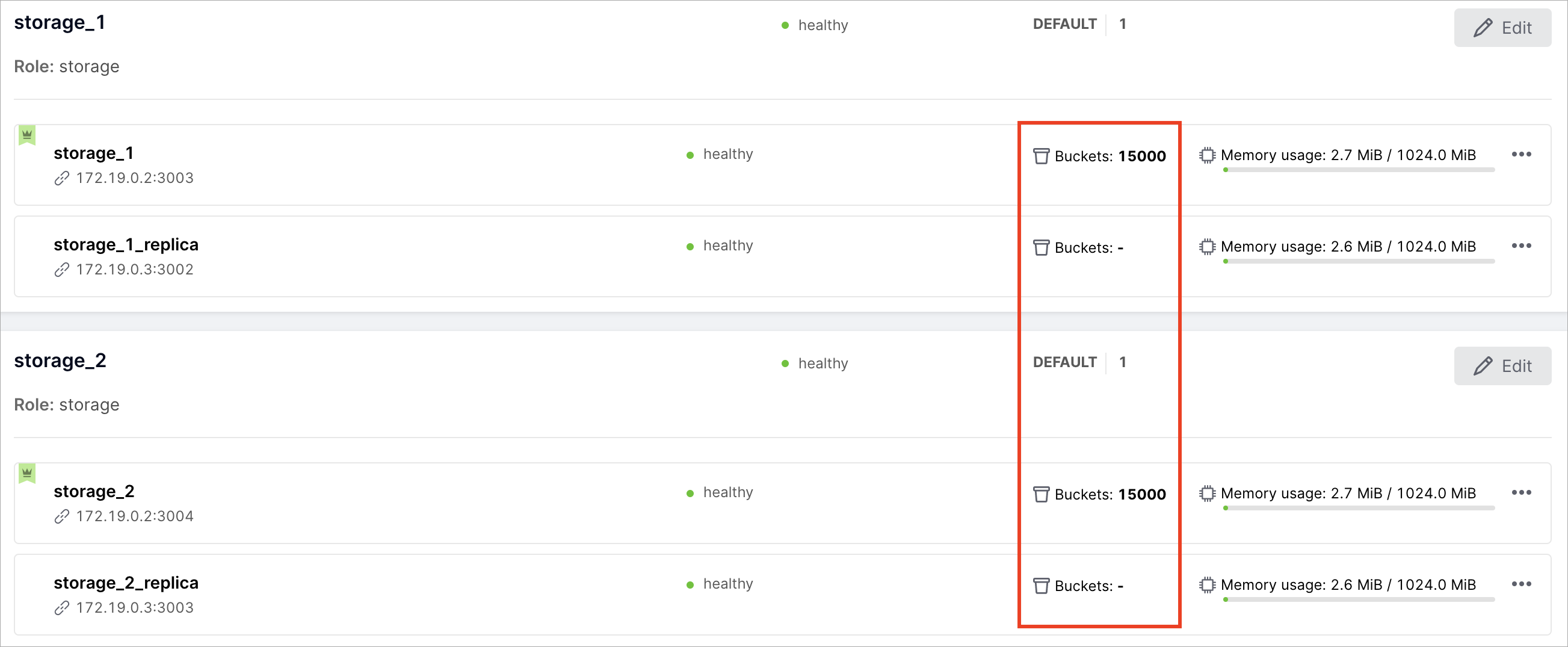

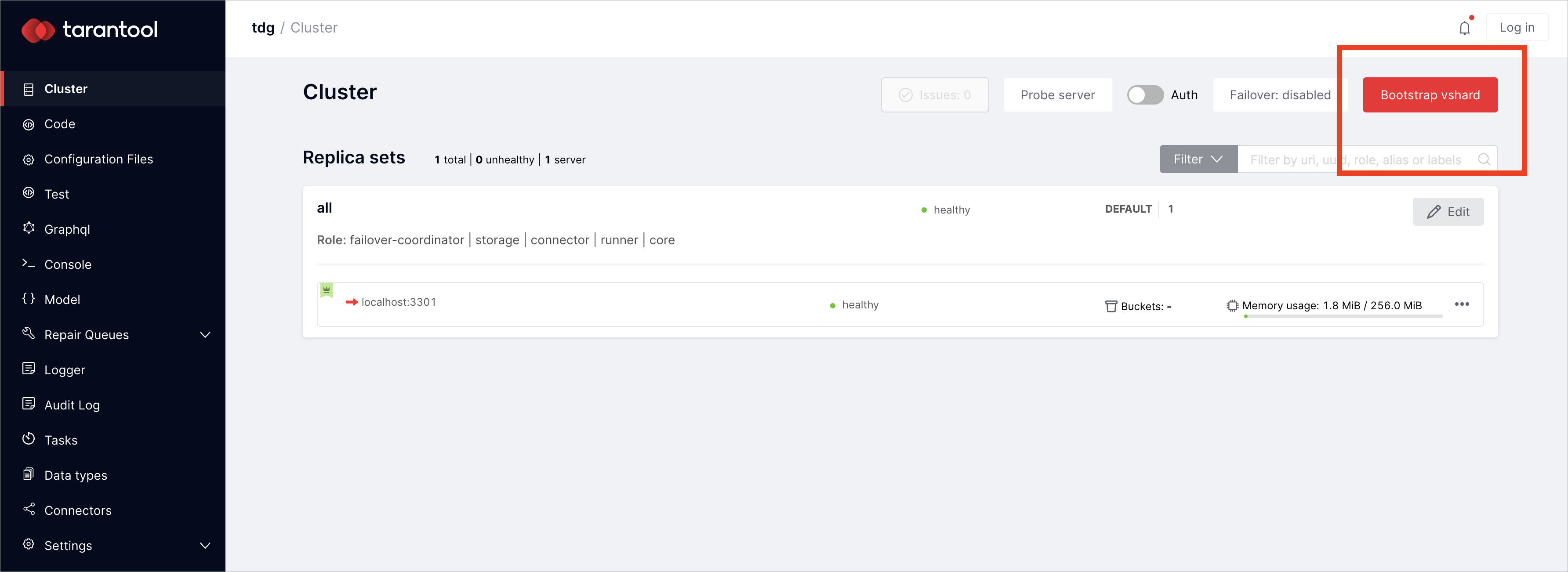

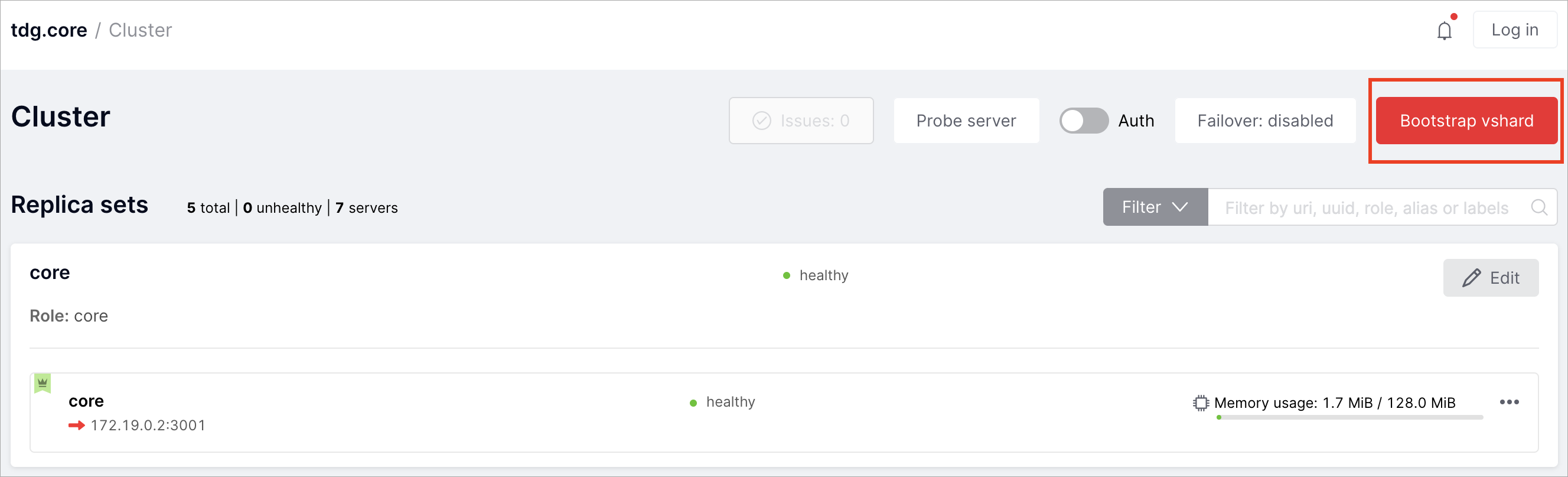

После того, как вы назначите все роли, нажмите «Bootstrap vshard», чтобы

«включить наборы реплик storage. Это инициализирует модуль Tarantool

vshard. Подробнее об этом модуле можно узнать

в документации по Tarantool.

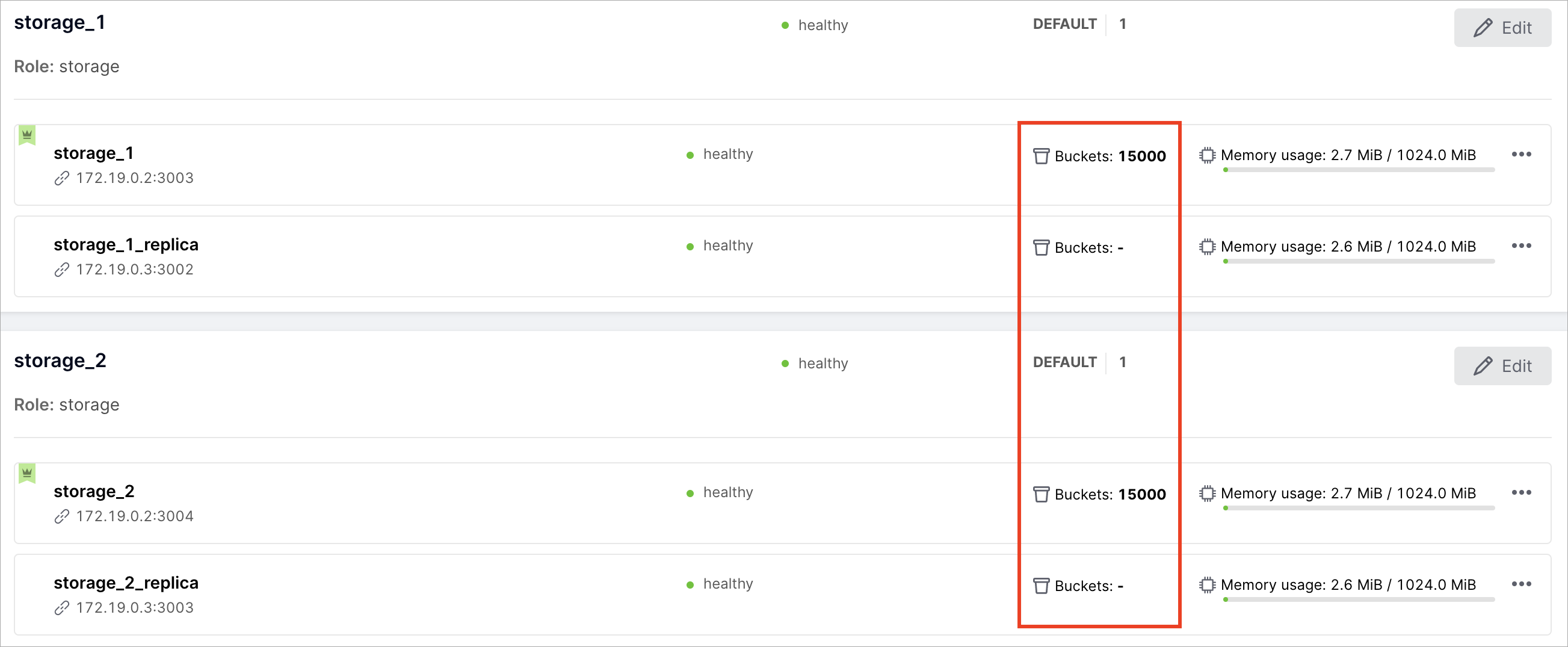

Вы создали виртуальные сегменты (virtual buckets), которые распределяются по хранилищам —

экземплярам с ролью storage.

Запуск и остановка экземпляров

Этот шаг необязателен.

В директории deploy также есть плейбуки, которые запускают или

останавливают экземпляры. Вы можете остановить и отключить все экземпляры с

помощью плейбука stop.yml:

$ ansible-playbook -i hosts.yml playbooks/stop.yml

Запустить и включить все экземпляры можно с помощью плейбука start.yml:

$ ansible-playbook -i hosts.yml playbooks/start.yml

Первое развертывание вручную

В этом руководстве описано, как впервые быстро развернуть Tarantool Data

Grid (TDG) вручную. В результате вы локально развернете кластер TDG с одним

узлом.

Примечание

Чтобы развернуть TDG, вам понадобится ОС Linux (желательно CentOS 7/RHEL 7).

Если у вас другая ОС, сначала вам нужно будет создать виртуальную машину с

ОС Linux.

Подготовка TGZ-файла для развертывания

Чтобы развернуть Tarantool Data Grid, вам понадобится RPM-файл (.rpm),

TGZ-файл (tar.gz) или Docker-образ (docker-image.tar.gz). Для

первого развертывания подойдет TGZ-файл. Его проще развернуть, и вам не

потребуется root-доступ.

Скачайте TGZ-файл последней версии в личном кабинете на сайте

tarantool.io.

Убедитесь, что ваш браузер не разархивировал скачанный файл: расширение

файла должно быть tar.gz.

Если у вас нет доступа к личному кабинету, заполните эту форму

или напишите на sales@tarantool.io.

Развертывание

Распакуйте файл tar.gz:

$ tar xzf tdg-<VERSION>.tar.gz # замените <VERSION> на версию скачанного TDG

Запустите кластер TDG с одним узлом внутри распакованного архива tar.gz:

$ ./tarantool ./init.lua --bootstrap true

Если у вас уже установлен Tarantool, убедитесь, что для развертывания TDG вы

используете ту версию Tarantool, которая была упакована в только что

скачанный архив tar.gz.

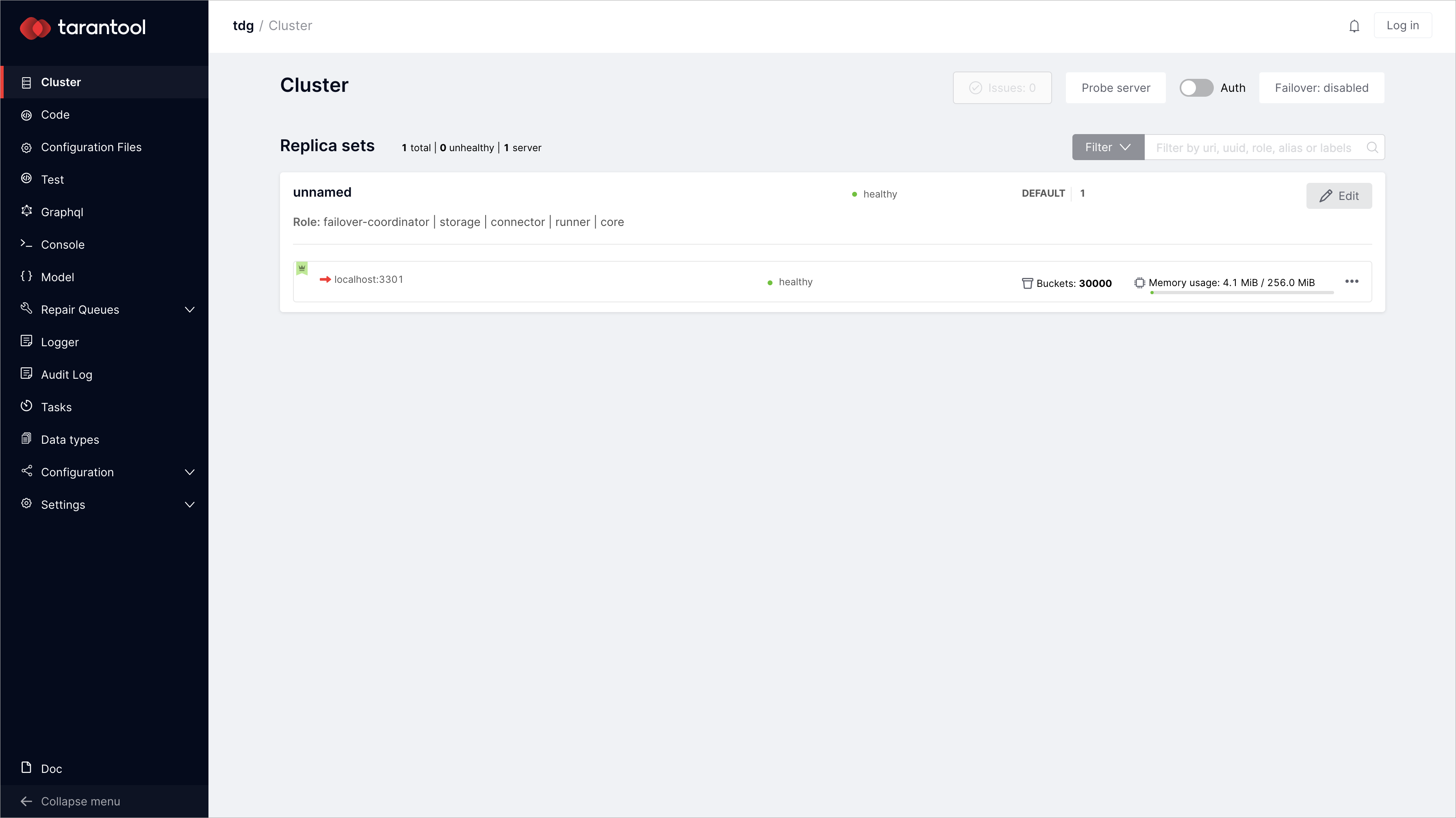

Перейдите на http://127.0.0.1:8080/, чтобы

проверить развернутый кластер TDG:

Выполнив команду tarantool ./init.lua --bootstrap true, вы развернули

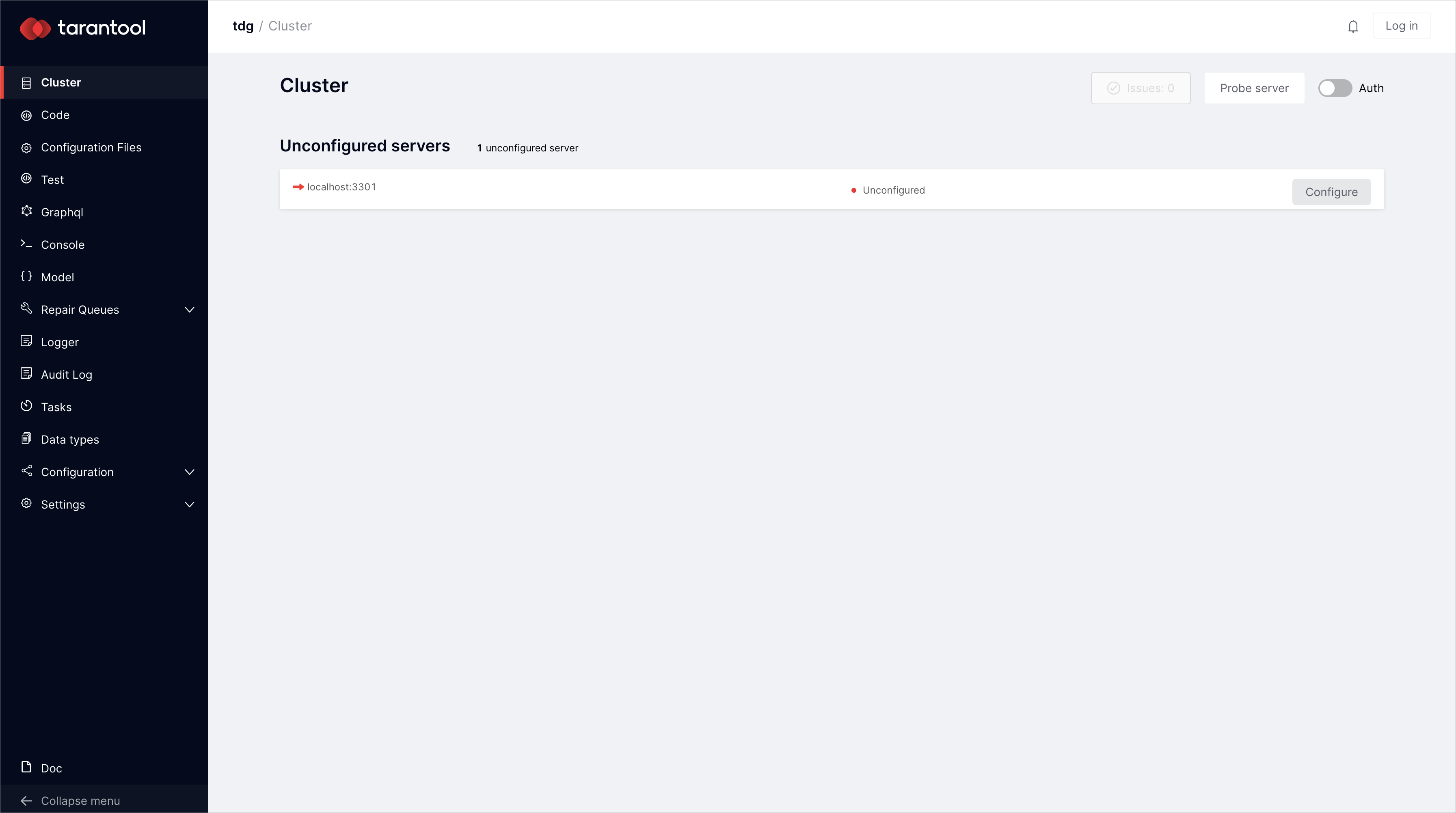

настроенный экземпляр с назначенными ролями. Если вы хотите попробовать

назначить роли самостоятельно, выполните:

В результате у вас будет экземпляр TDG в исходном состоянии:

Если вы хотите заново развернуть TDG с нуля, не забудьте сначала удалить

файлы конфигурации, а также xlog- и snap-файлы, которые были созданы при

первом развертывании TDG:

Веб-интерфейс

В этой главе рассказано, как получить доступ к веб-интерфейсу TDG и

авторизоваться в системе. Кроме того, в главе описаны элементы управления и

функции, представленные в веб-интерфейсе.

В примере ниже описана ситуация, когда авторизация в системе TDG уже

включена. Подробнее о том, как включить авторизацию, вы можете узнать из

руководства по авторизации.

Вход в систему

Чтобы получить доступ к веб-интерфейсу TDG, выполните следующие шаги:

Обратитесь к администратору за данными учетной записи.

Username: имя пользователя генерируется автоматически, когда

администратор создает профиль пользователя. Примеры

имени пользователя: ui8896, gz1200.

Password: пароль генерируется автоматически, когда администратор создает профиль пользователя.

Адрес сервера TDG: администратор задает адрес сервера в формате

http://<адрес>:<порт_http> в файле конфигурации. В этом руководстве в

качестве примера используется адрес сервера http://172.19.0.2:8080.

В браузере введите адрес сервера TDG, чтобы открыть диалоговое окно авторизации.

Введите учетные данные: в поле Username – имя пользователя, а в поле Password – пароль.

Нажмите Login.

Во время авторизации система TDG проверяет правильность ваших учетных данных

и права доступа к определенным вкладкам TDG. После успешной авторизации вы

увидите интерфейс TDG с доступом только к определенным вкладкам. Набор

вкладок зависит от роли пользователя, которую

вам назначил администратор.

Если в учетных данных окажется опечатка, TDG не сможет вас

идентифицировать. В этом случае появится сообщение «Authentication failed»:

Попробуйте ввести учетные данные еще раз.

Общее описание веб-интерфейса

Интерфейс TDG состоит из двух частей:

Панель вкладок отображает список вкладок для навигации по разделам TDG.

Рабочая область отображает содержание активной вкладки.

Панель вкладок

Доступ к той или иной вкладке зависит от роли пользователя.

Например, пользователи с ролями «admin» и «supervisor» видят все вкладки,

а пользователю с ролью «user» доступен ограниченный набор.

Кнопка Collapse menu в нижней части страницы служит для переключения панели вкладок в компактный режим и обратно.

На панели расположены следующие вкладки:

Cluster |

Конфигурация и администрирование кластера. |

Configuration files |

Управление параметрами конфигурации TDG. |

Test |

Отправка тестовых запросов в формате JSON или XML (SOAP). |

GraphQL |

Отправка запросов в формате GraphQL. |

Model |

Актуальная модель данных, загруженная в систему. |

Repair Queues: Input |

Ремонтная очередь для загруженных объектов. |

Repair Queues: Output |

Ремонтная очередь для объектов, реплицированных во внешние системы. |

Repair Queues: Jobs |

Ремонтная очередь для завершенных с ошибкой задач. |

Logger |

Журнал событий. |

Audit Log |

Журнал аудита. |

Tasks |

Управление задачами. |

Data types |

Типы данных, представленные в загруженной модели данных. |

Connectors |

Создание коннекторов и управление ими. |

Settings |

Управление настройками системы. |

Doc |

Версия документации TDG на английском языке, доступная локально из

разворачиваемого пакета TDG. Таким образом, она содержит только ту

информацию, которая была опубликована до формирования пакета. Более актуальную

документацию на русском языке вы можете найти на сайте

tarantool.io. |

Вкладка Cluster

На вкладке Cluster отображается текущий статус кластера экземпляров TDG.

На этой вкладке вы можете администрировать кластер через веб-интерфейс.

Элементы управления можно разделить на несколько групп:

В выделенной области отображается основная статистика по наборам реплик (replica sets).

Total |

Общее количество наборов реплик в кластере. |

Unhealthy |

Количество наборов реплик в статусе «unhealthy». |

Servers |

Общее количество экземпляров TDG. |

Filter |

Выпадающее меню, позволяющее фильтровать наборы реплик по статусу или кластерной роли. |

Окно поиска |

Поле для поиска наборов реплик с возможностью фильтрации по URI, UUID, роли, алиасу или меткам. |

В виджете набора реплик отображается следующая информация:

Имя и роль |

Например, набор реплик «storage_1» с ролью «storage». |

Статус |

Статус «healthy» означает, что набор реплик функционирует нормально.

Статус «unhealthy» означает, что набор реплик недоступен или функционирует неправильно. |

Вес набора реплик и группа, к которой набор относится |

Только для наборов реплик с ролью «storage».

Например: группа (storage group) — «default», вес (replica set weight) — 1. |

Кнопка Edit |

Открывает диалоговое окно, в котором можно редактировать параметры набора реплик. |

Виджеты экземпляров |

Виджеты экземпляров, включенных в этот набор реплик. |

Виджет экземпляра в выделенной области содержит следующую информацию:

Имя экземпляра |

Например, «storage_1» или «storage_1_replica». |

URI |

URI для доступа по бинарному порту.

Задается параметром advertise_uri в конфигурации кластера (например, 172.19.0.2:3003). |

Статус |

Статус «healthy» означает, что экземпляр функционирует нормально.

Статус «unhealthy» означает, что экземпляр недоступен или функционирует неправильно. |

Индикатор лидера |

Показывает, является ли экземпляр лидером (leader) в наборе реплик. |

Индикатор памяти |

Фактически используемая память / лимит памяти, заданный для этого экземпляра.

Например, 3.3 MiB / 1024.0 MiB. |

Индикатор виртуальных сегментов |

Показывает количество виртуальных сегментов экземпляра (только для наборов реплик с ролью «storage»). |

Кнопка … |

Меню с набором функций: просмотр информации об экземпляре, назначение

экземпляра лидера, отключение или исключение экземпляра. |

Подробную информацию о параметрах каждого экземпляра можно просмотреть в

режиме только для чтения. Для этого на вкладке Cluster рядом с нужным

экземпляром нажмите … > Server details:

Появится окно с подробной информацией о параметрах экземпляра:

На вкладке Cluster доступны еще несколько функций:

Issues |

Просмотр истории ошибок, возникших при работе кластера |

Probe server |

Ручная проверка доступности сервера (используется при настройке кластера) |

Auth |

Включение и отключение режима обязательной авторизации |

Failover: disabled/eventual/stateful |

Переключение режима автоматического восстановления после отказа |

Вкладка Connectors

В TDG роль connector предназначена для соединения и обмена данными с внешними системами.

Для подключения доступно несколько протоколов соединения:

http – запросы в формате JSON по HTTP;

soap – запросы в формате XML (SOAP) по HTTP;

kafka – для интеграции с шиной данных Apache Kafka;

tarantool_protocol – коннектор iproto.

На вкладке Connectors отображается список всех input-коннекторов.

Здесь вы можете создавать новые коннекторы и управлять их.

Ниже описаны доступные сценарии работы с вкладкой:

Во вкладке Connectors нажмите кнопку Add connector:

Появится окно Create connector, где нужно ввести параметры коннектора:

Параметры коннектора

При добавлении коннектора доступна настройка маршрутизации и input-параметров – параметров для получения

и парсинга входящих запросов.

Чтобы узнать больше об этих параметрах, обратитесь к разделу

Параметры коннекторов.

Ниже в таблице приведены поля, доступные для настройки в редакторе:

Название параметра |

Тип коннектора |

Описание |

Обязательный параметр |

|---|

Name |

Любой |

Имя коннектора, должно быть уникальным |

Да |

synchronous mode |

Любой |

Режим работы TDG в качестве producer. По умолчанию, режим асинхронный: подтверждение о доставке

сообщения отправляется сразу после того, как сообщение добавлено в очередь на отправку.

При синхронном режиме подтверждение о доставке

отправляется только после того, как сообщение было доставлено. |

Да |

Routing key |

Любой |

ключ маршрутизации |

Да |

Protocol type |

Любой |

Тип коннектора.

Доступные типы: http (по умолчанию), soap, kafka, tarantool_protocol. |

Да |

Path |

http

|

Адрес для отправки запроса в TDG |

Да |

WSDL |

soap

|

Схема WSDL, описывающая структуру входящего XML |

Да |

Success response template |

soap

|

Шаблон ответа в случае успешной обработки запроса |

Нет |

Error response template |

soap

|

Шаблон ответа в случае ошибки |

Нет |

Brokers |

kafka

|

URL-адреса брокеров сообщений |

Да |

Topics |

kafka

|

Топики в терминологии Kafka |

Да |

Group ID |

kafka

|

Идентификатор группы подписчиков |

Да |

Token name |

kafka

|

Имя токена приложения |

Нет |

Options |

kafka

|

Опции библиотеки

librdkafka |

Нет |

Print debug logs |

kafka

|

Режим отладки.

По умолчанию, отладка отключена.

При включении отладки по умолчанию используется параметр debug: "all".

Если в логах не требуются все атрибуты, установите необходимое значение

параметра debug в секции options при конфигурации. |

Нет |

Direct all non-error logs to TDG logger |

kafka

|

Запись всех логов Kafka, включая сообщения об ошибках, в логи TDG.

Соответствует параметру logger: tdg.

По умолчанию, в редакторе опция включена. |

Нет |

Пример

Создадим новый коннектор типа http:

Для поля Path часть адреса определена заранее и не может быть изменена.

Предопределенный адрес – это URL, на котором запущен экземпляр TDG (например, http://localhost:8080/).

В поле можно указать только последнюю часть адреса – endpoint.

Значение по умолчанию для endpoint: http.

Когда все необходимые поля заполнены, нажмите кнопку Submit.

Теперь список коннекторов выглядит следующим образом:

Столбцы Name, Protocol type, Routing key и Options в таблице можно

сортировать по возрастанию и убыванию.

Справа от каждого коннектора в списке находятся кнопки, позволяющие отредактировать его параметры или удалить коннектор:

Доступные функции:

Редактирование коннектора |

При изменении настроек существующего коннектора доступны все параметры, кроме типа коннектора.

Данные о коннекторах в редакторе можно перезаписать и извне.

Например, если загрузить во вкладку Configuration Files файл с новыми настройками

коннектора, созданного ранее в редакторе, новая конфигурация отобразится во вкладке

Connectors после обновления страницы.

|

Удаление коннектора |

При попытке удалить коннектор появится диалоговое окно с подтверждением удаления. |

Кластерные роли

В этой главе приводятся рекомендации и инструкции по настройке кластерных ролей

на экземплярах TDG.

В TDG существует четыре основных кластерных роли:

Core: настройка и администрирование.

Storage: проверка и хранение данных.

Runner: исполнение бизнес-логики с помощью кода на Lua.

Connector: обмен данными с внешними системами.

Подробная информация о кластерных ролях приведена

в разделе Кластерные роли главы Архитектура.

Рекомендации по назначению ролей на экземплярах

Исходя из сущности ролей и механизмов их работы, можно дать следующие рекомендации

по организации кластера и назначению ролей на экземплярах:

Роль core: все экземпляры должны быть объединены в один набор реплик для

обеспечения отказоустойчивой работы ядра TDG. В кластере может быть

только один набор реплик с ролью core.

Роль storage: для обеспечения распределения (sharding) и резервирования

экземпляры должны объединяться в наборы реплик из двух и более экземпляров.

Точное число экземпляров в наборе реплик определяется требованиями бизнес-решения

к избыточности хранения данных. Для большей надёжности рекомендуется объединять

в каждом наборе реплик экземпляры из разных дата-центров. Количество наборов реплик

storage следует масштабировать горизонтально пропорционально объему данных.

Роль runner: все экземпляры runner эквивалентны и не хранят состояние,

поэтому нет необходимости объединять их в наборы реплик. Количество экземпляров

runner следует масштабировать горизонтально в зависимости от входящей нагрузки

и утилизации CPU.

Роль connector: все экземпляры connector эквивалентны и не хранят состояние,

поэтому нет необходимости объединять их в наборы реплик. Количество экземпляров

connector следует масштабировать горизонтально в зависимости от входящей нагрузки

и утилизации CPU.

Объединение ролей connector и runner: обычно имеет смысл назначать роли

connector и runner на экземпляры вместе. Таким образом минимизируется

сетевое взаимодействие при обработке входящих объектов или вызове сервисов извне.

Настройка кластерных ролей через WebUI

Для настройки кластерных ролей через веб-интерфейс TDG используются инструменты

на вкладке Cluster.

Назначение ролей новым экземплярам

Чтобы назначить роль экземпляру впервые, найдите его в списке Unconfigured Instances

и нажмите соответствующую кнопку Configure.

В открывшемся окне вы можете назначить роль одним из двух способов:

Создать новый набор реплик с нужными ролями.

Для этого введите имя нового набора реплик, выберите необходимые роли и

нажмите Create replica set.

Добавить экземпляр в существующий набор реплик.

Для этого перейдите на вкладку Join replica set, выберите один из

существующих наборов реплик с необходимыми ролями и нажмите

Join replica set.

Изменение ролей

Чтобы изменить роли набора реплик, откройте окно его редактирования (Edit replica set)

и включите или отключите роли. Эти изменения применятся ко всем экземплярам выбранного

набора реплик.

Предупреждение

При отключении роли storage на наборе реплик необходимо перераспределить

сегменты данных, которые на нём хранятся, на другие наборы реплик.

Для этого перед отключением роли storage установите набору реплик вес

(Replica set weight) равным 0 и нажмите Save.

После этого убедитесь, что в наборе реплик не осталось сегментов данных

и отключите на нём роль storage.

Настройка кластерных ролей через Ansible

Если вы разворачиваете кластер TDG с помощью Ansible,

вы можете определить наборы реплик и их роли в inventory-файле hosts.yml.

Наборы реплик и их роли определяются в inventory-файле в разделе all.children.

Для каждого набора реплик необходимо создать узел с именем replicaset_<name>,

где <name> – название, под которым набор реплик будет использоваться в кластере.

Пример создания набора реплик с именем storage_01:

all:

children:

replicaset_storage_01:

В узле набора реплик задаются два раздела:

vars – параметры набора реплик, в том числе параметр roles – список

назначенных ролей.

hosts – список узлов, входящих в набор реплик.

Пример конфигурации набора реплик с ролью storage из двух узлов:

all:

children:

replicaset_storage_01:

vars: # replica set configuration

replicaset_alias: storage-01

weight: 1

failover_priority:

- storage-01 # leader

- storage-01-r

roles:

- 'storage'

Конфигурация кластера из пяти узлов с тремя наборами реплик (два storage и

один с ролями core, runner, connector) может выглядеть следующим образом:

all:

children:

replicaset_storage_01:

vars: # replica set configuration

replicaset_alias: storage-01

weight: 1

failover_priority:

- storage-01 # leader

- storage-01-r

roles:

- 'storage'

hosts: # replica set instances

storage-01:

storage-01-r:

replicaset_storage_02:

vars: # replica set configuration

replicaset_alias: storage-02

weight: 1

failover_priority:

- storage-02 # leader

- storage-02-r

roles:

- 'storage'

hosts: # replica set instances

storage-02:

storage-02-r:

replicaset_app_01:

vars: # replica set configuration

replicaset_alias: app-01

failover_priority:

- app-01 # leader

roles:

- 'core'

- 'connector'

- 'runner'

Настройки безопасности

В этой главе рассказано, как управлять настройками политики безопасности.

Контроль доступа на основе ролей

В Tarantool Data Grid используется основанная на ролях модель доступа к

системным функциям и данным, хранящимся в системе. Администратор настраивает

права доступа к данным, используя UI или такие внешние инструменты, как

LDAP. Каждая роль имеет набор разрешений, которые определяют, что

пользователи или внешние приложения могут просматривать или изменять.

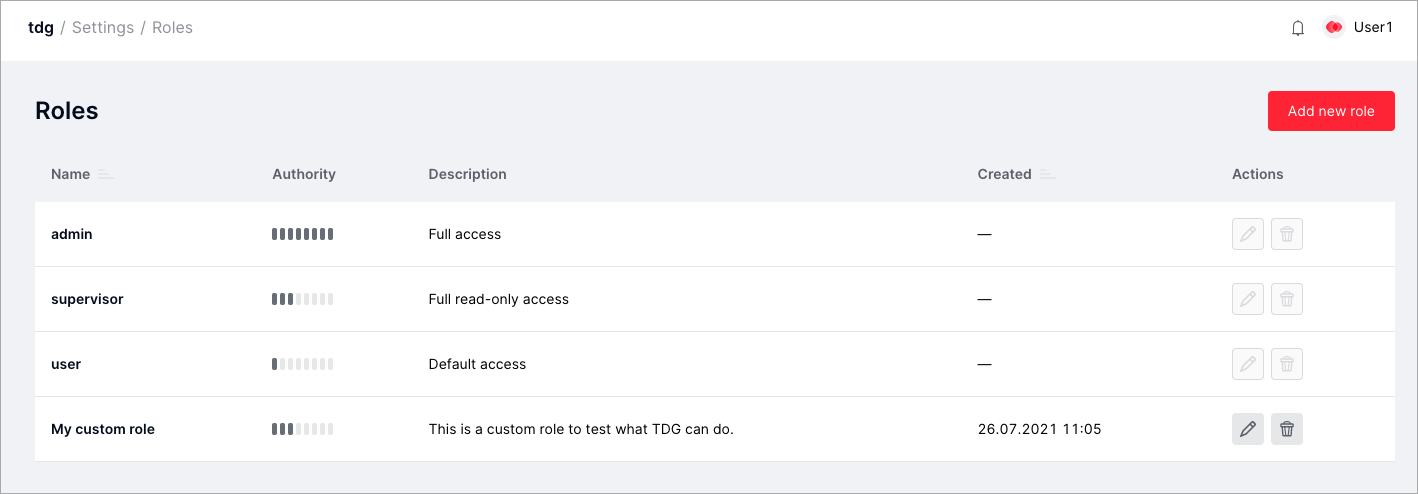

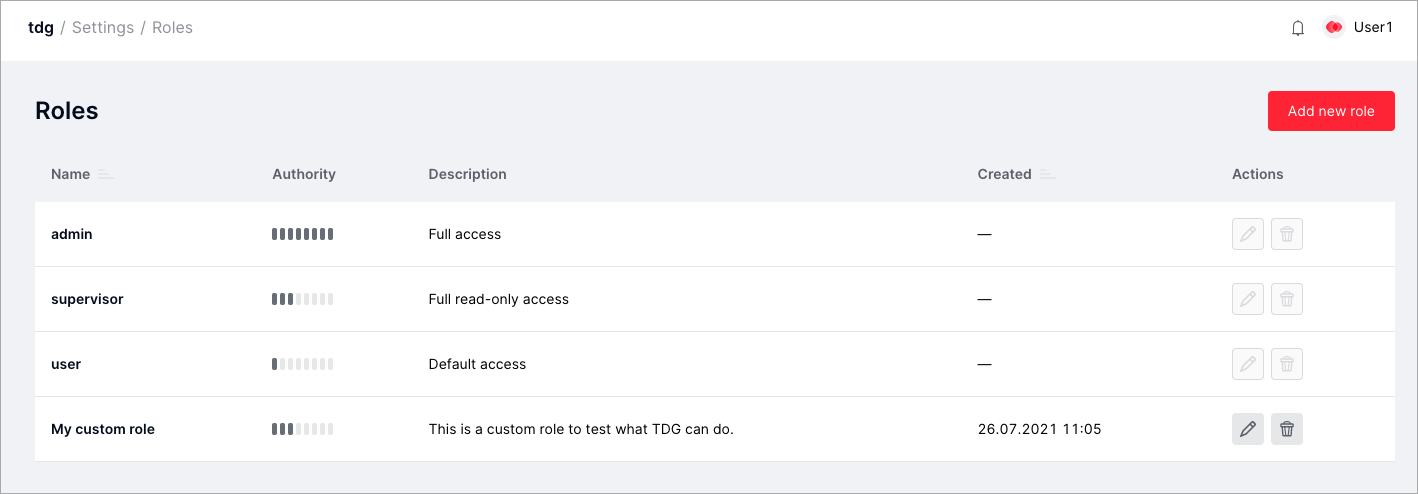

Список ролей можно найти на вкладке Settings > Roles:

Роли по умолчанию

Пользователям и внешним приложениям можно назначать роли. Эти роли позволяют

получать авторизованный доступ к определенным данным и выполнять в системе

те или иные действия. Существует три роли по умолчанию:

Эти роли имеют предопределенный набор прав. Кроме того, такие роли нельзя редактировать или удалять.

Роль |

Доступ к функциям |

Доступ к данным |

|---|

admin |

Полный доступ ко всем функциям TDG |

Доступ для чтения и записи для всех агрегатов |

supervisor |

Полный доступ в режиме «только для чтения» |

Доступ для чтения для всех агрегатов |

user |

По умолчанию: доступ к вкладке Test для отправки объектов тестирования,

а также ко вкладкам Repair Queues, Tasks и GraphQL |

— |

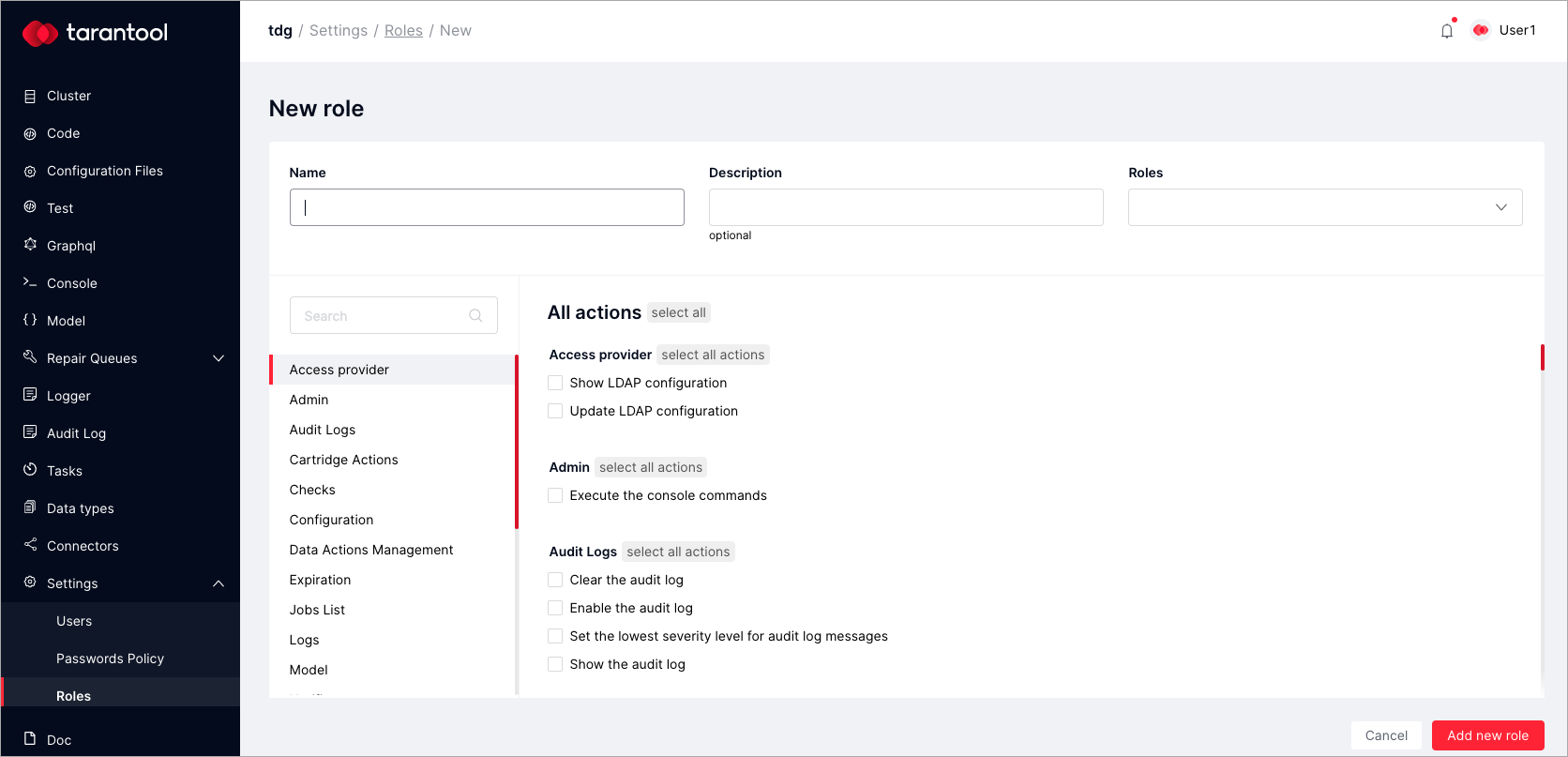

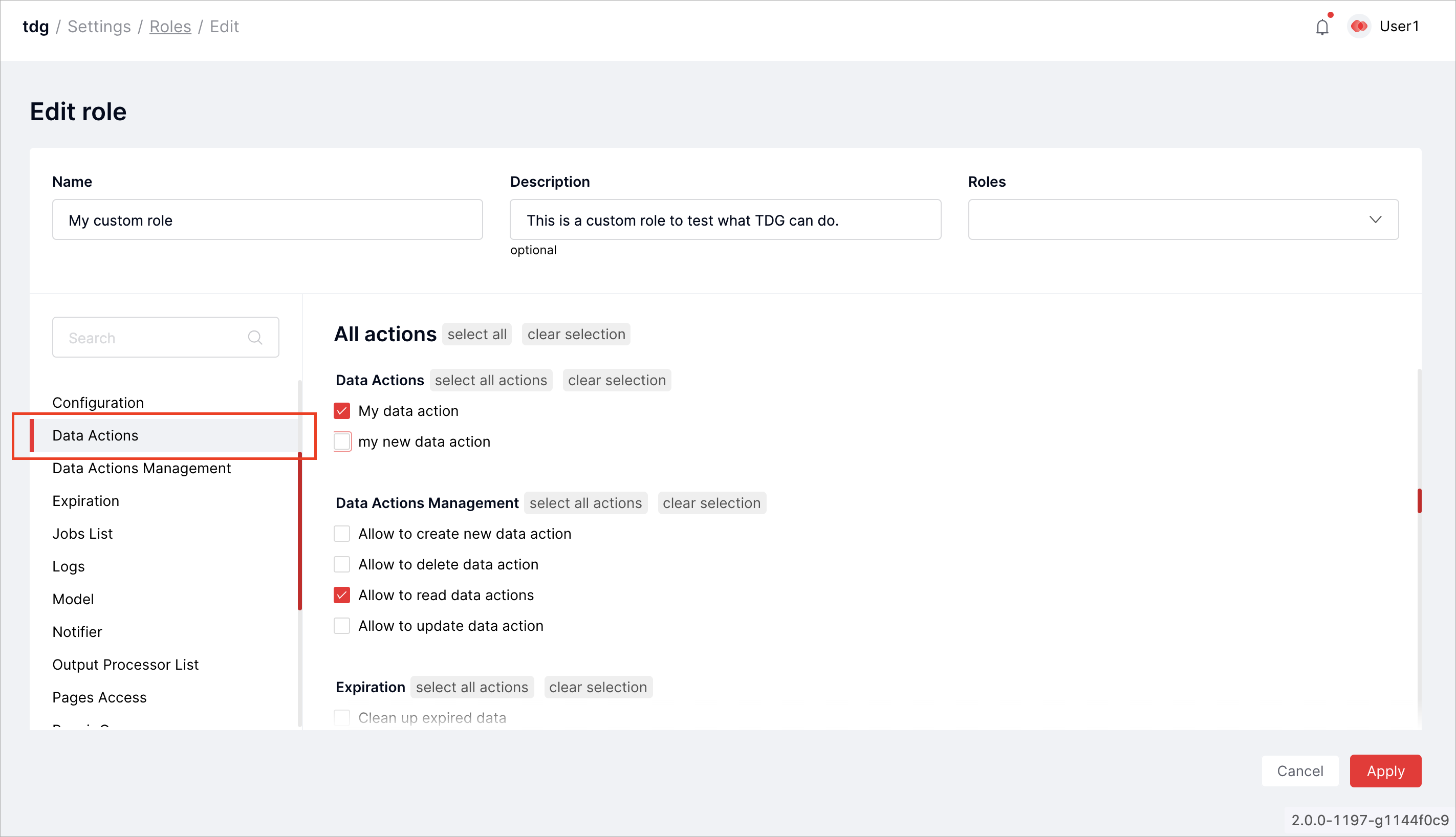

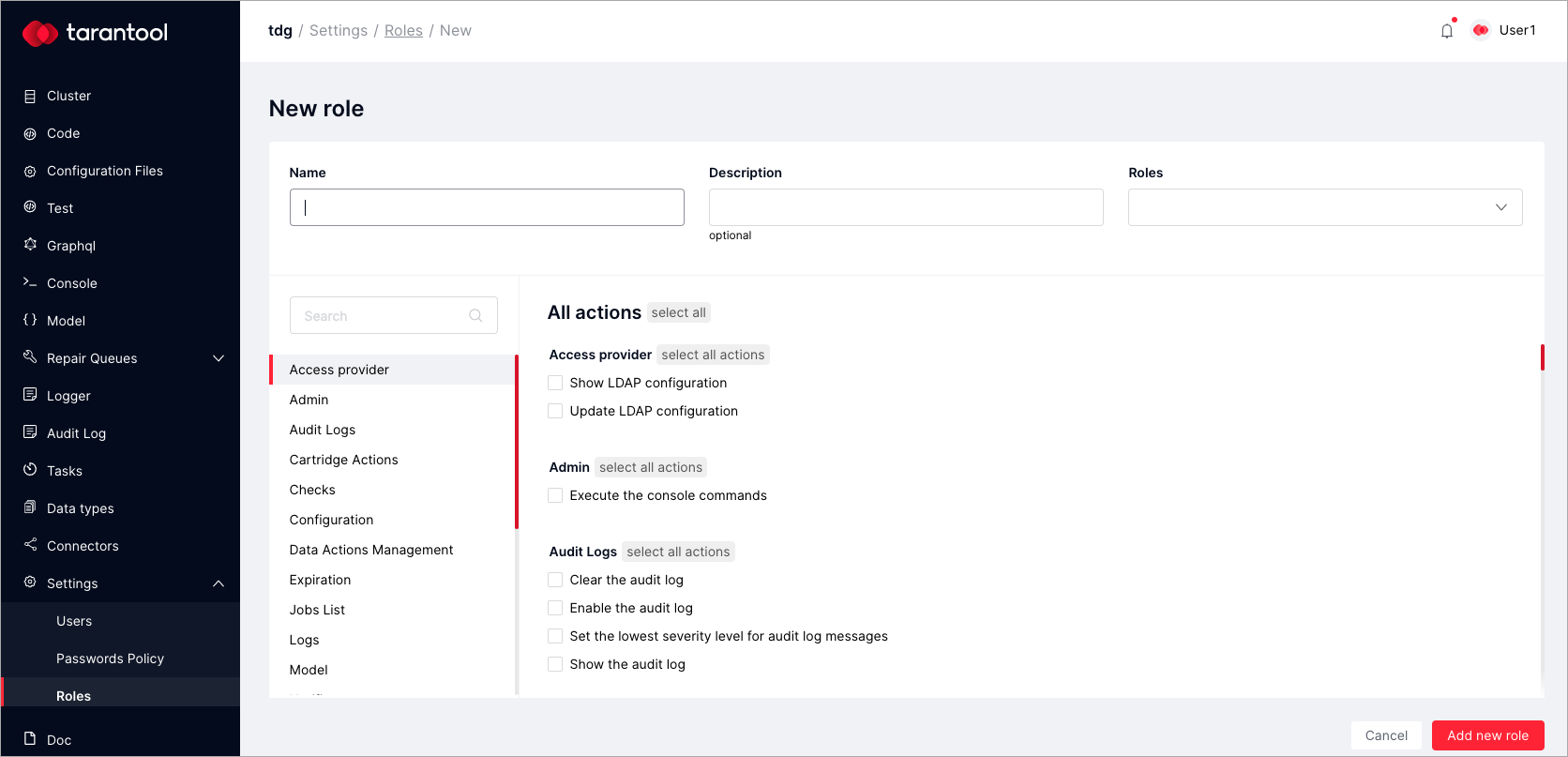

Создание новых ролей пользователей с помощью UI

Новую роль можно создать на основе роли по умолчанию или же ранее созданной роли.

Чтобы создать новую роль пользователя, выполните следующие шаги:

Откройте вкладку Settings > Roles и нажмите Add new role.

В диалоговом окне New role укажите следующие параметры:

Name: название новой роли.

Description: описание роли (опционально).

Roles: существующая роль, на основе которой будет создаваться новая (опционально).

В списке выберите действия, которые будут доступны для роли пользователя.

Не забудьте проверить, есть ли у роли доступ к интерфейсу. Например, если вы

собираетесь дать роли права на выполнение запросов GraphQL, отметьте Pages Access > Show GraphQL page.

Нажмите Add new role.

Создав роль пользователя, вы можете в любое время отредактировать ее или удалить.

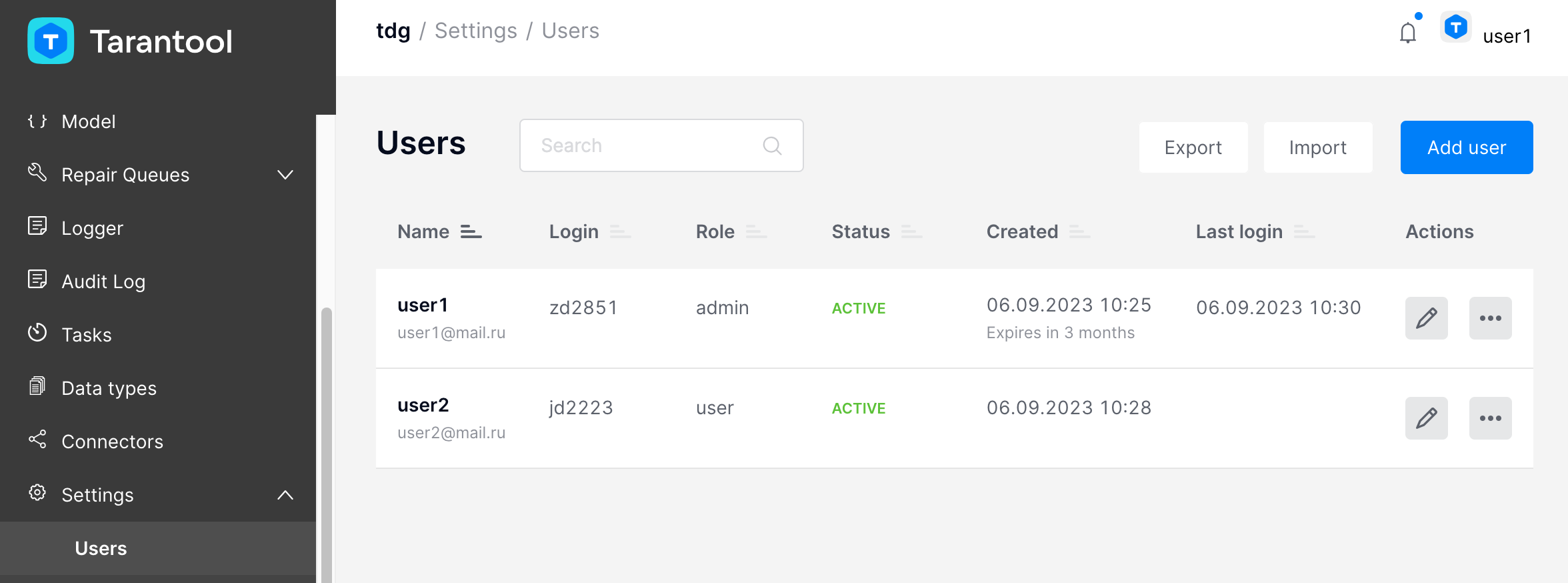

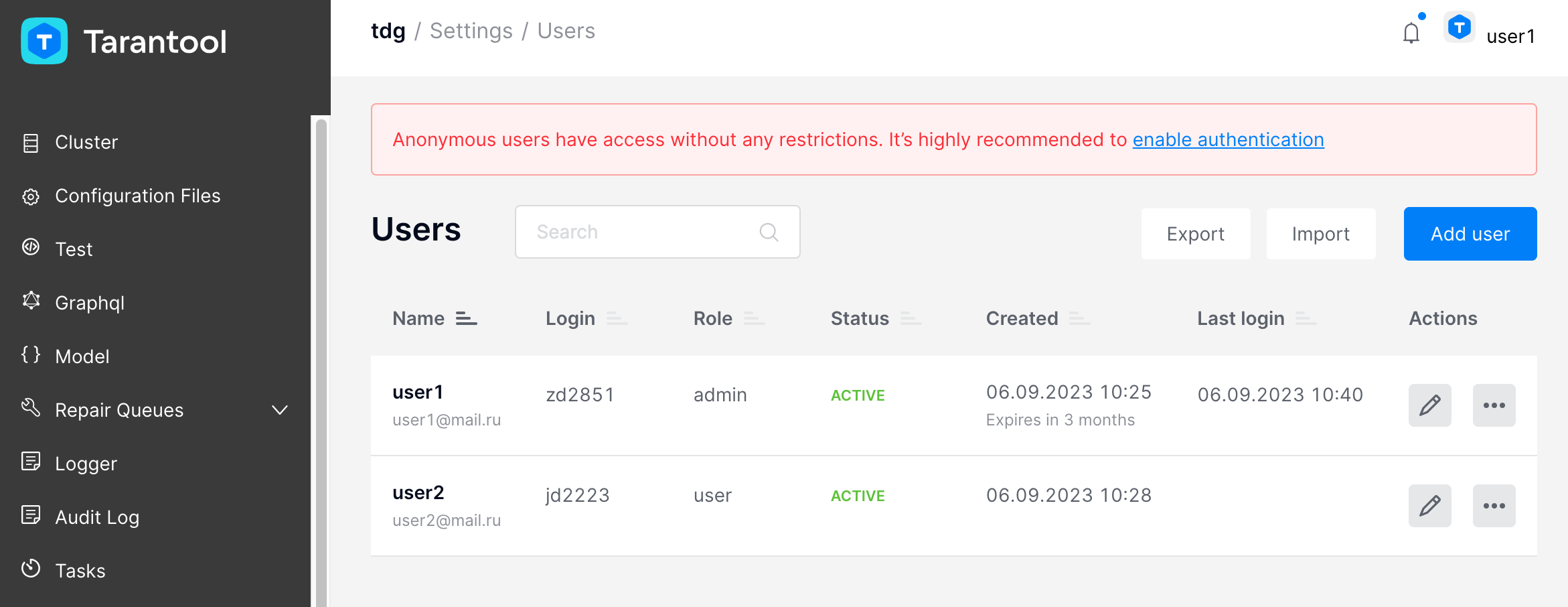

Управление пользователями

В этой главе рассматриваются операции управления пользователями TDG:

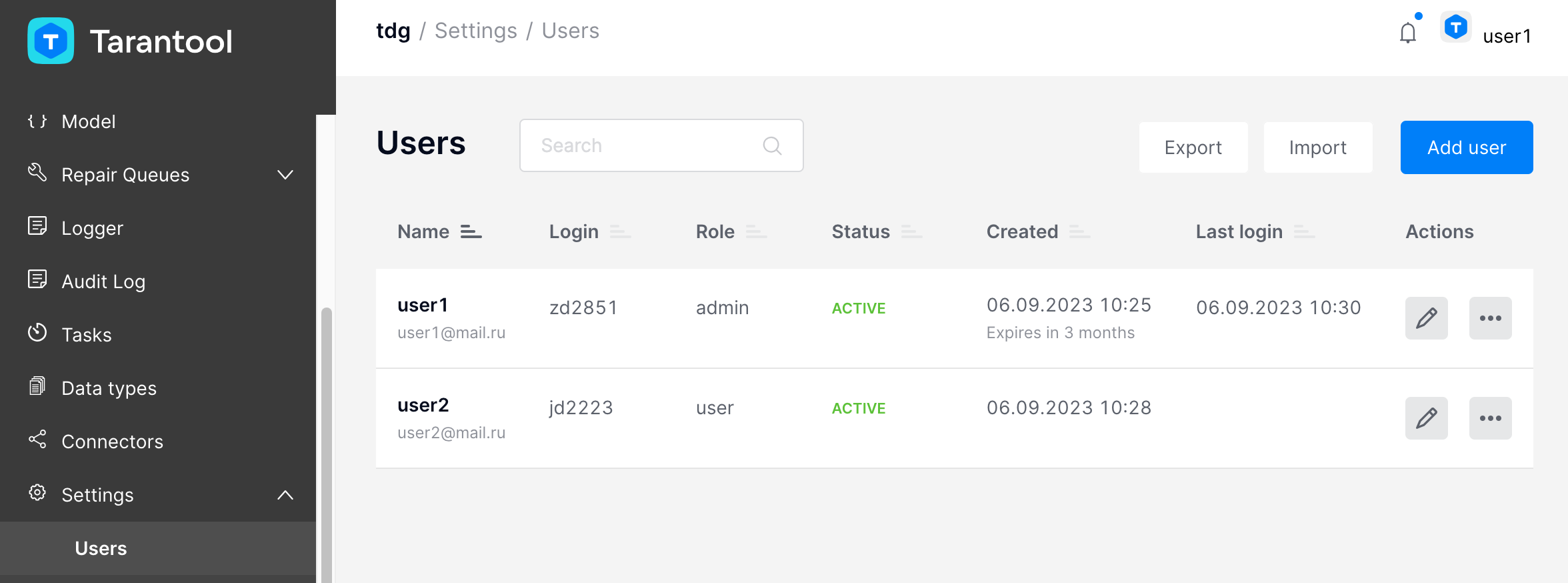

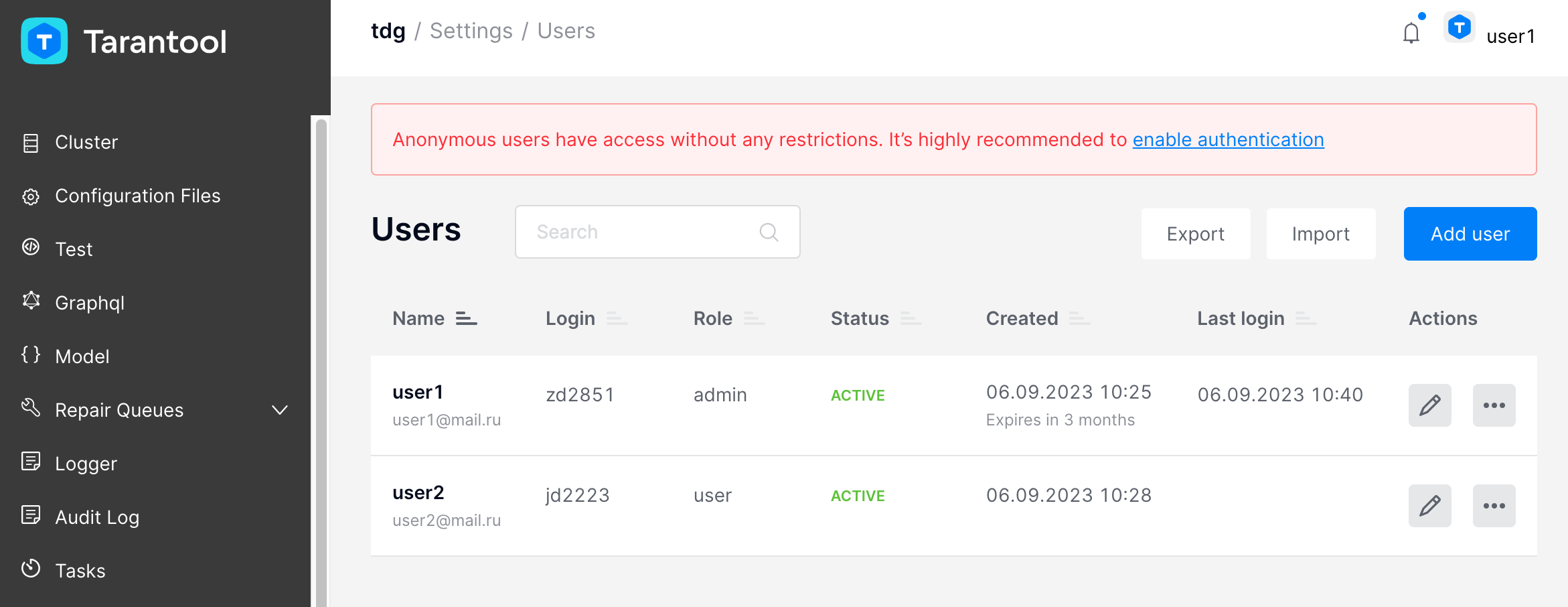

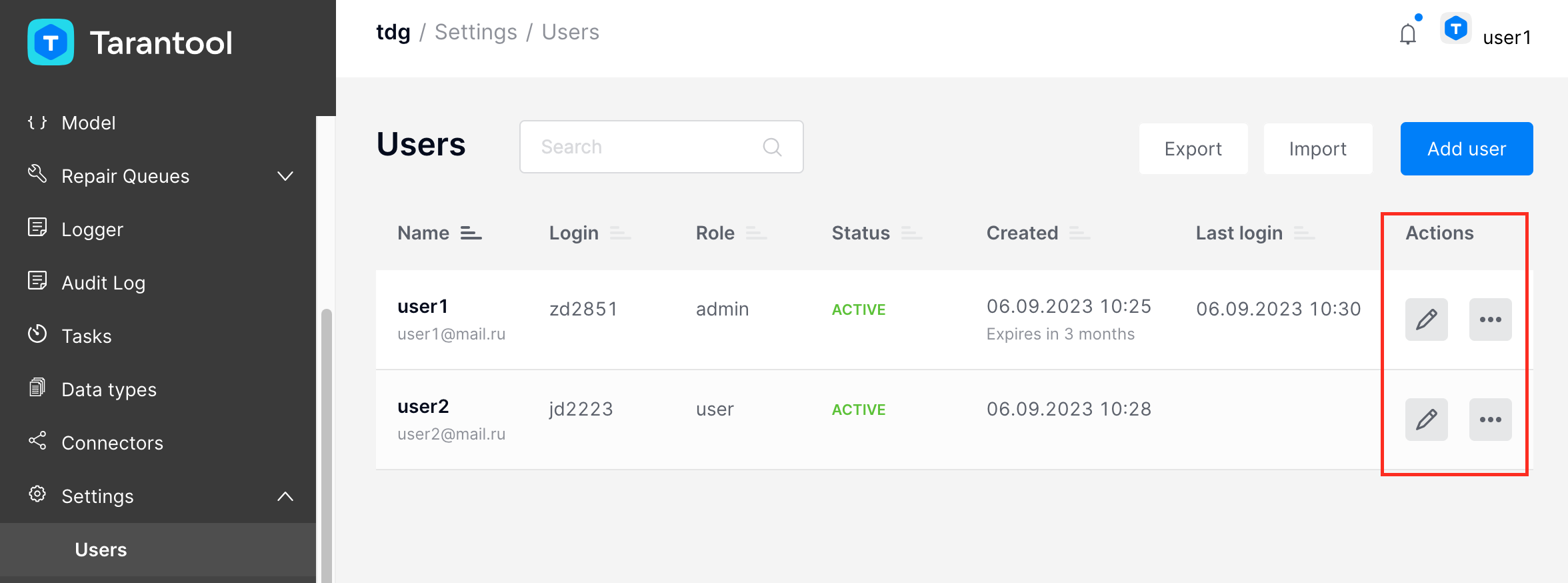

Список пользователей находится на вкладке Settings > Users:

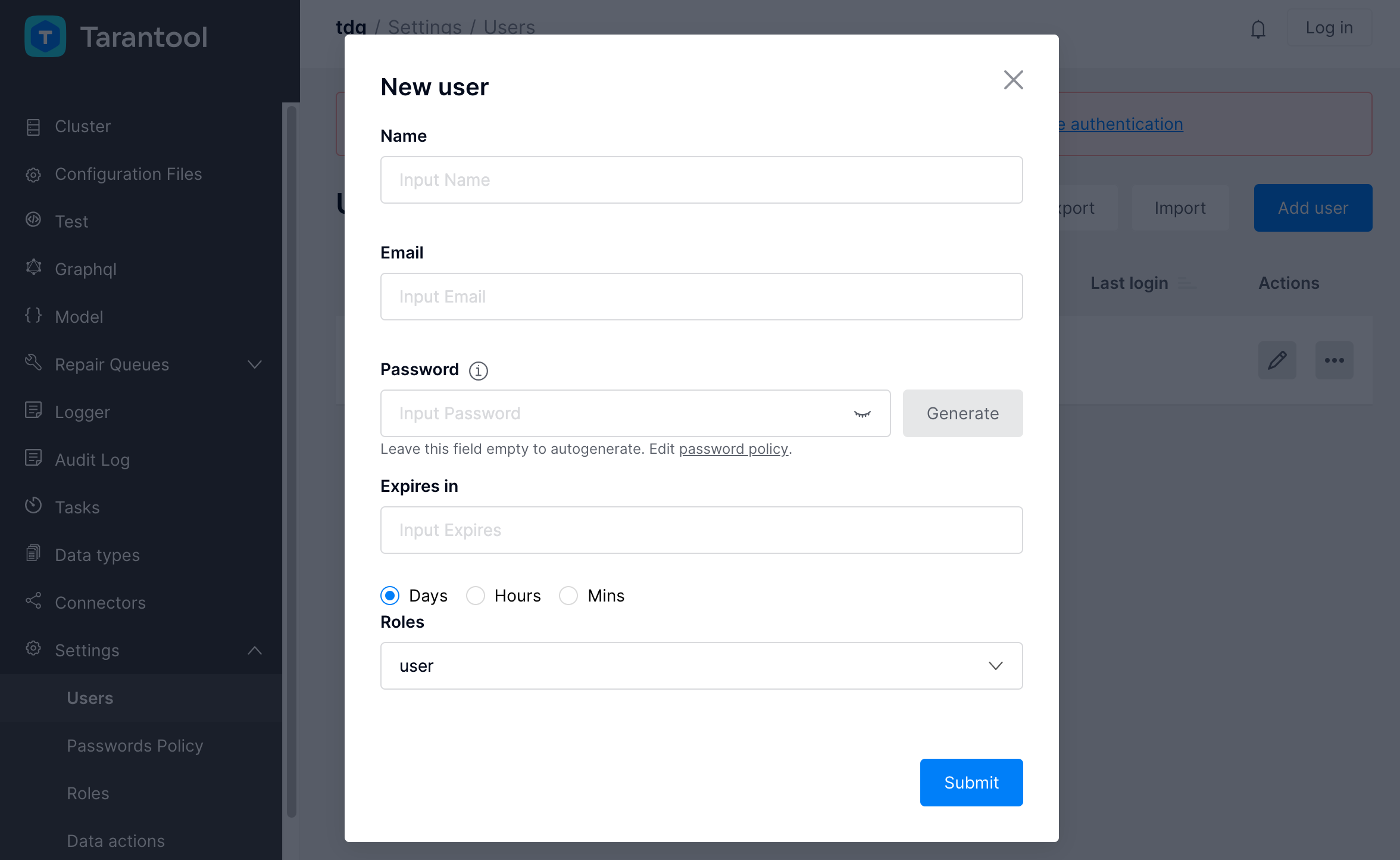

Создание профиля пользователя

Чтобы создать профиль пользователя TDG, выполните следующие шаги:

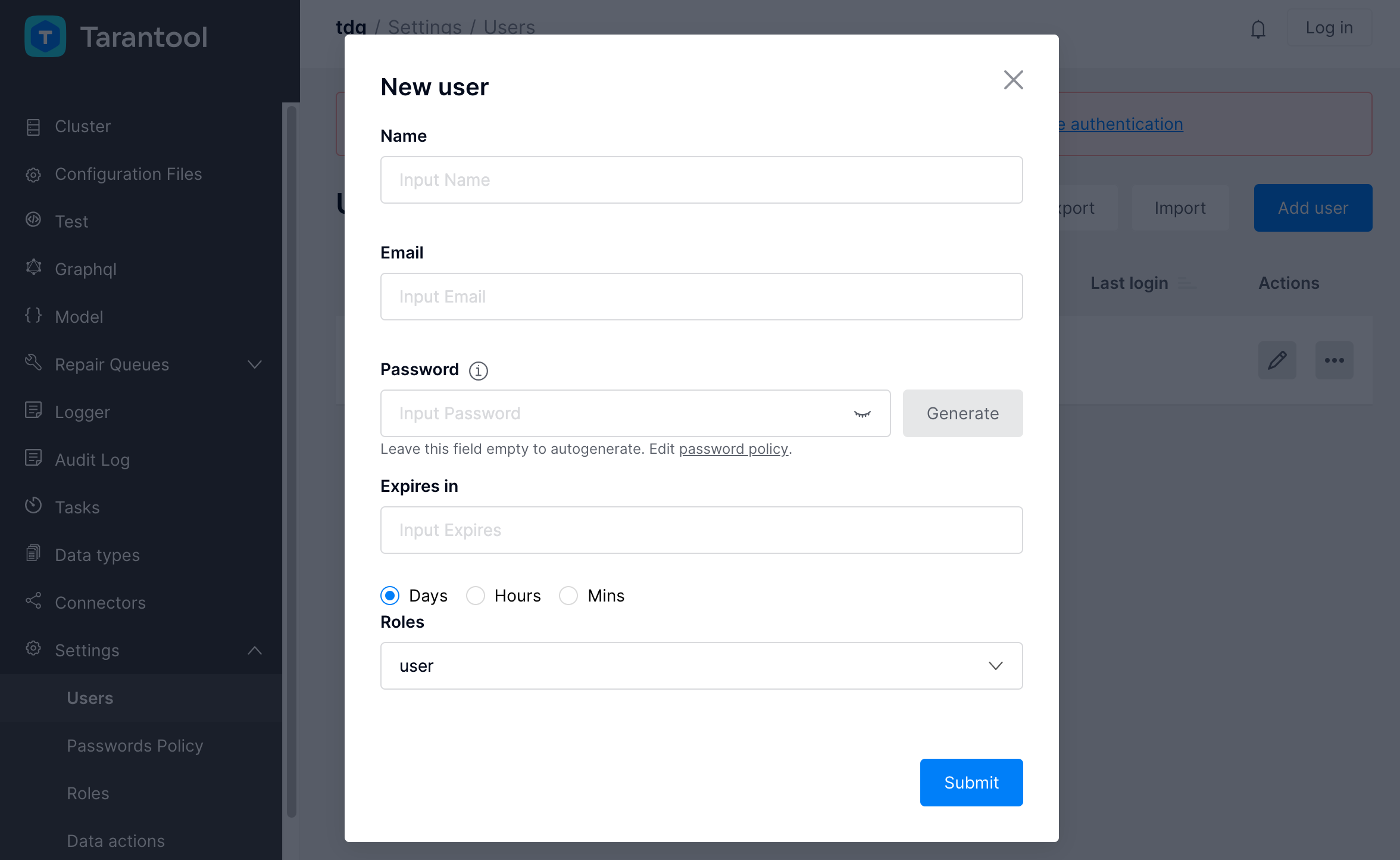

Откройте вкладку Settings > Users. Нажмите Add new user.

Откроется диалоговое окно создания пользователя New user:

В окне New user укажите следующие параметры:

Name: имя пользователя.

Email: электронная почта пользователя.

Password: пароль для авторизации в системе. Сгенерируйте пароль сразу,

нажав кнопку Generate, или оставьте поле пустым, чтобы система отправила

автоматически сгенерированный пароль на адрес электронной почты, указанный

в поле Email. В последнем случае необходим настроенный SMTP-сервер.

Expires in: срок действия пароля (опционально). Система проверяет, не

истек ли срок действия паролей, примерно раз в 30 минут. Учетные записи, у

которых истек срок действия пароля, блокируются.

Role: роль пользователя согласно ролевой модели доступа.

Нажмите Submit.

Созданного пользователя вы увидите в общем списке.

Теперь можно отредактировать его профиль: изменить настройки, сбросить пароль, а также

заблокировать или удалить профиль.

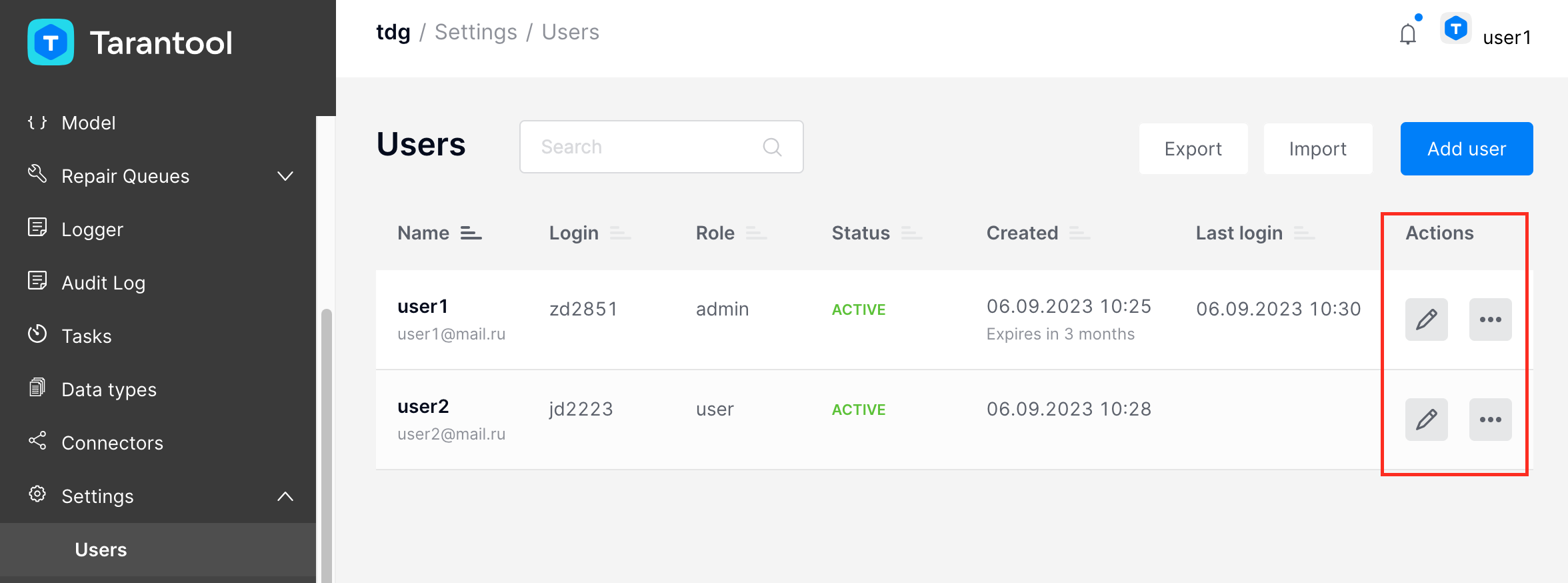

Редактирование профиля пользователя

Чтобы отредактировать профиль пользователя, откройте вкладку Settings > Users и нажмите на значок карандаша:

Измените настройки профиля и нажмите Submit.

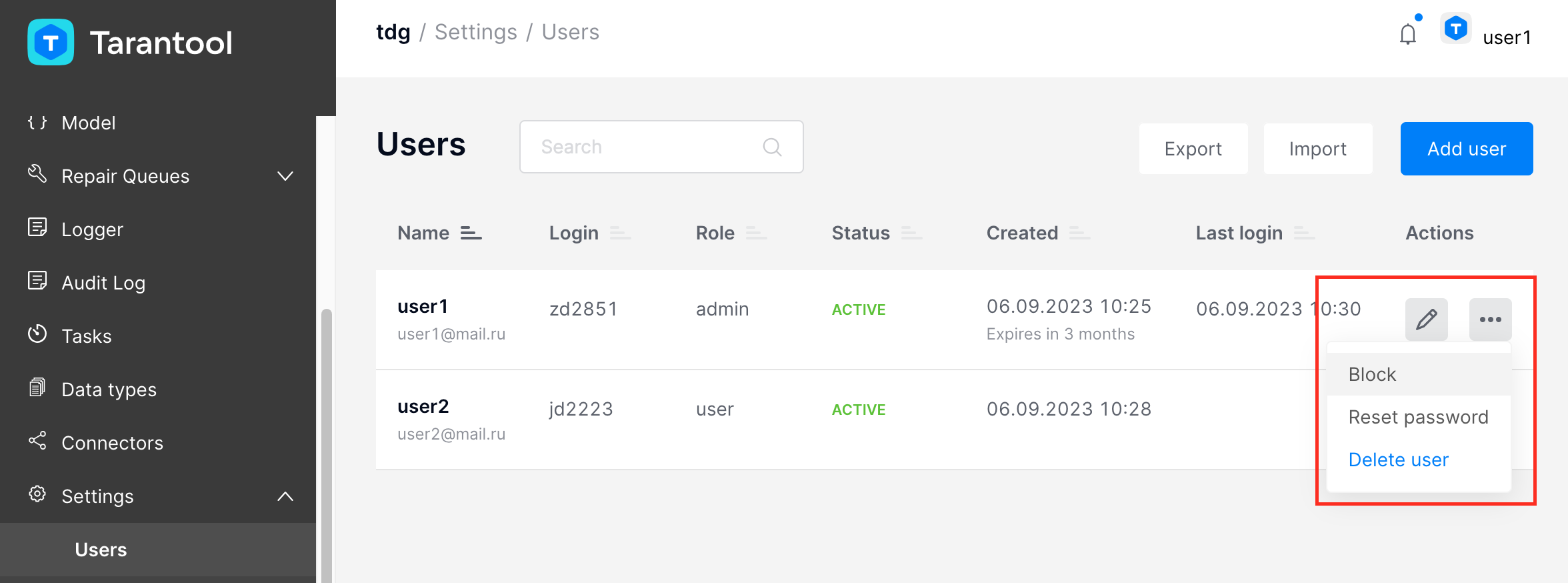

Удаление профиля пользователя

Администратор может удалить из списка любой профиль пользователя:

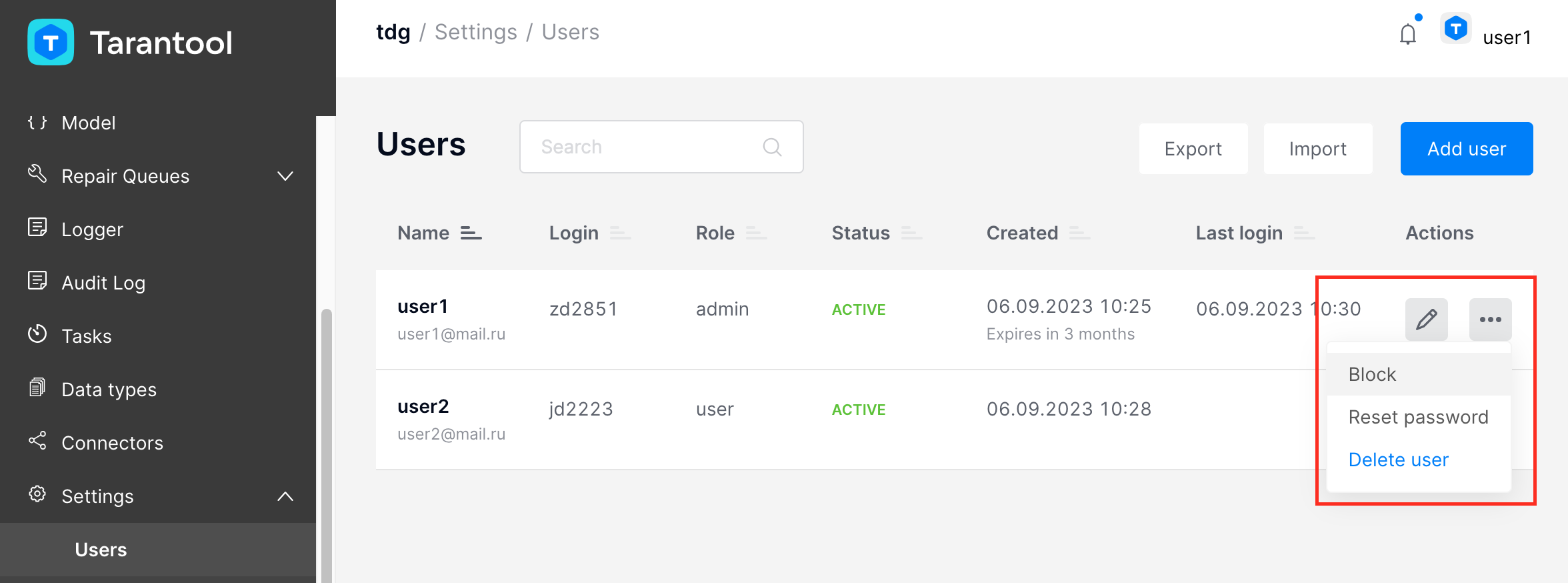

В колонке Actions найдите профиль нужного пользователя. В меню действий

... выберите Delete user.

В диалоговом окне подтвердите удаление пользователя, нажав OK.

Пользователь будет удален из общего списка автоматически.

Созданный профиль будет сразу активирован в системе. В списке пользователей

напротив этого профиля в колонке Status появится статус «ACTIVE».

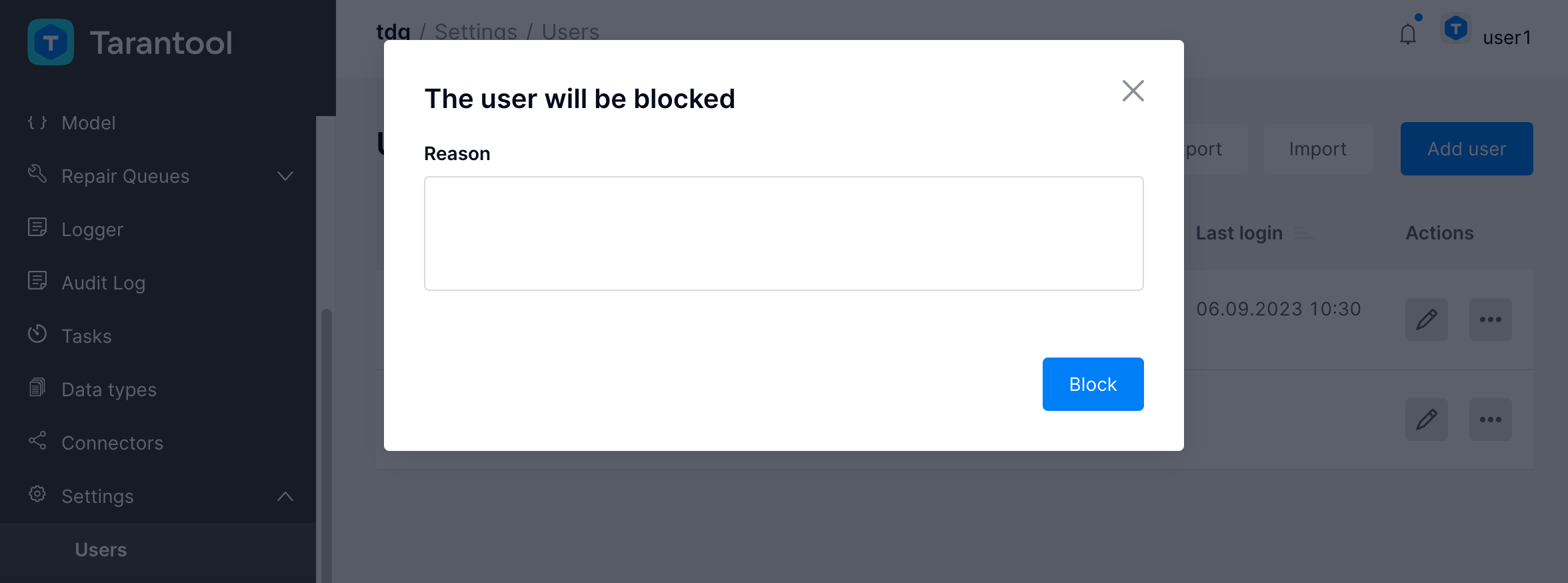

Администратор может изменить этот статус и заблокировать пользователя:

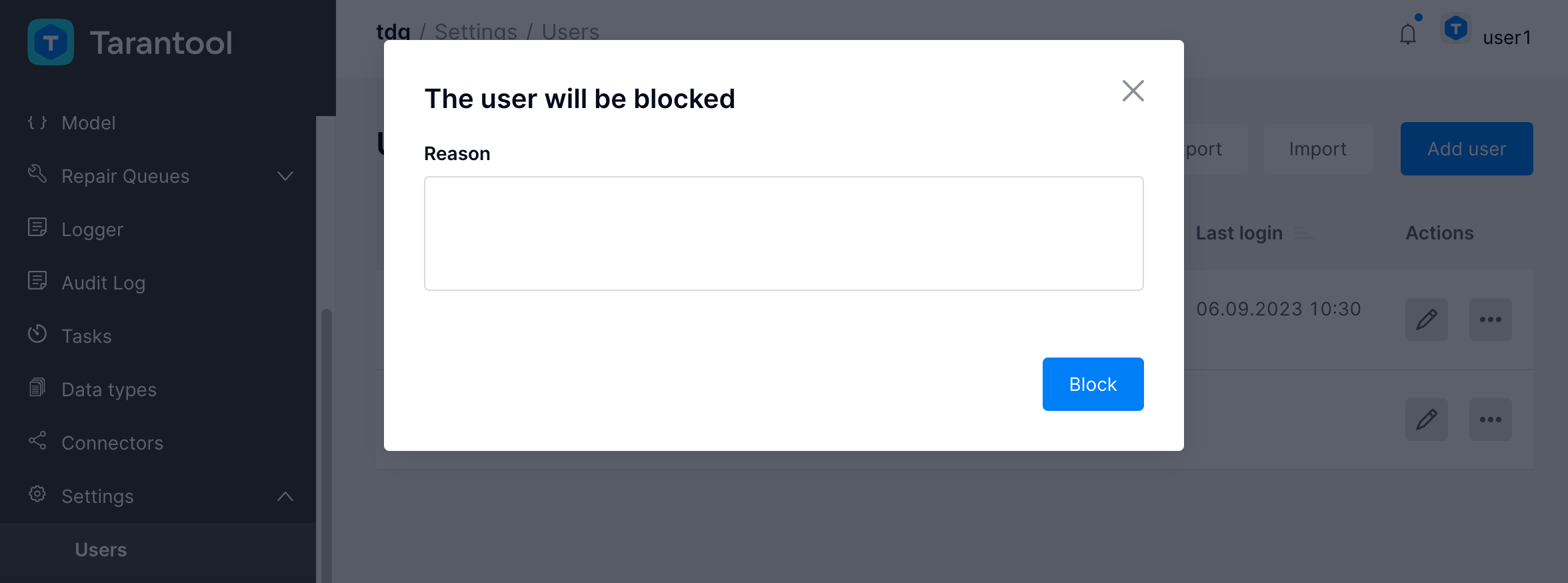

В колонке Actions в меню действий ... выберите Block:

В диалоговом окне опишите причину блокировки пользователя и нажмите Block:

После этого статус пользователя изменится на «BLOCKED». Чтобы

разблокировать пользователя, в меню действий ... выберите Unblock.

Сброс пароля

Администратор может сбросить пароль любого из пользователей:

В колонке Actions найдите профиль пользователя, который вы хотите

отредактировать, и в меню действий ... выберите Reset password.

В диалоговом окне подтвердите сброс пароля, нажав OK.

После этого пользователю придет временный пароль на электронную почту, указанную в его профиле.

Примечание: чтобы отправлять временные пароли, настройте SMTP-сервер.

Чтобы организовать отправку временных паролей, выполните следующие шаги:

Разверните и запустите SMTP-сервер.

В файле конфигурации TDG config.yml пропишите следующие настройки:

connector:

output:

- name: to_smtp

type: smtp

url: <URL SMTP-сервера>

from: <адрес отправителя>

timeout: <время ожидания в секундах>

account_manager:

only_one_time_passwords: true

output:

name: to_smtp

Пример:

output:

- name: to_smtp

type: smtp

url: localhost:2525

from: tdg@example.com

timeout: 5

Загрузите измененную конфигурацию в систему.

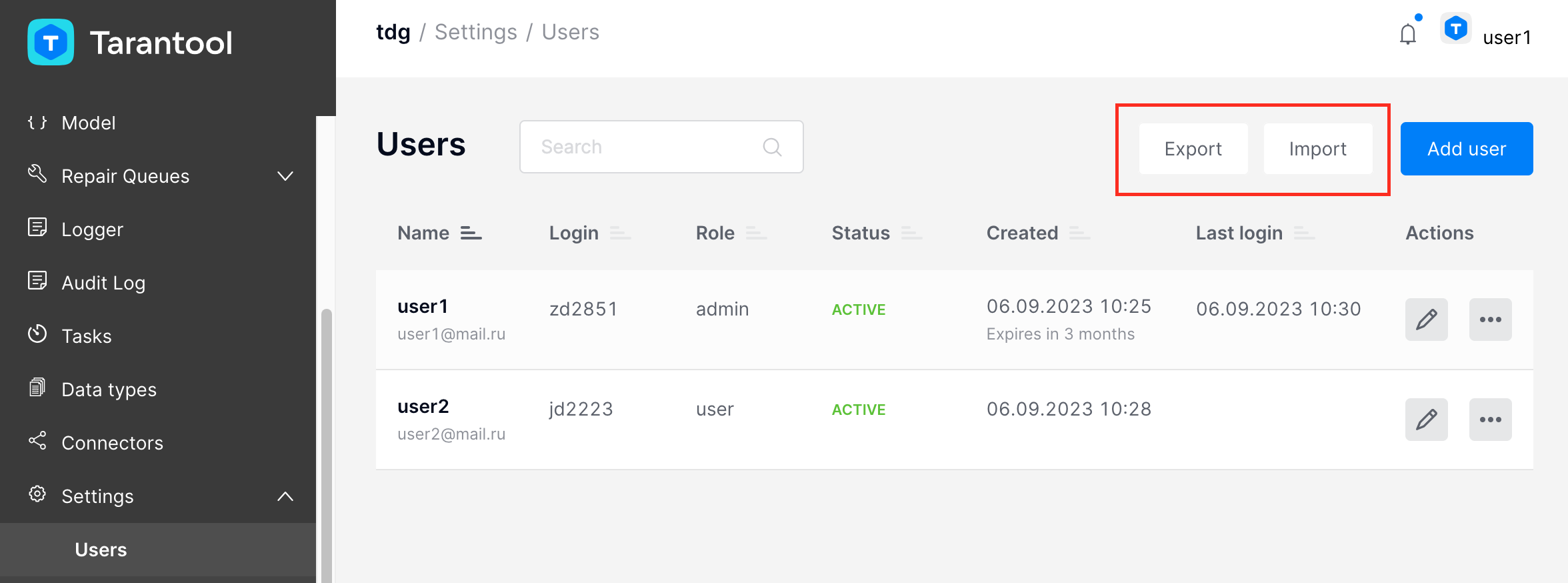

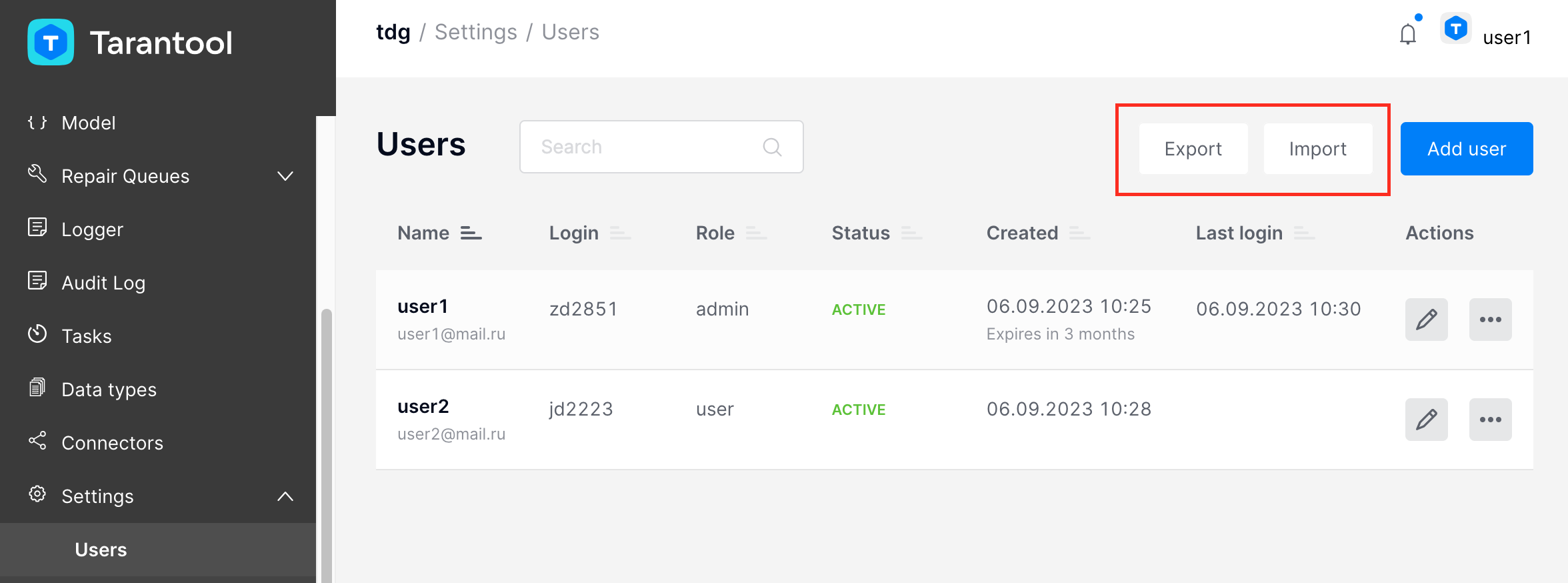

Профили пользователей можно экспортировать из системы и импортировать в нее в формате JSON:

Экспорт профилей пользователей

На вкладке Settings > Users нажмите Export. Система сформирует и

экспортирует файл JSON, содержащий массив с профилями всех текущих

пользователей.

Пример профиля пользователя:

[

{

"expires_in":2592000,

"login":"ui8896",

"email":"test@mail.ru",

"created_at":1626360261875418600,

"state_reason":"test@mail.ru state is changed to active: recover from disabled",

"failed_login_attempts":1,

"uid":"bd2e91f3-ce0f-4ff1-8aae-bc4212f99c7d",

"role":"admin",

"state":"active"

,"username":"User1",

"last_login":1628058891852268000,

"last_password_update_time":null

},

{

...

}

]

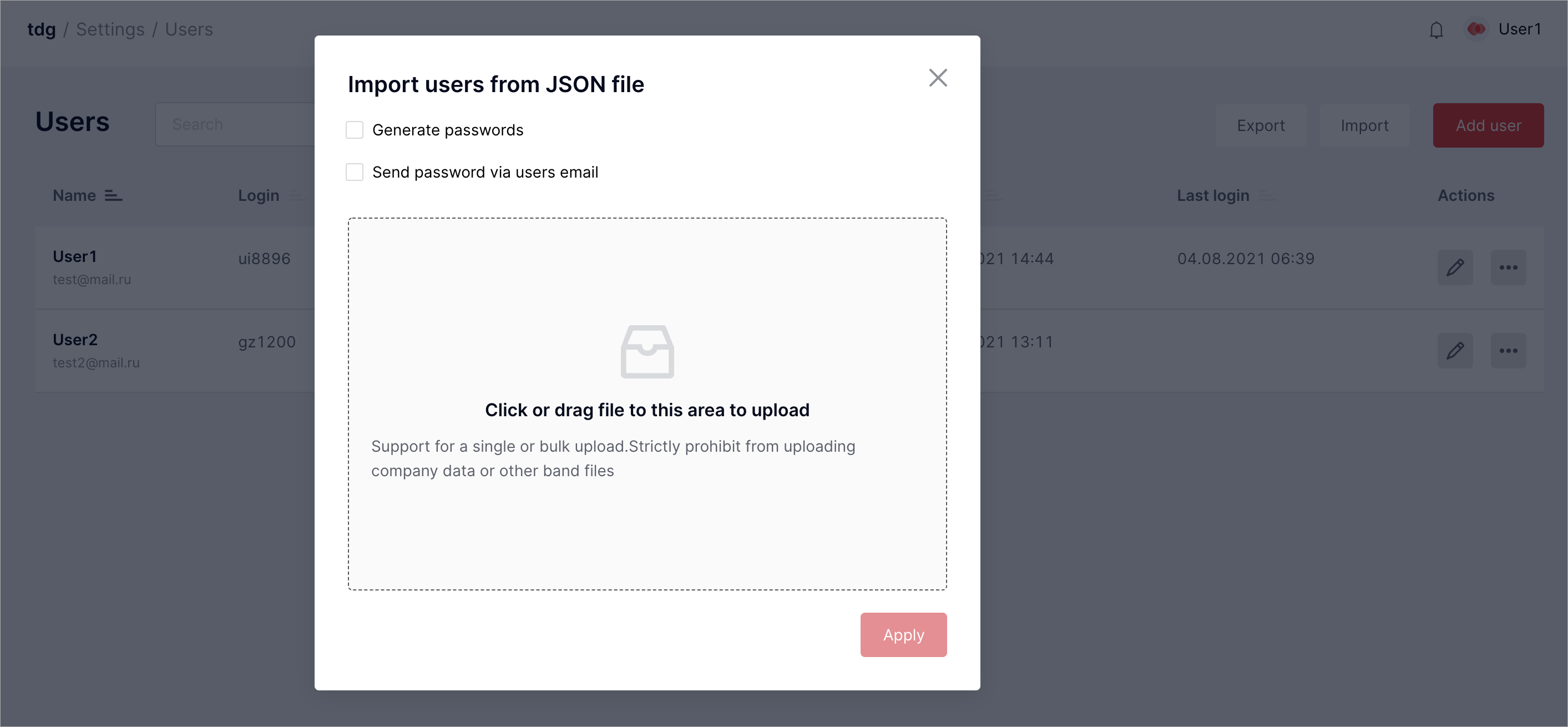

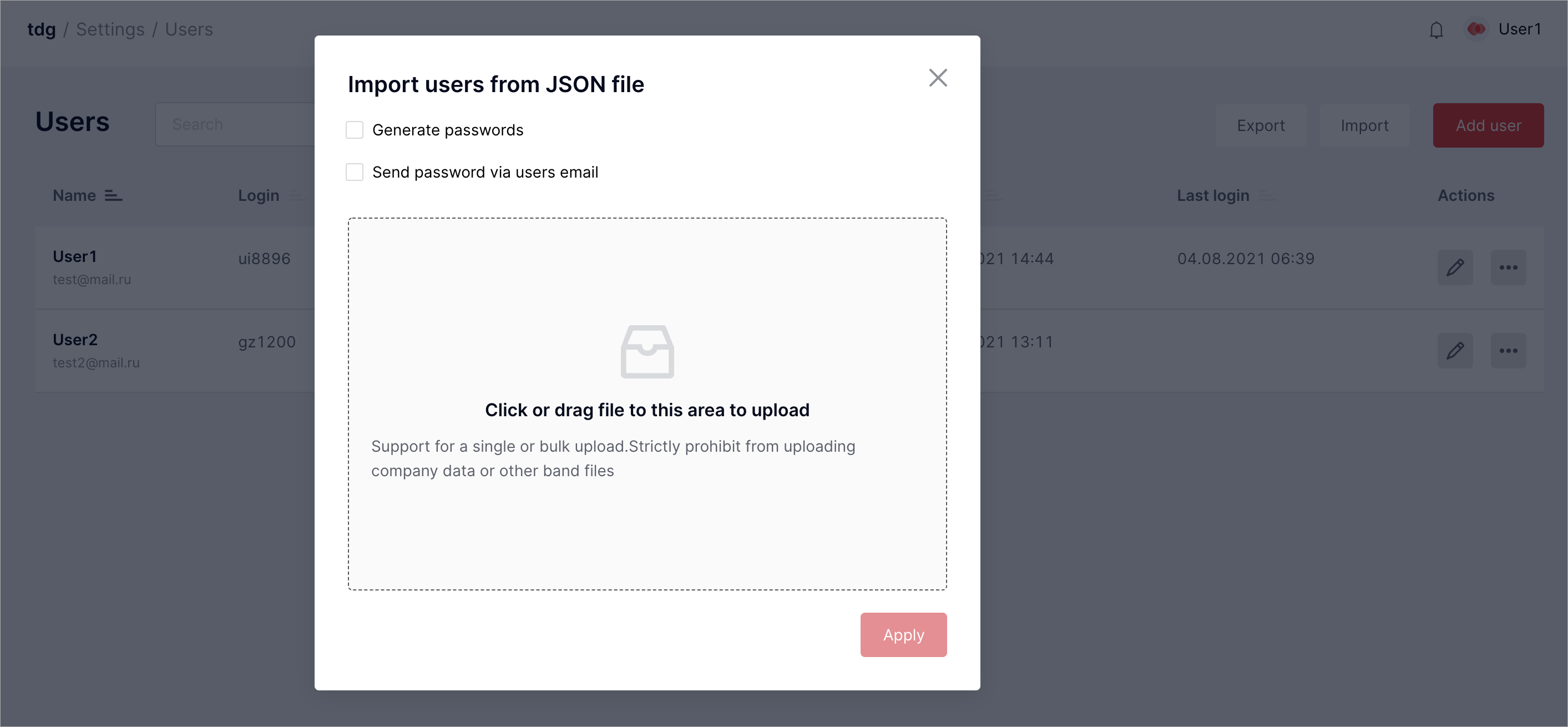

Импорт профилей пользователей

Для импорта необходим файл в формате JSON с профилями пользователей. Этот

файл можно подготовить вручную или же сформировать его и экспортировать, как

описано выше. В файле JSON нужно задать все поля, указанные выше в примере

профиля пользователя, за исключением state_reason, last_login,

last_password_update_time и password.

Пароль можно задать несколькими способами:

Вручную. В файле JSON укажите для каждого пользователя пароль в поле password.

Пароль должен соответствовать требованиям политики в отношении паролей.

В диалоговом окне импорта профилей пользователей не отмечайте никакие параметры.

Пароли будут загружены из файла JSON как есть.

Сгенерировать автоматически. Задайте null в поле password или вообще не указывайте это поле в файле JSON.

В диалоговом окне импорта профилей пользователей выберите Generate passwords.

Пароль будет создан автоматически в соответствии с требованиями текущей политики в отношении паролей.

Отправить на адрес электронной почты. Для этого необходим SMTP-сервер.

В диалоговом окне Import users from JSON file выберите Send password via users email.

Нужно выбрать единственный вариант создания паролей для всех импортируемых профилей пользователей.

Чтобы импортировать профили пользователей, выполните следующие шаги:

На вкладке Settings > Users нажмите Import.

Если необходимо, в диалоговом окне импорта профилей пользователей отметьте способ создания паролей, который вы выбрали.

Загрузите файл JSON с профилями пользователей и нажмите Apply.

Новые профили пользователей будут добавлены в таблицу Users.

В веб-интерфейсе вы увидите сообщение о результатах импорта, где будут указаны данные профилей.

Вы можете сохранить импортированные данные, в том числе сгенерированные пароли, нажав кнопку Download.

Данные будут сохранены в файле .csv.

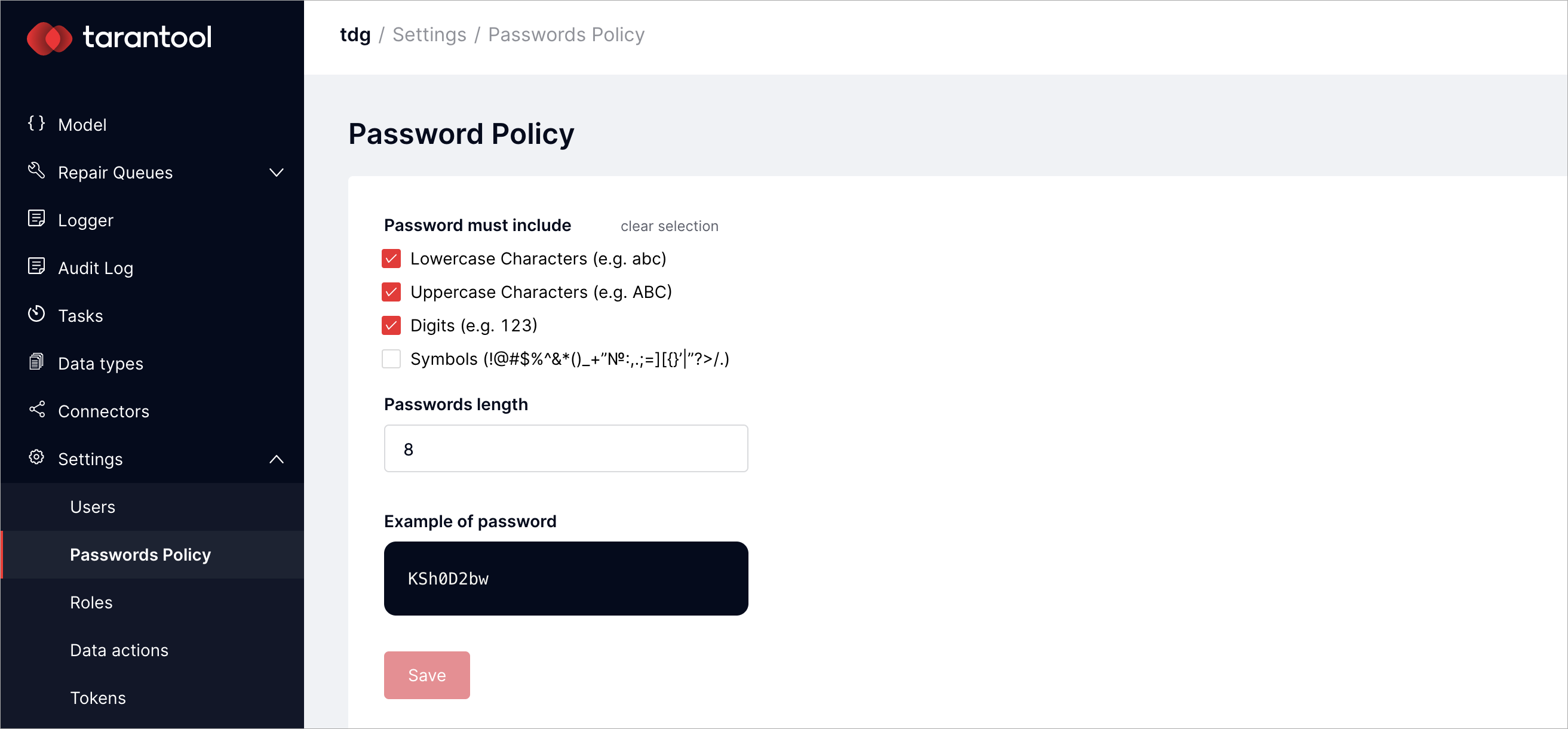

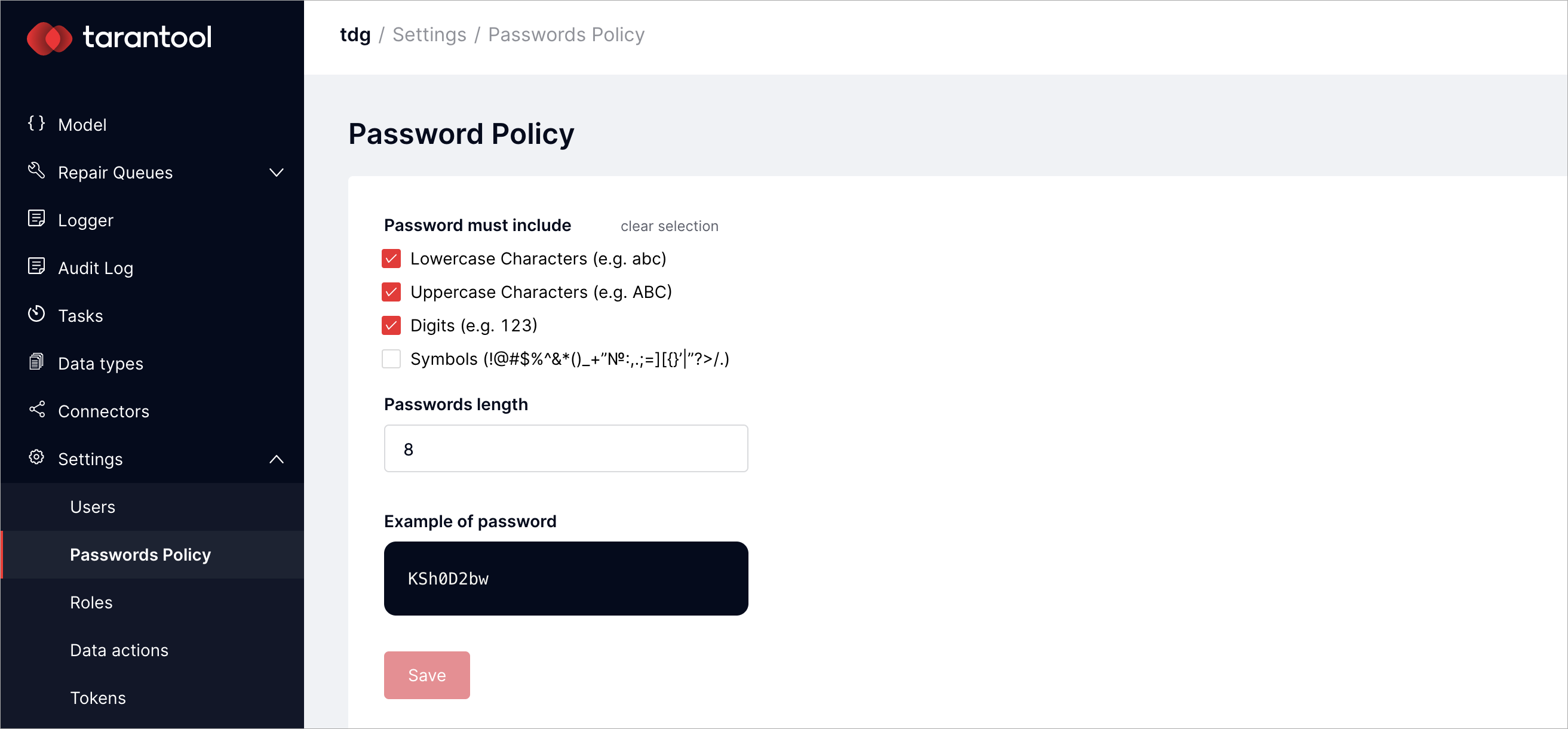

Авторизацию пользователей в системе регулирует политика TDG в отношении

паролей. Она применима в равной степени как к паролям, которые пользователи

задают вручную, так и к автоматически сгенерированным паролям. Управлять

политикой в отношении паролей можно на вкладке Settings > Password Policy:

Согласно настройкам по умолчанию пароль должен содержать буквы в нижнем и

верхнем регистре, а также цифры от 0 до 9. Вы можете изменить настройки по

умолчанию и сохранить их, нажав Save.

Токены приложений

Токен приложений – уникальный идентификатор, который генерируется в кластере TDG.

Такой токен служит средством авторизации внешних приложений для взаимодействия с данными и функциями TDG.

Администратор создает токен, назначает для него нужные права доступа к объектам

TDG и передает его разработчикам внешней системы.

Доступны два способа управления токенами приложений – в веб-интерфейсе TDG и

через GraphQL API.

Токен приложений также используется для авторизации HTTP-запросов и авторизации коннекторов.

Подробнее об этих процедурах рассказывается в разделе Авторизация Руководства разработчика.

Управление токенами в веб-интерфейсе

Добавление токена

Сгенерировать токен через веб-интерфейс можно на вкладке Settings > Tokens:

Нажмите кнопку Add token.

В диалоговом окне Create token укажите следующие параметры:

Name: имя (ключ) токена, по которому он будет идентифицироваться в системе;

Expires in: срок действия токена (опционально).

Чтобы создать токен без срока действия, оставьте поле пустым;

Role: роль токена. Аналогична роли пользователя в ролевой модели доступа;

Нажмите кнопку Submit, чтобы сгенерировать токен. В веб-интерфейсе появится сообщение,

где токен будет представлен в явном виде:

Важно

Сохраните созданный токен в надежном месте.

В целях безопасности токен в явном виде показывается только один раз, при его генерации.

Сообщение с токеном исчезнет, как только вы покинете данную страницу или создадите новый токен.

Имя созданного токена редактировать невозможно. Однако вы можете изменять роль токена и его срок

действия.

Как и профили пользователей, токены приложений в веб-интерфейсе можно удалять, блокировать,

экспортировать и импортировать.

Удаление токена

Администратор может удалить из списка любой токен приложения. Для этого:

Найдите нужный токен в колонке Actions. В меню действий

... выберите пункт Delete token.

В диалоговом окне подтвердите удаление токена, нажав кнопку OK.

Токен будет удален из общего списка автоматически.

Блокировка токена

Созданный токен будет сразу активирован в системе, для него в колонке Status появится статус ACTIVE.

Администратор может изменить этот статус и заблокировать токен:

В колонке Actions в меню действий ... выберите Block.

В диалоговом окне опишите причину блокировки токена и нажмите Block.

После этого статус токена изменится на BLOCKED.

Чтобы разблокировать токен, в меню действий ... выберите Unblock и в диалоговом окне опишите

причину разблокировки токена.

Кроме того, токен будет заблокирован автоматически (просрочен), если пользователь будет неактивен в системе дольше

определенного времени. Задать необходимое время (не более 45 дней) можно в параметре ban_inactive_more_seconds

в секции account_manager файла конфигурации.

Разблокировать просроченный токен можно, если задать для него новое значение параметра Expires in.

Экспорт и импорт токенов

Токены приложений можно экспортировать из системы и импортировать в нее в формате JSON.

Для этого на вкладке Settings > Tokens нажмите кнопку Import или Export.

Действия выполняются аналогично экспорту и импорту профилей пользователей.

Пример JSON-файла с токенами:

[

{

"expires_in": 900,

"token": null,

"state_reason": "App01 state is changed to blocked",

"uid": "jdsDAY3Y-wcwYBkdS7Kma2wyEYLwIv_qjQvxeUsFeyh0txDuqgHWmIMzLFCWp8S3GTgbxRQw7dq7Rz-k2Tddyg",

"role": "user",

"state": "blocked",

"last_login": null,

"name": "Token1",

"created_at": 1686839870157890300

},

{

"expires_in": 0,

"token": null,

"state_reason": null,

"uid": "pLQIQDvHvGsymbfI1jt37BUhYLuZOzWNSB8kbDoWDx4mwYLDEdJFz-pUwK7mASyojYl-O83t1Iqtqr4HUGyKbQ",

"role": "user",

"state": "active",

"last_login": null,

"name": "App02",

"created_at": 1686927801987245300

}

]

Управление токенами через GraphQL API

Токенами приложений в TDG можно управлять с помощью GraphQL-запросов на изменение настроек, используя

протокол HTTP.

HTTP-запросы при этом должны иметь заголовок схемы admin и соответствующий заголовок

для авторизации.

Подробнее о таких запросах рассказывается в разделе Управление настройками через GraphQL API.

Пример выполнения curl-запроса на изменение настроек можно найти на странице

Авторизация Руководства разработчика.

Используя GraphQL API, можно выполнять следующие действия:

Все операции, относящиеся к токенам, выполняются внутри блока token {}.

Полный список параметров запросов и их описание приведены на странице Основные настройки TDG.

Чтение информации о токенах

Чтобы вывести список всех токенов приложения, используйте запрос list (query):

query {

token {

list {

name

}

}

}

Чтобы вывести информацию о токене по его имени, используйте запрос get (query):

query {

token {

get(name: "Token1")

{

name

expires_in

created_at

uid

role

state

unblocked_at

state_reason

last_login

}

}

}

Добавление токена

Для создания токена приложения используйте запрос add (mutation):

mutation {

token {

add(

name: "App01"

expires_in: 0

role: "user"

) {

name

token

created_at

}

}

}

При успешной генерации токена система возвращает ответ с указанием токена в явном виде в параметре token:

{

"data": {

"token": {

"add": {

"name": "App01",

"token": "b773dbec-b86b-41aa-5541-887ba722c62e",

"created_at": 1567758613669985599

}

}

}

}

Важно

Сохраните созданный токен в надежном месте.

В целях безопасности токен в явном виде показывается только один раз, при его генерации.

При повторных запросах существующего токена система возвращает его только в виде хеша.

При попытке повторно создать токен с уже существующим именем система возвращает сообщение об ошибке.

Редактирование токена

Изменить можно только срок действия токена и его роль.

Для редактирования токена приложения используйте запрос update (mutation):

mutation {

token {

update(

name: "App01"

expires_in: 25000

role: "admin"

) {

name

expires_in

role

}

}

}

Блокировка токена

Для изменения статуса токена приложения используйте запрос set_state (mutation):

mutation {

token {

set_state(

name: "App01"

state: "blocked"

) {

name

role

state

}

}

}

Кроме того, токен будет заблокирован автоматически (просрочен), если пользователь будет неактивен в системе дольше

определенного времени. Задать необходимое время (не более 45 дней) можно в параметре ban_inactive_more_seconds

в секции account_manager файла конфигурации.

Разблокировать просроченный токен можно, если задать для него новое значение параметра Expires in.

Импорт токена

Для импорта токена приложения используйте запрос import (mutation):

mutation {

token {

import(

uid: "9d9fec89-c1f0-467f-b756-156fe9d29840"

name: "App02"

expires_in: 2592000

role: "admin"

state: "active"

created_at: 1686927801987245300

) {

name

uid

}

}

}

Удаление токена

Для удаления токена приложения используйте запрос remove (mutation):

mutation {

token {

remove(name: "App01") {

name

created_at

role

}

}

}

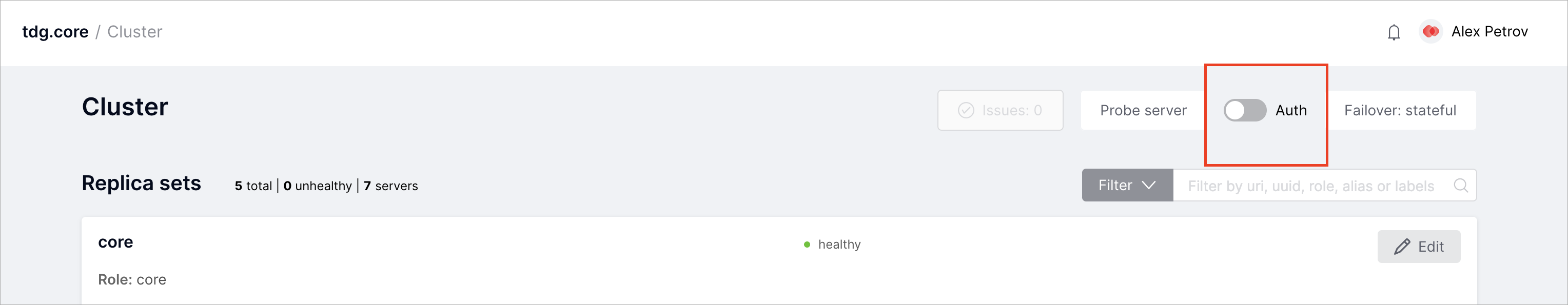

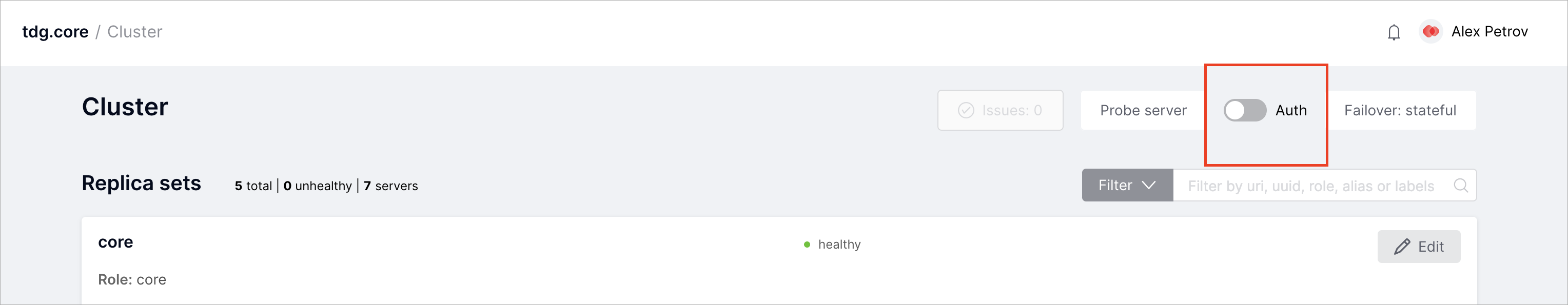

Режим обязательной аутентификации

Сразу после развертывания TDG любые анонимные пользователи и внешние

приложения могут получать неавторизованный доступ ко всем функциям и данным,

что ненадежно с точки зрения безопасности. Поэтому в TDG появляется

соответствующее предупреждение.

Чтобы включить режим обязательной аутентификации, выполните следующие шаги:

Создайте профиль пользователя с ролью «admin».

Войдите в систему под учетной записью этого пользователя.

На вкладке Cluster нажмите кнопку-переключатель Auth.

В диалоговом окне Authorization нажмите Enable.

Режим обязательной аутентификации включен.

Теперь пользователи могут входить в систему, используя

логин и пароль. В интерфейсе TDG пользователю предоставляется доступ к

определенным вкладкам. Набор вкладок зависит от роли пользователя.

Чтобы предоставить авторизованный доступ к данным и функциям TDG

внешнему приложению, используйте токены приложений.

Авторизация внешних пользователей и систем через LDAP

TDG поддерживает технологию единого входа

(Single Sign-On)

– механизм аутентификации, позволяющий пользователям получать доступ к нескольким приложениям и сервисам c

одним набором учетных данных.

Это означает, что авторизоваться в TDG можно как через пользователей и

токены приложений, так и с использованием такого внешнего инструмента, как LDAP.

LDAP (Lightweight Directory Service Protocol) – открытый протокол

для хранения и получения данных из службы каталогов.

LDAP позволяет централизованно настраивать права доступа к данным.

В TDG доступны три способа настройка протокола LDAP:

В этом руководстве рассмотрим первые два способа настройки протокола.

Для выполнения примера требуются:

Примечание

Для локального тестирования LDAP-авторизации можно использовать сервер GLAuth.

Гарантируется работа с версией GLAuth 2.0.0

Руководство включает в себя следующие шаги:

По умолчанию, логин в систему – это строка вида user@domain, где:

Пример: tdguser@my.domain.ru.

Если подключена Active Directory, служба каталогов Microsoft,

для входа в систему используется адрес электронной почты пользователя LDAP.

В качестве фильтра при этом используется атрибут Active Directory userprincipalname=email,

где email – адрес электронной почты пользователя.

Каждый пользователь LDAP состоит в одной или нескольких группах LDAP (domain group).

Группе LDAP задается определенная роль (например, admin), которая определяет

права доступа для пользователя из этой группы.

Если пользователь LDAP состоит сразу в нескольких группах, он получает разрешения на действия из всех ролей, заданных

для этих групп.

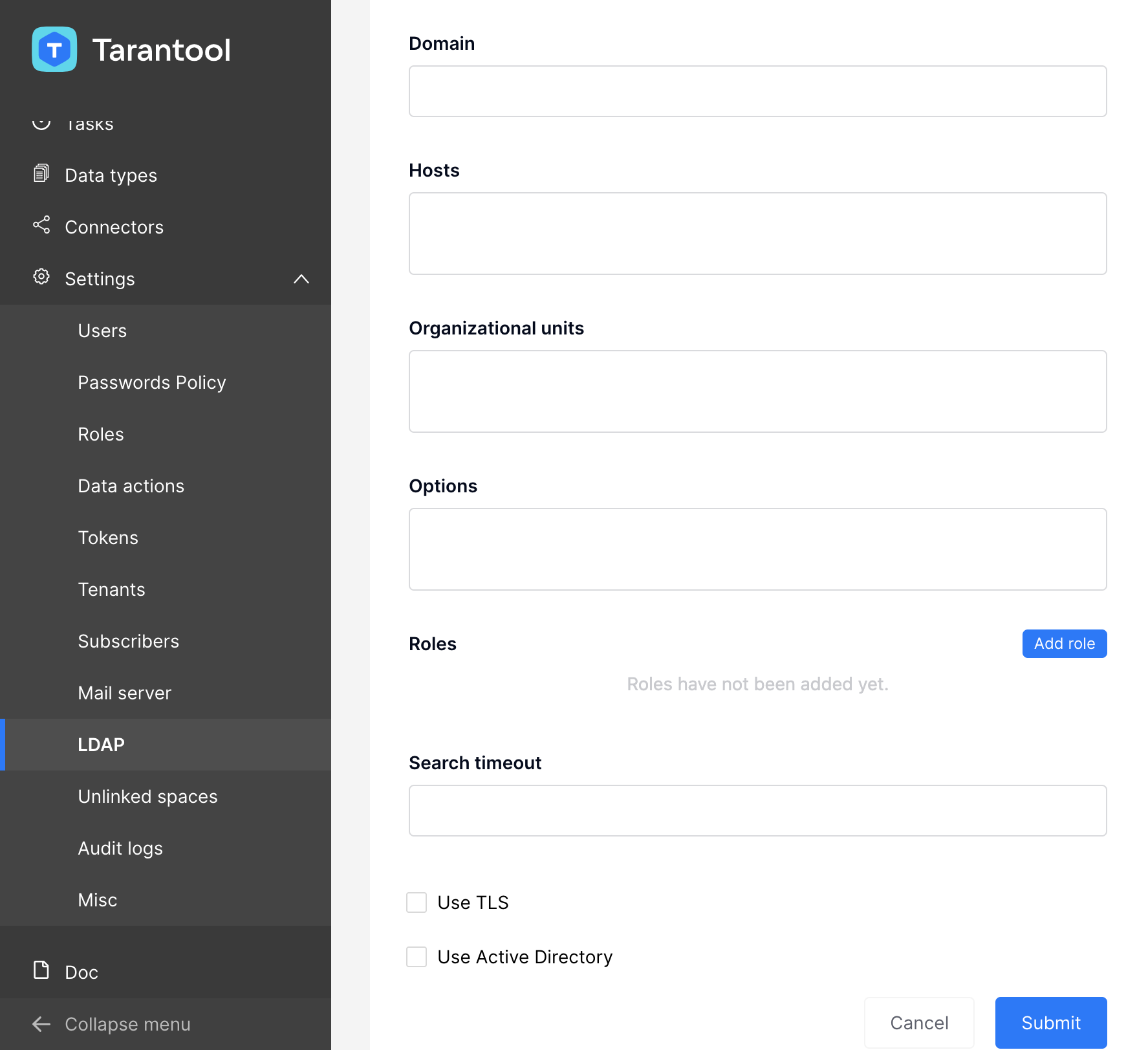

Добавим новую конфигурацию LDAP через веб-интерфейс TDG.

На вкладке Settings > LDAP нажмите кнопку Add Configuration.

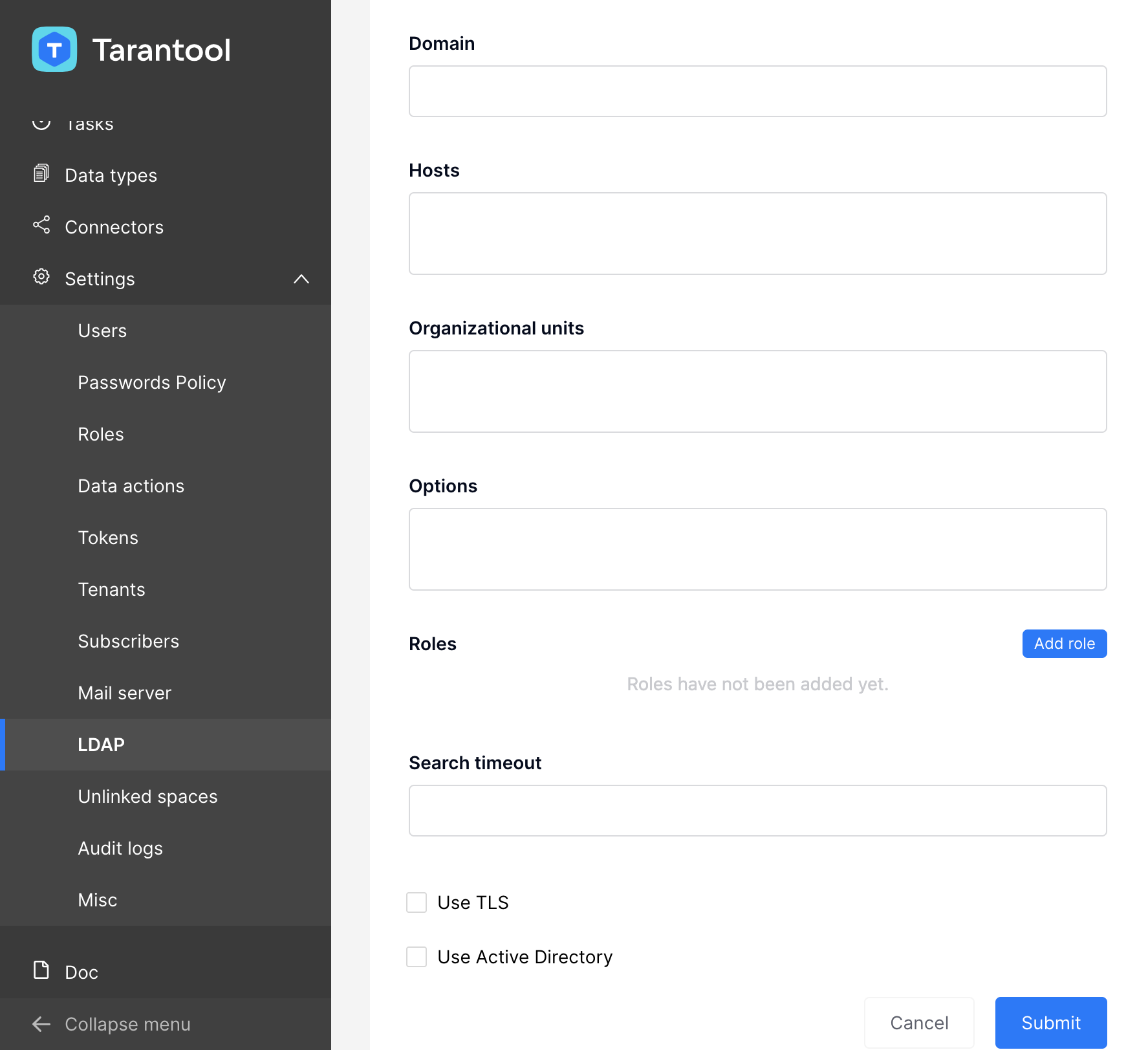

В диалоговом окне LDAP укажите параметры, необходимые для вашей конфигурации:

Domain – доменное имя, используемое в доменном логине пользователя (tdguser@my.domain.ru).

Пример: my.domain.ru;

Hosts – адрес подключения к серверу LDAP. Пример: server.my.domain.ru:389;

Organizational units (опционально) – названия организационных подразделений или групп пользователей.

Параметр будет пропущен, если для него не задано явное значение. Пример: tarantool;

Options (опционально) – настройки LDAP. Параметр будет пропущен, если для него не задано явное значение;

Roles – описание ролей, которые будут назначаться пользователю в зависимости от групп LDAP, в которых он

состоит. Для каждой роли описаны название роли и соответствующие ей LDAP-группы.

Описание LDAP-группы состоит из общего имени (CN), названия организационного подразделения или LDAP-группы (OU)

и компонентов домена (DC).

Пример: добавьте роль admin. Для нее в поле Domain Groups укажите значение

CN=tarantool, OU=groups, OU=other_groups, DC=my, DC=domain, DC=ru;

Search timeout (опционально) – время ожидания ответа от сервера LDAP в секундах.

Значение по умолчанию: 2;

Use TLS (опционально) – использование TLS.

Значение по умолчанию: false;

Use Active Directory (опционально) – использование Active Directory.

Значение по умолчанию: false.

При настройке обратите внимание на параметры domain и organizational_units.

Эти параметры используются при аутентификации для поиска пользователя в соответствующем домене и организационном подразделении.

Полное описание параметров LDAP приведено в разделе ldap справочника конфигурации.

Нажмите кнопку Submit, чтобы добавить конфигурацию LDAP.

Чтобы войти в систему как пользователь LDAP, нажмите кнопку Log in в правом верхнем углу.

В диалоговом окне Authorization введите логин (вида user@domain) и пароль пользователя LDAP, затем

нажмите кнопку Login.

Указать конфигурацию LDAP можно:

Полное описание параметров LDAP приведено в разделе

ldap справочника конфигурации.

Пример конфигурации с включенными TLS и Active Directory:

ldap:

- domain: 'my.domain.ru'

organizational_units: ['tarantool']

hosts:

- server.my.domain.ru:389

use_active_directory: true

use_tls: true

search_timeout: 2

options:

- LDAP_OPT_X_TLS_CACERTFILE: /certs/CA_Root.crt

roles:

- domain_groups:

- 'cn=tarantool,ou=groups,ou=other_groups,dc=my,dc=domain,dc=ru'

role: 'admin'

Созданный yml-файл с настройками конфигурации нужно упаковать в zip-архив и загрузить

в TDG согласно инструкции.

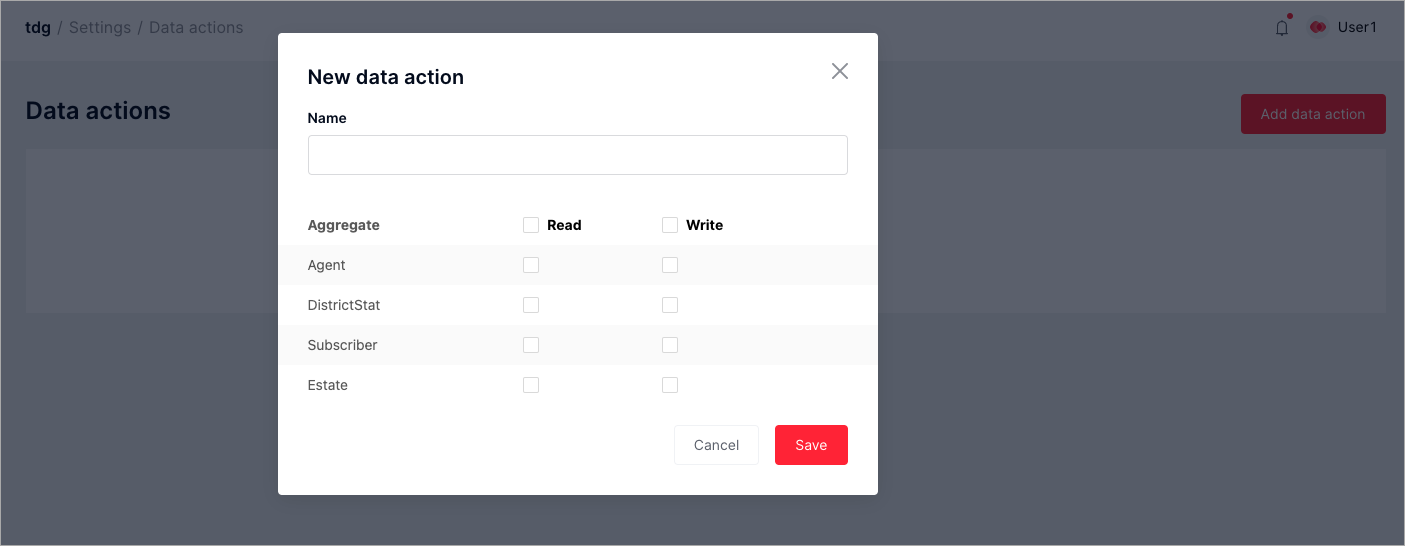

Настройка профилей доступа

TDG позволяет управлять правами пользователей на чтение и запись данных,

обрабатываемых и хранимых в системе. Чтобы роль пользователя получила права

доступа к данным, создайте в веб-интерфейсе профиль доступа (data action) и

назначьте этот профиль для нужной роли.

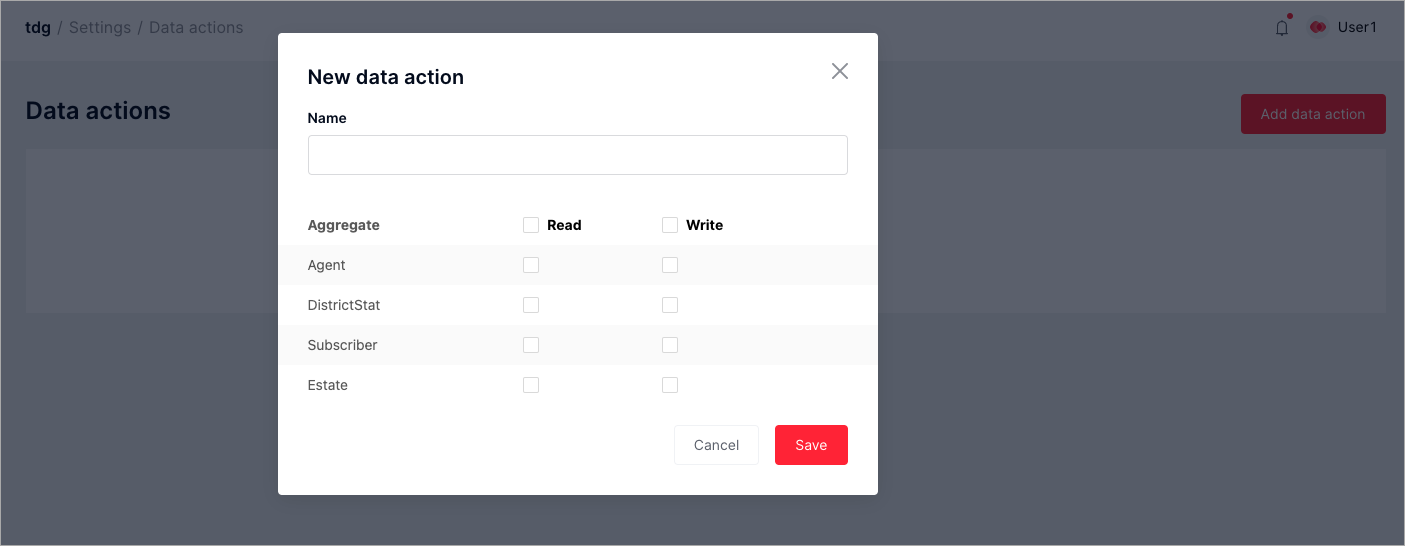

Чтобы создать новый профиль доступа, выполните следующие шаги:

Откройте вкладку Settings > Data actions.

Нажмите Add data action.

В диалоговом окне New data action задайте имя профиля доступа в поле

Name и выберите права Read/ Write для каждого агрегата в списке

Aggregate:

Нажмите Save, чтобы сохранить профиль доступа.

Создав профиль доступа, вы можете отредактировать любой его параметр.

Профиль доступа можно привязать к любой роли пользователя, созданной

администратором. Исключения составляют роли по умолчанию, поскольку их

нельзя редактировать.

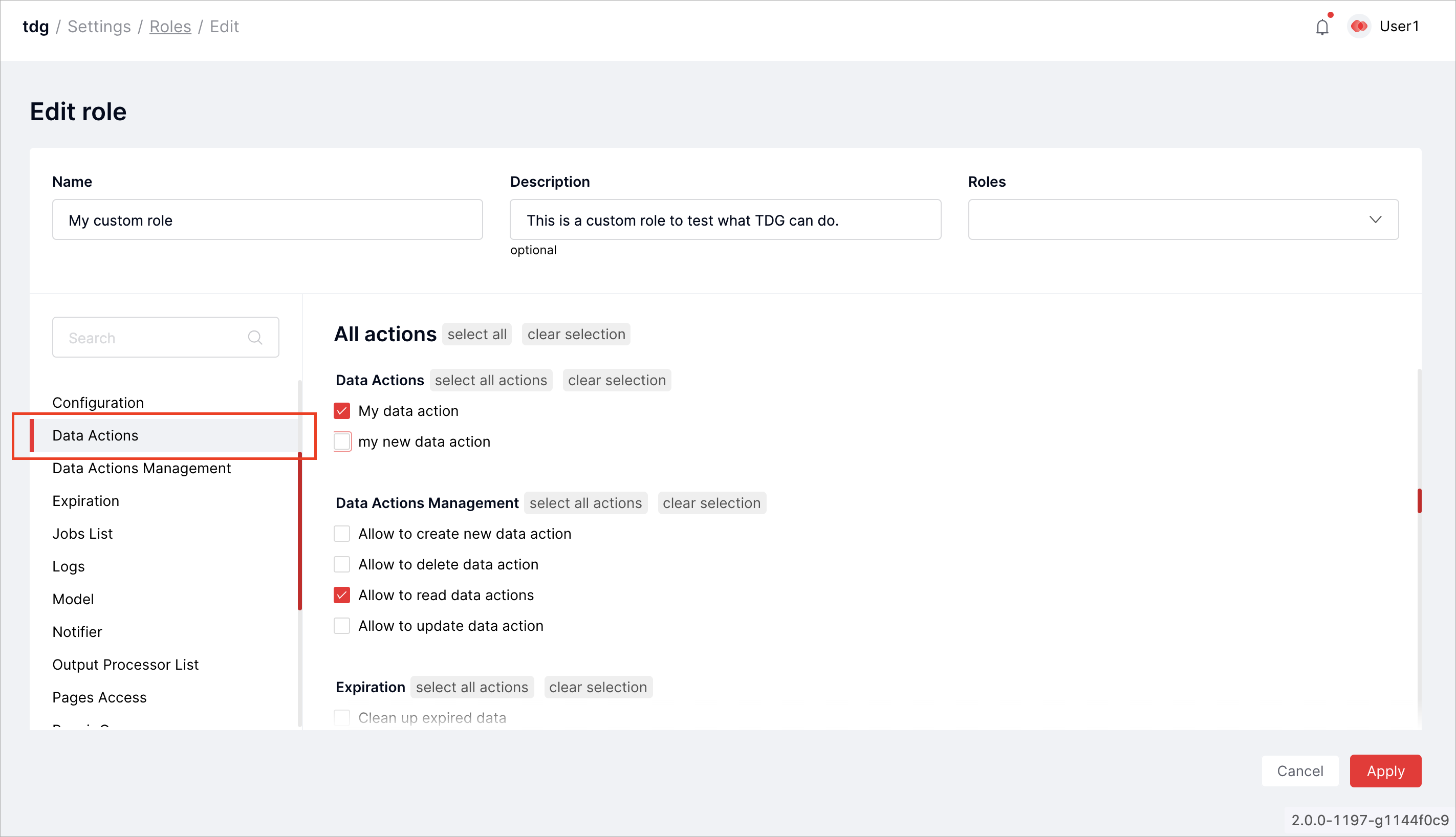

Чтобы привязать профиль доступа к роли пользователя, выполните следующие шаги:

Откройте вкладку Settings > Roles.

В списке ролей выберите роль, которую хотите отредактировать, и нажмите на значок карандаша.

В списке действий найдите раздел Data actions и выберите нужный профиль доступа:

Нажмите Apply.

Вы также можете привязывать профили доступа, когда создаете новую роль.

Чек-лист безопасности

Эта глава поможет проверить, безопасно ли настроена система Tarantool Data

Grid. В главе объясняется ряд принципов безопасности, а также

рассказывается, почему они важны и как проверить систему на соответствие им.

Журнал аудита

Журнал аудита содержит записи о событиях безопасности в TDG.

Чтобы посмотреть журнал, нужно:

Сконфигурировать хотя бы один экземпляр с ролью storage.

Включить шардирование кнопкой Bootstrap vshard на вкладке

Cluster.

Перейти на вкладку Audit log.

Включение и выключение журнала аудита

По умолчанию журнал аудита включен и ведется независимо от настроек

авторизации.

Отключить ведение журнала аудита можно, нажав на вкладке Audit log

кнопку Disable logging. Можно также выполнить на вкладке

Graphql следующий запрос:

mutation {

audit_log {

enabled(value: false)

}

}

Чтобы проверить, включен ли журнал аудита, выполните следующий GraphQL-запрос:

query {

audit_log {

enabled

}

}

Очистка журнала аудита

Журнал аудита хранится в memtx и автоматически не очищается.

Полностью очистить спейс с журналом аудита можно следующей командой GraphQL:

mutation {

audit_log {

clear

}

}

Структура

Каждая запись в таблице предоставляет следующую информацию о событии:

Severity (Важность)

From - To (С - По)

Subject ID (ID субъекта)

Subject (Субъект)

Request ID (ID запроса)

Module (Модуль)

Message (Сообщение)

По каждому из параметров журнал аудита можно фильтровать. Подробности о

параметрах можно прочитать ниже.

Severity

Возможные значения (в порядке возрастания важности):

При фильтрации по параметру Severity будут отображаться события, уровень

важности которых совпадает с выбранным или выше него. Чтобы показать все

сообщения, выберите фильтр по параметру VERBOSE.

From - To

Дата и время события. Время отображается в часовом поясе GMT+0 (или UTC).

Subject ID

Внутренний идентификатор субъекта доступа.

Subject

Тип и наименование субъекта доступа. Возможные значения:

system %q: системное сообщение, где %q – имя сущности в системе.

token %q: доступ к HTTP API при помощи токена приложения (например, чтобы получить

данные GraphQL), где %q – имя сущности, запросившей доступ.

user: попытка доступа из GUI.

anonymous: попытка доступа из GUI при отключённой обязательной

«авторизации.

unauthorized: попытка неавторизованного доступа из GUI.

Request ID

Внутренний идентификатор запроса.

Module

Имя модуля системы, инициировавшего событие.

Пример: модуль common.admin.auth отвечает за авторизацию.

Message

Описание события. Может быть пользовательским сообщением.

Примеры

Успешная авторизация пользователя